(강의정리) 확률 및 통계

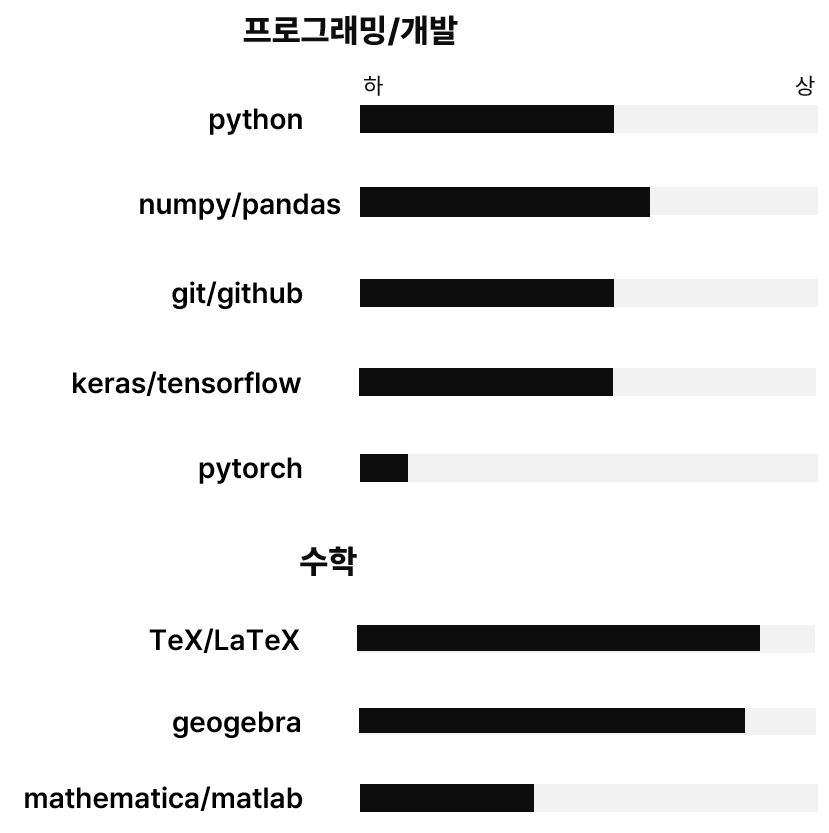

이 포스트는 한양대학교 이상화 교수님의 「확률 및 통계」 강의에 대한 요약입니다. 이 강의는 총 21강으로 되어 있고 확률과 통계에 관한 전반적인 사항을 다루는 것 같습니다.

강의 내용을 아주 자세하게는 적지 않고 간략하게만 적어나갈 예정입니다. 깔끔하게 적으려다보면 시간이 많이 걸리거나, 아예 안하게 되는 경우도 있어서, 조금 간단하게 적게 될 것 같습니다. 그래도 쓰고 고치고 하다보면 잘 정리될 수도 있을 것 같습니다.

기본적으로는 강의의 내용을 따라가지만, 강의의 내용만으로는 다 채워지지 않는 부분들이 있습니다. 예를 들어, 강의에서는 증명이 생략되는 경우도 많고, 개념의 의미가 완벽하게 설명되지 않는 경우도 있습니다. 이런 미흡한 부분은 다른 여러 자료들에서 채워넣으려고 했습니다.

강의의 회차를 나타낼 때에는 꺽쇠괄호를 사용했습니다. 예를 들어 $\langle02\rangle$라고 쓰면 이것은 2회차 강의 내용 또는 2회차 강의의 정리를 뜻합니다. 중요한 식을 나타낼 때에는 $(\ast)$, $(\ast\ast)$, $(\ast\ast\ast)$와 같은 기호를 사용했습니다. 이 식번호는 회차마다 초기화됩니다.

21강의 내용을 모두 한 포스트에 넣으려다보니 내용이 상당히 방대합니다. 그래서, 페이지의 모든 수식이 완전히 조판되는 데에는 약간의 시간(1분)이 걸립니다.

일단 17강까지의 내용에 대해서는 다 정리해보았습니다. 18강부터의 내용은 일단 보류합니다. 이정도에서 매듭을 짓고, 나중에 시간이 나면 뒷부분도 채우든지 하겠습니다.

01 조건부확률과 Bayes 정리

(1) sample space

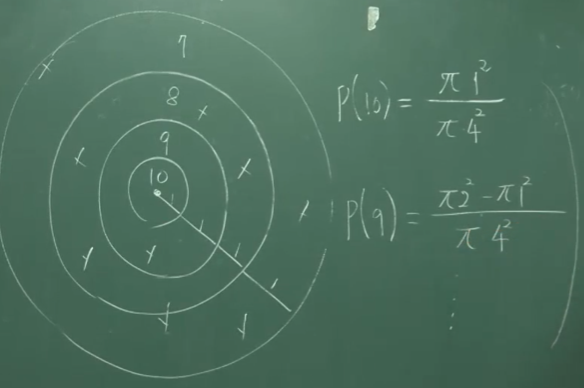

확률에 대해 공부할 때 가장 먼저 배우는 것은 당연히 표본공간(sample space)입니다. 고등학교 이후의 과정에서 확률은 항상 집합의 관점에서 이해됩니다. 표본공간 또한 집합으로, 보통 $S$로 적습니다. 표본공간이란 어떤 시행(trial)에 대하여

나타날 수 있는 가능한 모든 결과(outcome)들의 집합

을 말합니다. 이러한 결과들은 근원사건(elementary event)이라고도 불립니다.

예를 들어, 주사위를 하나 던지는 시행을 한다면

\[S=\{1,2,3,4,5,6\}\]이고, 동전을 하나 던지는 시행을 한다면

\[S=\{H,T\}\]입니다.

(2) event, probability

확률은 보통 $P(A)$로 표시하는데, 여기에서 $A$는 사건(event)이라고 부릅니다. 이때, 사건은 $S$의 부분집합입니다. ($A\subset S$)

\[P(A)=\text{the probability that the outcome belongs to $A$}\]예를 들어, 주사위를 한 번 던지는 시행에서 짝수 눈이 나올 사건을 $A$라고 하면

\[A=\{2,4,6\}\]이고, $5$가 나오는 사건을 $B$라고 하면

\[B=\{5\}\]입니다. 이때, $A\subset S$, $B\subset S$인 것입니다.

강의에서 ‘사건’에 대한 설명은 여기까지입니다. 더 나아가, 사건을 엄밀하게 정의하려먼 $\sigma$-algebra라는 개념을 도입해야 합니다. 사건은 $S$의 부분집합이라고 했지만, 모든 $S$의 부분집합이 사건은 아닐 수도 있습니다.

$\Sigma$가 $S$의 부분집합들의 집합이면서 다음의 세 성질들을 만족시키면 $\Sigma$를 $\sigma$-algebra라고 부릅니다. 그리고 $\Sigma$의 원소를 사건으로 정의합니다.

- $\Sigma$는 $S$를 원소로 가집니다 ; $S\in\Sigma$

- $\Sigma$는 차집합에 대해 닫혀있습니다 ; $A,B\in\Sigma$이면 $A-B\in\Sigma$입니다.

- $\Sigma$는 countable union에 대해 닫혀있습니다 ; $A_1,A_2,\cdots\in\Sigma$이면, $\bigcup_iA_i\in\Sigma$입니다.

따라서 $\varnothing$과 $S$는 항상 사건입니다. 이때, $\varnothing$을 공사건, $S$를 전사건이라고 부릅니다.

배반사건

두 사건 $A$와 $B$가

\[A\cap B=\varnothing\]이면, $A$와 $B$가 서로 배반사건(exclusive events)이라고 말합니다. 이것은 두 집합이 서로소(disjoint)인 것과 대응되는 개념입니다.

세 개 이상의 사건들에 대해서는 배반이라는 말이 두 가지의 의미를 가지게 됩니다. $A$, $B$, $C$가 사건일 때,

\[A\cap B\cap C=\varnothing\]이면, 세 사건이 mutually exclusive하다고 말합니다. 만약

\[A\cap B=\varnothing \quad\&\quad B\cap C=\varnothing \quad\&\quad C\cap A=\varnothing\]이면, 세 사건이 pairwisely exclusive하다고 말합니다. 일반적으로, 사건 $A_1$, $A_2$, $\cdots$, $A_n$에 대하여

\[A_1\cap A_2\cap\cdots\cap A_n=\varnothing\]이면, $A_i$들이 mutually exculsive하다고 말하고,

\[i\neq j\quad\Rightarrow\quad A_i\cap A_j=\varnothing\]이면, $A_i$들이 pairwisely exclusive하다고 말합니다.

확률

한편, $P$는 확률측도(probability measure)라고 불립니다. 확률측도란 전사건에 대한 측도가 1인 measure(측도)를 말합니다. 다시 말해, 다음 세 성질을 만족시키는 $P$를 probability measure라고 부릅니다.

- $P$는 $P:\Sigma\to[0,1]$인 함수입니다.

- $P$는 countably additive합니다 ; $A_i\in\Sigma$가 서로 배반사건일 때 $P\left(\sum_{i=1}^\infty A_i\right)=\sum_{i=1}^\infty P(A_i)$

- $P(\varnothing)=0$, $P(S)=1$ 입니다.

예를 들어, 주사위를 하나 던지는 시행에서 $\Sigma$를 $S$의 멱집합(power set, $S$의 모든 부분집합들의 집합)이라고 하고 $P$를

\[P(A) =\frac{n(A)}{n(S)}\]로 정의하면, $\Sigma$는 $\sigma$-algebra이고 $P$는 probability measure입니다. (단, 유한집합 $X$에 대하여 $n(X)$는 그 집합의 원소의 개수입니다.)

이렇게 정의한 $P$는 보통 주사위 문제를 풀 때 사용해왔던 그 $P$와 의미가 일치합니다. 아까 $A=\{2,4,6\}$, $B=\{5\}$로 두었었는데, $A\in\Sigma$, $B\in\Sigma$이고

\[\begin{align*} P(A)&=\frac{n(A)}{n(S)}=\frac36=\frac12\\ P(B)&=\frac{n(B)}{n(S)}=\frac16 \end{align*}\]이기 때문입니다.

(3) coditional probability

두 사건 $A$, $B$에 대하여 사건 $A$가 발생했을 때 사건 $B$도 발생할 확률을 $P(B|A)$라고 쓰고,

\[P(B|A)=\frac{P(B\cap A)}{P(A)}\]로 정의합니다.

이것은 마치, $A$를 sample space로 보는 것과 같습니다. 마찬가지로, 일반적인 확률 $P(A)$도 $P(A|S)$와 같이 해석할 수 있습니다.

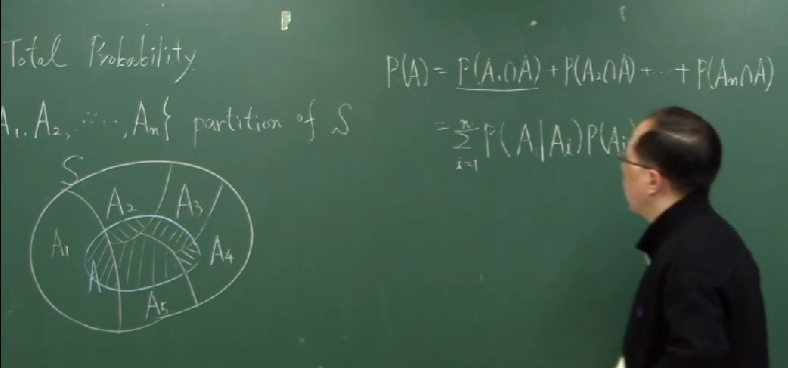

(4) law of total probability

사건 $A_1$, $\cdots$, $A_n$에 대하여, $A_i$들이 pairwisely exclusive하고 $A_i$들의 합집합이 $S$이면, 다시 말해

\[i\neq j\quad\Rightarrow\quad A_i\cap A_j=\varnothing\]이고,

\[A_1\cup A_2\cup\cdots\cup A_n=S\]이면, $A_1$, $\cdots$, $A_n$가 $S$의 partition(분할)이라고 말합니다.

만약, $A_1$, $\cdots$, $A_n$가 $S$의 partition이고, $B$가 사건이면 다음과 같은 식이 성립합니다.

\[\begin{align*} P(A) &=P(A_1\cap A)+\cdots+P(A_n\cap A)\\ &=\sum_{i=1}^nP(A_i\cap A)\\ &=\sum_{i=1}^nP(A|A_i)P(A_i) \end{align*}\]

(5) Bayesian theorem

조건부확률의 식으로부터

\[P(B|A)=\frac{P(A|B)P(B)}{P(A)}\tag{$\ast$}\]입니다. 만약 $P(B|A)$를 직접적으로 구하기가 어렵지만, $P(A_i|B)$는 구하는 것이 상대적으로 쉽고, $A_1$, $\cdots$, $A_n$이 partition을 이룰 경우에 Bayesian theorem이 자주 쓰입니다. 이때, $(\ast)$의 우변 분모인 $P(A)$는 law of total probability에 의해 구할 수 있습니다. 이것은 아래의 예를 통해 보면 확인할 수 있습니다.

- $P(B|A)$ : posterior, 사후확률

- $P(B)$ : prior, 사전확률

- $P(A|B)$ : likelihood, 우도

Bayesian theorem이 활용되는 경우는 대표적인 경우는 $P(B|A)$에서 $A$가 observation data (output)에 대응되고 $B$가 original data (input)에 대응될 때입니다. 어떤 input이 주어졌을 때 어떤 output이 나올 확률은 보통 인과관계나 선후관계를 잘 따지면 계산할 수 있지만, 어떤 output이 나왔을 때 input이 그 값으로 주어졌을 확률, 즉 반대 경우는 해석하기 어렵고 계산하기 어렵습니다. 그런 경우에 $A$와 $B$의 위치를 바꾸어서, 계산하는 트릭이 Bayesian rule입니다.

ex. 1.7 binary symmetric channel

데이터를 전송하는 어떤 기기가 transmitter와 receiver로 이루어져있다고 하겠습니다. input data와 output data가 binary인 경우에 이 구조를 binary channel이라고 한다고 합니다.

\[\begin{align*} \text{input symbols} &\in \{x_1,x_2\}&& \text{transmitter}\\ \text{output symbols} &\in \{y_1,y_2\}&& \text{receiver} \end{align*}\]이상적인 상황은, $x_1$이 입력되었을 때 $y_1$이 잘 출력되는 경우와 $x_2$가 입력되었을 때 $y_2$가 잘 출력되는 경우입니다. 각각의 경우는 $P(y_1|x_1)$, $P(y_2|x_2)$이 큰 값으로 나타나는 경우에 해당합니다. 생각할 수 있는 네 개의 확률값들을 각각

\[\begin{align*} P_{11} = P(y_1|x_1)\\ P_{12} = P(y_2|x_1)\\ P_{21} = P(y_1|x_2)\\ P_{22} = P(y_2|x_2) \end{align*}\]로 표기하겠습니다. (마치 행렬같습니다.)

만약 $P_{11}=P_{22}$이고 $P_{12}=P_{21}$이 성립하면 이 binary channel을 binary symmetric channel이라고 부릅니다. (따라서 행렬이 symmetric한 것과는 다릅니다.) 당연히

\[\begin{align*} P_{11}+P_{21}=1\\ P_{12}+P_{22}=1 \end{align*}\]이 성립합니다. 강의에서는 세 종류의 계산을 해보는데, 첫번째 계산은 law of total probability와 연관이 있고, 두번째와 세번째 계산은 Bayesian theorem과 연관이 있습니다.

(1) error가 발생할 확률

오류라고 판단할 수 있는 경우는 input이 $x_1$로 들어갔는데 output이 $y_2$로 나오는 경우와 그 반대(vice versa)의 경우입니다. 전자의 경우를 $\left(\{x_1\}\times S_2\right)\cap\left( S_1\times\{y_2\}\right)$로 표현해야 정확하겠지만 이것을 그냥 $x_1\cap y_2$로 쓰면

\[\begin{align*} P(\text{error}) &=P\left((x_1\cap y_2)\cup(x_2\cap y_1)\right)\\ &=P(x_1\cap y_2)+P(x_2\cap y_1)\\ &=P(y_2|x_1)P(x_1)+P(y_1|x_2)P(x_2)\\ &=P_{12}P(x_1)+P_{21}P(x_2) \end{align*}\]라고 할 수 있습니다.

(2) When $y_2$ is received, what is the probability that $x_1$ is transmitted?

$y_2$가 출력되었을 경우에, $x_1$이 입력되었을 확률을 계산합니다. Bayes rule과 law of total probability, 그리고 $P_{ij}$의 정의에 의해

\[\begin{align*} P(x_1|y_2) &=\frac{P(y_2|x_1)P(x_1)}{P(y_2)}\\ &=\frac{P(y_2|x_1)P(x_1)}{P(y_2|x_1)P(x_1)+P(y_2|x_2)P(x_2)}\\ &=\frac{P_{12}P(x_1)}{P_{12}P(x_1)+P_{22}P(x_2)} \end{align*}\]입니다. 여기에서 $y_2$는 아까 말한 observation data (output)이고 $x_1$은 original data (input)입니다.

(3) error가 발생했을 때, 입력값이 $x_1$이었을 확률

에러가 발생했을 때, 입력값이 $x_1$이었을 확률을 계산합니다.

\[\begin{align*} P(x_1|\text{error}) &=\frac{P(\text{error}|x_1)P(x_1)}{P(\text{error})}\\ &=\frac{P(\text{error}|x_1)P(x_1)}{P(\text{error}|x_1)P(x_1)+P(\text{error}|x_2)P(x_2)}\\ &=\frac{P(y_2|x_1)P(x_1)}{P(y_2|x_1)P(x_1)+P(y_1|x_2)P(x_2)}\\ &=\frac{P_{12}P(x_1)}{P_{12}P(x_1)+P_{21}P(x_2)}\\ &=\frac{P(x_1)}{P(x_1)+P(x_2)} \end{align*}\]강의에서는 위 계산이 다 완성되지 않았고, 위의 계산은 나름대로 결과를 내본 것입니다. 마지막 계산에서 이 channel이 symmetric하다는 사실($P_{12}=P_{21}$)을 사용해봤습니다.

1.8 independent events

이제 사건에 대한 독립/종속을 이야기할 수 있습니다. 강의에서는 두 개의 사건 $A$, $B$에 대한 독립(independece)만을 이야기합니다. 만약 두 사건 $A$, $B$가 서로 영향을 주지 않으면, 즉

\[P(B|A)=P(B)\]이면, 혹은

\[P(A|B)=P(A)\]이면, 두 사건 $A$, $B$가 서로 독립이라고 말합니다. $P(A)\ne0$, $P(B)\ne0$인 경우에 이 독립조건은

\[P(A)P(B)=P(A\cap B)\tag{$\ast\ast$}\]와 동치입니다. 강의에서는 $(\ast\ast)$를 독립의 정의로 사용하고 있습니다. 이후에 $\langle10\rangle$에서 확률변수들 간의 독립을 정의할 때에도 여전히 $(\ast\ast)$와 같은 식을 정의로서 활용합니다.

- 세 개 이상의 사건에 대한 독립을 말할 때는 mutually independent라는 용어를 씁니다.

- 독립의 개념은 독립시행(복원시행, repeated restored trial)을 다룰 때 중요합니다.

- 독립(independence)과 배반(exclusiveness)의 개념을 혼동하지 말아야 합니다.

- $A$와 $B$가 독립이면 $A$와 $\overline B$($B$의 여사건, complement)도 독립입니다.

1.9 combined experiments

For two experiments with sample spaces $S_1$ and $S_2$, the sample space of the combined experiments is the cartesian product $S_1\times S_2$;

동시에 일어나는 서로 다른 두 시행을 하나의 시행으로 보았을 때의 표본공간은, 각각의 시행에 대한 표본공간 $S_1$와 $S_2$의 cartesian product인 $S_1\times S_2$로 정의합니다.

\[S_1\times S_2=\{(x,y):x\in S_1,y\in S_2\}\]동전 세 개를 동시에 던지는 독립시행에서, 단일 시행에 대한 표본공간은

\[S=\{H,T\}\]이지만, combined experiments에 대한 표본공간은

\[\begin{align*} S\times S\times S &=\{H,T\}\times\{H,T\}\times\{H,T\}\\ &=\{(H,H,H),(H,H,T),(H,T,H),(H,T,T),(T,H,H),(T,H,T),(T,T,H),(T,T,T)\} \end{align*}\]입니다.

02 독립사건과 확률

1.10 combinatorial analysis

1.10.1 permutation (순열)

서로 다른 $n$개의 대상을 일렬로 나열하는 방법의 수는

\[n!=n\times(n-1)\times\cdots\times1\]입니다. $n!$은 $n$ factorial(팩토리얼)이라고 읽고, $0!=1$로 정의합니다.

서로 다른 $n$개의 대상 중 $r$개를 일렬로 나열하는 방법의 수는

\[_nP_r=\frac{n!}{r!}=n(n-1)\cdots(n-r+1)\]입니다.

1.10.2 group permutation (같은 것이 포함된 순열)

세 종류의 대상 $A$, $B$, $C$가 각각 $a$개, $b$개, $c$개 있을 때($a+b+c=n$), 이 $n$개의 대상을 일렬로 나열하는 방법의 수는

\[\frac{n!}{a!b!c!}\]입니다.

1.10.3 circular permutation (원순열)

서로 다른 $n$개의 대상을 원형으로 나열하는 방법의 수는

\[(n-1)!\]입니다.

1.10.4 combination (조합)

서로 다른 $n$개의 대상들 중 $r$개를 선택하는 방법의 수는

\[\binom nr=_nC_r=\frac{_nP_r}{r!}=\frac{n!}{r!(n-r)!}\]입니다. 이것은 ‘같은것이 포함된 순열’과 연관해서 설명될 수도 있습니다. 즉 $\binom nr$는 두 종류의 대상 $A$와 $B$가 각각 $r$개, $n-r$개 있을 때, 이 $n$개의 대상을 일렬로 나열하는 방법의 수와 같습니다.

1.10.4 binomial theorem (이항정리)

\[\begin{align*} (a+b)^n&=\sum_{k=0}^n\binom nka^kb^{n-k}\\ (1+x)^n&=f(x)=\sum_{k=0}^n\binom nkx^k\\ 2^n&=f(1)=\sum_{k=0}^n\binom nk\\ 0&=f(-1)=\sum_{k=0}^n(-1)^k\binom nk \end{align*}\]이때, $\binom nk$는 $(a+b)^n$의 전개식에서 각 항의 계수(coefficient)의 역할을 한다는 점에서 이항계수(binomial coefficient)라고도 불립니다. $f(x)$를 조금 변형하면 이항분포에서의 평균과 분산 식을 계산하는 데 도움이 될 수 있습니다.

위 식의 $f(x)$를 한 번 미분하면

\[\begin{align*} n(1+x)^{n-1}=f'(x)=\sum_{k=0}^nk\binom nkx^{k-1}\\ \end{align*}\]에서

\[\begin{equation} nx(1+x)^{n-1}=\sum_{k=0}^nk\binom nkx^k\tag{$*$} \end{equation}\]이고 $f(x)$를 두 번 미분하여 정리하면

\[\begin{align*} n(n-1)(1+x)^{n-2}&=f''(x)=\sum_{k=0}^nk(k-1)\binom nkx^{k-2}\\ n(n-1)x^2(1+x)^{n-2}&=\sum_{k=0}^nk(k-1)\binom nkx^k \end{align*}\]이고 마지막 식을 $(\ast)$와 더하면

\(\begin{equation}\tag{$**$} nx(1+x)^{n-2}(1+nx)=\sum_{k=0}^nk^2\binom nkx^k \end{equation}\) 입니다.

(07강에 포함되는 내용이지만) 이산확률분포 $X$가 이항분포 $B(n,p)$를 따르면, $X$의 확률질량함수는

\[P(X=k)=\binom nkp^k(1-p)^{n-k}\]입니다. 따라서 $X$의 평균은 $(\ast)$를 사용하여

\[\begin{align*} E(X) &=\sum_{k=0}^nkP(X=k)\\ &=\sum_{k=0}^nk\binom nkp^k(1-p)^{n-k}\\ &=(1-p)^n\sum_{k=0}^nk\binom nk\left(\frac p{1-p}\right)^k\\ &\stackrel{(\ast)}=(1-p)^nn\cdot\frac p{1-p}\left(1+\frac p{1-p}\right)^{n-1}\\ &=np \end{align*}\]으로 계산됩니다. $X$의 분산은 조금 복잡한데 $(\ast\ast)$를 사용하여

\[\begin{align*} E(X) &=E(X^2)-E(X)^2\\ &=\sum_{k=0}^nk^2P(X=k)-(np)^2\\ &=\sum_{k=0}^nk^2\binom nkp^k(1-p)^{n-k}-(np)^2\\ &=(1-p)^n\sum_{k=0}^nk^2\binom nk\left(\frac p{1-p}\right)^k-(np)^2\\ &\stackrel{(\ast\ast)}=(1-p)^n\frac{np}{1-p}\left(1+\frac p{1-p}\right)^{n-2}\left(1+\frac{np}{1-p}\right)-n^2p^2\\ &=np(1-p) \end{align*}\]입니다. (잘 알려진 다른 증명보다 복잡한 것 같아서 유용한지는 잘 모르겠습니다.)

한편, 멱급수에 대해서도 재미있는 계산을 할 수 있습니다. 함수 $f(x)$를

\[f(x)=1+2x+3x^2+\cdots\]로 정의하겠습니다. 이 함수가 수렴하기 위해서는 $|x|<1$라는 조건이 있어야 합니다. 양변에 $x$를 곱하면

\[xf(x)=x+2x^2+3x^3+\cdots\]이고 두 식을 빼면

\[(1-x)f(x)=1+x+x^2+\cdots=\frac1{1-x}\]입니다.

따라서

\[f(x)=\frac1{(1-x)^2}\]입니다. 한편, 위의 결과를 다르게 얻을 수도 있는데

\[g(x)=1+x+x^2+\cdots\]라고 하면 $f(x)=g’(x)$이고 $g(x)=\frac1{1-x}$이므로

\[f(x)=\left(\frac1{1-x}\right)'=\frac1{(x-1)^2}\]인 것입니다.

1.10.6 Sterling’s formula

$n$이 충분히 크면 $n!$는 다음 값과 거의 비슷합니다.

\[\sqrt{2\pi n}\left(\frac ne\right)^n\]강의에는 이에 대한 증명이 나와있지 않은데 이 자료(Keith Conrad의 자료)에 설명과 증명이 잘 되어 있는 것 같습니다. 여기에서의 증명은 Gaussian distribution을 통한 증명과, 어떤 함수열의 수렴을 통한 증명이 소개되고 있는 것 같습니다. (언제 한 번 이것을 공부해서 포스트로 남기면 참 좋을텐데)

엄밀한 증명은 조금 어렵지만, 대략적으로 이 식의 의미를 파악하는 건 그렇게까지 어렵지 않은 것 같습니다. 어림하고자 하는 값 $n!$에 자연로그를 취하면

\[\log(n!)=\log1+\log2+\cdots+\log n\]인데, 이것은 정적분

\[\int_1^n\log x\,dx\]과 관련이 있는 값입니다. 폐구간 $1\le x\le n$를 길이가 1인 $n-1$개의 구간으로 나누면, 리만적분에서 흔히 하는 방식에 의해, 정적분의 값은 $n$개의 큰 직사각형들의 넓이의 합보다는 작고 $n$개의 (사실은 $n-1$개의) 작은 직사각형들의 넓이의 합보다는 큽니다. 즉,

\[\begin{align*} \log1+\log2+\cdots+\log(n-1)&<\int_1^n\log x\,dx<\log2+\log3+\cdots+\log n\\[10pt] \log((n-1)!)&<n\log n-n+1<\log(n!)\\[10pt] n\log n-n+1&<\log(n!)<n\log n-n+1+\log n\\[10pt] e^{n\log n-n+1}&<e^{\log(n!)}<e^{n\log n-n+1+\log n}\\[10pt] e\left(\frac ne\right)^n&<n!<en\left(\frac ne\right)^n \end{align*}\]입니다. 그러면 $n!$은 $\left(\frac ne\right)^n$이라는 값과 상당히 비슷한 값이어서

\[n!\approx\left(\frac ne\right)^n\]라는 사실과

\[n!=g(n)\left(\frac ne\right)^n\]와 같이 쓸 때 $e\lt g(n)\lt en$인 것도 알 수 있습니다. 그리고 실제 Sterling’s formula에서의 $g(n)=\sqrt{2\pi n}$이 위의 범위에 있는 것도 확인할 수 있습니다.

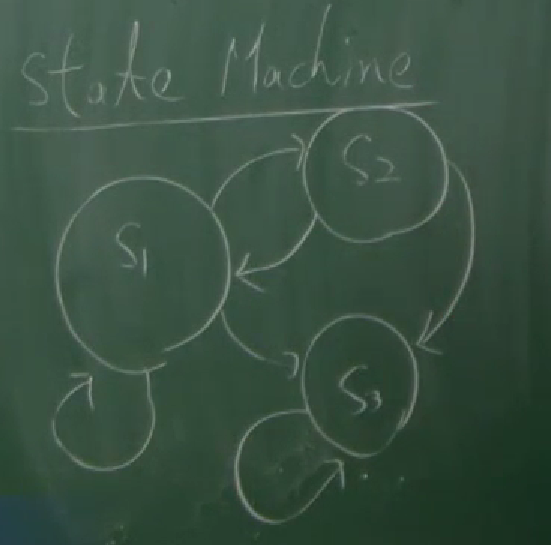

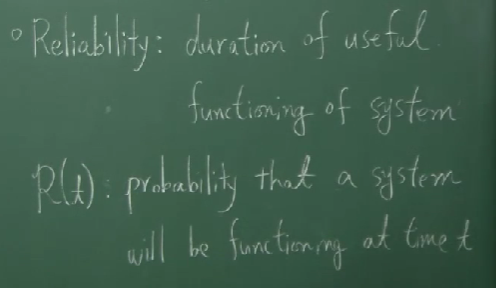

1. 11 Reliability

어떤 시스템(혹은 모듈)이 어떤 기간동안 얼마나 올바르게 고장나지 않고 잘 동작하는지를 나타내는 값을 reliability라고 합니다. 그것을 $R(t)$라고 적습니다.

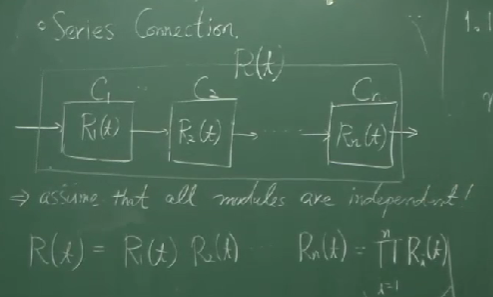

series connection(직렬연결)

여러 개의 독립적인 모듈 $C_1$, $\cdots$, $C_n$ 들이 직렬로 연결되어 있고(cascade) 각 모듈들의 reliabilty가 $R_1(t)$, $\cdots$, $R_n(t)$ 이 시스템의 reliability는

\[\prod_{i=1}^nR_i(t)\]입니다.

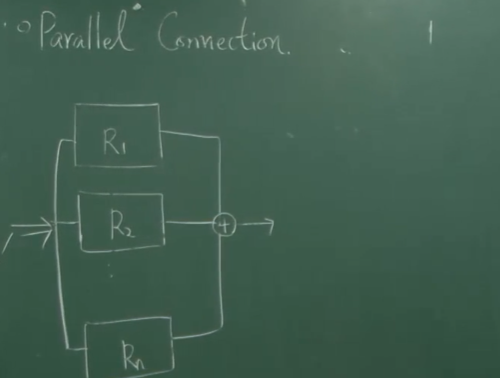

parallel connection(병렬연결)

이번에는 이 모듈들이 병렬로 연결되어 있다면 이 시스템의 reliability는

\[1-\prod_{i=1}^n\left(1-R_i(t)\right)\]입니다.

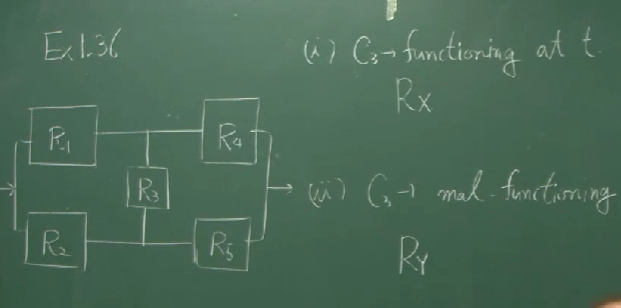

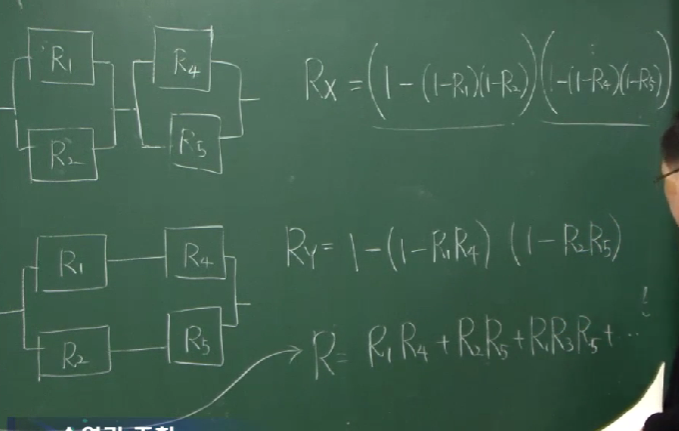

만약 위의 그림처럼 복잡한 시스템이라고 한다면, $C_3$가 동작하는지($R_x$) 동작하지 않는지($R_y$)에 따라 구분해서 얻어낼 수 있습니다. 전자의 경우에는 두 쌍의 병렬모듈들이 직렬로 연결된 것이고 후자의 경우에는 두 쌍의 직렬모듈들이 병렬로 연결된 것이라고 볼 수 있습니다.

따라서

\[\begin{align*} R =&R_x+R_y\\ =&R_3\left[\left(1-(1-R_1)(1-R_2)\right)\left(1-(1-R_4)(1-R_5)\right)\right]\\ &+(1-R_3)\left[1-(1-R_1R_4)(1-R_2R_5)\right] \end{align*}\]입니다.

03 확률변수의 정의

Chapter 2. Random Variables(확률변수)

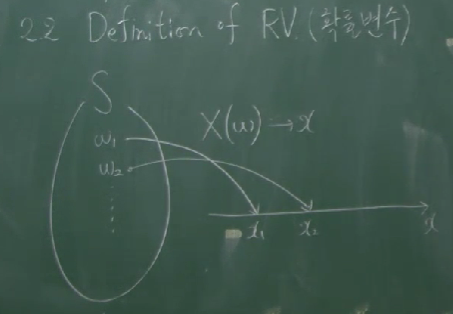

2.2 definition of random variables

언제나 확률변수의 개념을 정확히 이해하는 건 쉬운 일은 아닌 것 같습니다. 한 번 볼 때마다 완벽히 이해한다고 생각하지만, 어찌된 것인지 볼때마다 새로운 것 같습니다. 그래도 다시 한 번 강의를 보며 다시 한 번 이해해봤습니다.

확률변수란, 어떤 시행의 근원사건 $w\in S$을 하나의 실수 $X(w)$로 대응시키는 함수 $X$를 말합니다. 다시 말해, $X$가 확률변수이면, $X$는 $X:S\to\mathbb R$인 함수를 말합니다.

A random variable is a function $X$ mapping each outcome of random experiment $w\in S$ to a real number $x=X(w)$.

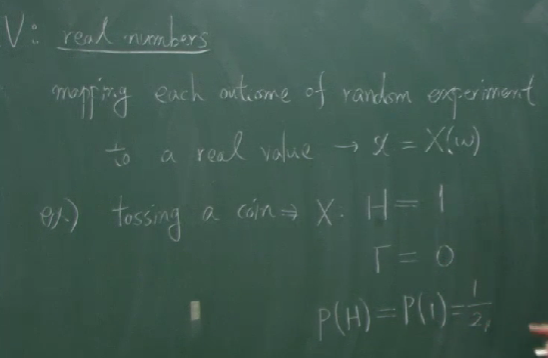

ex.1 : tossing a coin

동전을 하나 던져서 앞면이 나오면 1점을 얻고 뒷면이 나오면 $0$점을 얻는 어떤 시행에서,

동전을 하나 던졌을 때 얻는 점수

를 확률변수 $X$로 정의할 수 있습니다. 이 시행에서 $S=\{H,T\}$이고, 확률변수 $X$는 $S$에서 $\mathbb R$로 가는 함수로서

\[\begin{align*} X(H)&=1\\ X(T)&=0 \end{align*}\]를 만족하는 함수입니다. 확률변수를 사용하면 확률 $P(~\cdot~)$를 마치 숫자들의 함수로서 생각할 수 있게 됩니다. 그전까지 $P(A)$라는 표현에서 $A$는 사건(event)이라고 불렸고 표본공간 $S$의 부분집합을 의미했습니다. 그러니까 그전까지는 확률 $P(~\cdot~)$가 마치 ‘집합의 함수’처럼 동작했습니다. 그래서

\[P(\{H\})=\frac12,\quad P(\{T\})=\frac12,\quad P(\varnothing)=0,\quad P(S)=1\]와 같은 표현들을 사용할 수 있었지만 직관적인 표현은 아니었습니다.

그런데 확률변수 $X$를 도입하고 나면 $P(~\cdot~)$를 숫자들의 함수처럼 생각할 수 있습니다. $p(x)$ 혹은 $P(X=x)$라는 표현을 (이것들은 나중에 확률질량함수라는 이름을 가지게 되는데)

\[\begin{align*} p(x) &=P(X=x)\\ &=P\left(\{w\in S:X(w) =x\}\right)\tag{$\ast$} \end{align*}\]와 같이 정의하면

\[\begin{align*} p(1)&=P(X=1)=\frac12\\ p(0)&=P(X=0)=\frac12 \end{align*}\]와 같이 쓸 수 있습니다. $P$는 집합을 숫자로 대응시키는, 조금 복잡한 느낌이었지만 $p$는 숫자를 숫자로 대응시키고 있어서 다루고 이해하기가 편합니다.

ex.2 : tossing two coins

이번에는 동전던지기에 관한 또다른 확률변수를 생각해봅니다.

동전을 두 번 던졌을 때 나온 앞면의 수

도 확률변수 $X$가 됩니다. 이때의 표본공간은

\[\begin{align*} S &=\{H,T\}^2\\ &=\{(H,H),(H,T),(T,H),(T,T)\} \end{align*}\]인데, 강의에서는 cartesian product에서의 순서쌍의 표현을 생략하여, $S=\{HH,HT,TH,TT\}$로 쓰고 있습니다. 확률변수 $X$는

\[\begin{align*} X(HH)&=2\\ X(HT)&=1\\ X(TH)&=1\\ X(TT)&=0 \end{align*}\]로 정의되고 기존의 확률의 정의로는

\[\begin{align*} P(\{HH\})&=\frac14\\ P(\{HT,TH\})&=\frac12\\ P(\varnothing)&=0\\ P(S)&=1 \end{align*}\]와 같은 표현을 사용할 수 있었습니다. 그런데 이것을 확률변수의 함수로서 쓰면

\[\begin{align*} p(0)&=P(X=0)=\frac14\\ p(1)&=P(X=1)=\frac12\\ p(2)&=P(X=2)=\frac14 \end{align*}\]이 됩니다.

2.3 events defined by RV

강의에서는 $A_x$를 도입해서 설명하고 있습니다. 이때 $A_x$는 사건으로서, 확률변수 $X$가 $x$의 값을 가지는 경우, 즉 $X(w)=x$인 $w\in S$들의 집합으로, 아까 $(\ast)$에서 $p(x)$ 혹은 $P(X=x)$를 정의할 때 쓰인 집합입니다.

\[\begin{align*} A_x &=\{w\in S:X(w)=x\}\\ &=X^{-1}(\{x\}) \end{align*}\]따라서,

\[p(x)=P(X=x)=P(A_x)\]입니다.

지금까지, $P(~\cdot~)$에 들어가는 것이 사건(event, $S$의 부분집합)이었던 것을, 특정한 숫자로 들어갈 수 있게 바꾸었습니다. 여기에는 ‘숫자들의 집합’도 들어갈 수 있습니다. 예를 들어 $\{X:a\lt X\le b\}$와 같은 집합도 들어갈 수 있습니다. 보통 쓸 때는 $P(\{X:a\lt X\le b\})$로 쓰지 않고 $P(a\le X\le b)$로 표기하는데

\[P(a<X\le b)=P\left(\{w\in S:a<X(w)\le b\}\right)\]의 의미입니다. 예를 들어, 동전 두 개를 던지는 시행에서

\[P(X\le1)=P\left(\{HH,HT,TH\}\right)=\frac34\]입니다.

2.4 distribution functions

확률변수 $X$와 실수 $x$에 대하여 cumulative distribution function(CDF, 누적확률함수)은

\[F_X(x)=P\left(X\le x\right)\]로 정의합니다. 위의 동전 두 개를 던지는 시행에서

\[F_X(1)=\frac34\]였습니다.

따라서 CDF는

- nondecreasing 입니다 : if $x_1\lt x_2$, then $F_X(x_1)\le F_X(x_2)$

- 치역이 $[0,1]$입니다 : $0\le F_X(x)\le1$

- 두 점근선을 가집니다 : $\displaystyle\lim_{x\to\infty}F_X(x)=1$, $\displaystyle\lim_{x\to-\infty}F_X(x)=0$

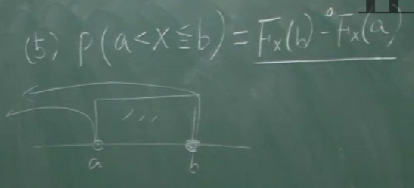

- $P(a\lt X\le b)=F_X(b)-F_X(a)$

- $P(x>a)=1-F_X(a)$

위의 $P(a\lt X\le b)$에서와 같이 부등호를 $\lt$로 할지 $\le$로 할지는 잘 구분해주어야 합니다. 다만, 연속확률변수의 경우에는 (아래 예제와 같은 예외가 발생하지 않는 한은) 둘 사이에 구분을 두지 않아도 됩니다.

위 그림과 같은 예제에서 CDF는

\[F_X(x)=\begin{cases} 0&(x\lt0)\\ x+\frac12&(0\le x\le\frac12)\\ 1&(x\gt\frac12)\\ \end{cases}\]와 같이 주어져 있는데

\[\begin{align*} P\left(X>\frac14\right)&=1-F_X\left(\frac14\right)=1-\frac34=\frac14\\ P(X>0)&=1-F_X(0)=1-\frac12=\frac12\\[10pt] P(X\ge0)&=1\\[10pt] P(X=0)&=1\\[10pt] P\left(X\ge\frac14\right)&=\frac14 \end{align*}\]입니다. 아래의 세 개 계산은 nontrivial합니다. 좌우극한을 가지고 계산하면

\[\begin{align*} P(X\ge0) &=1-P(X\lt0)\\[10pt] &=1-\lim_{x\to0-}P(X\le x)\\ &=1-0=1\\[10pt] P(X=0) &=P(X\le0)-P(X\lt0)\\ &=\frac12-0=1\\ P\left(X\ge\frac14\right) &=1-P\left(X\lt\frac14\right)\\[10pt] &=1-\lim_{x\to\frac14-}P(X\le x)\\ &=1-\lim_{x\to\frac14-}\left(x+\frac12\right)\\ &=1-\frac34=\frac14 \end{align*}\]입니다. 이때, $P(X>\frac14)=P(X\ge\frac14)$이지만 $P(X>0)=P(X\ge0)$인 것은 $F_X(x)$가 $x=\frac14$에서는 연속이지만 $x=0$에서는 불연속인 사실과 관련이 있습니다.

2.5 discrete random variables(이산확률변수)

확률변수 $X$가 가질 수 있는 값이 유한개이면 (혹은 countable개이면) $X$를 이산확률변수라고 부릅니다. 이 때, 확률질량함수(probability mass function, PMF) $P_X(x)$를 다음과 같이 정의합니다.

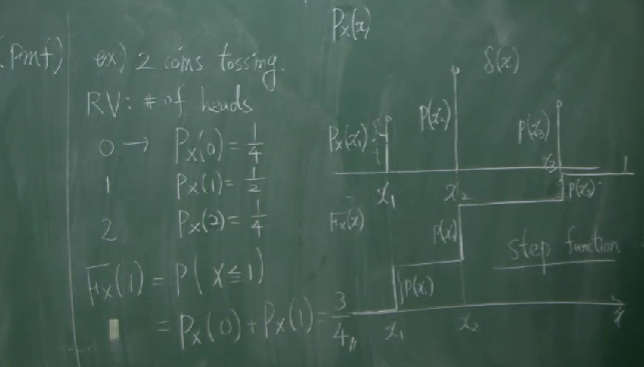

\[P_X(x)=P(X=x)\]예를 들어, 동전을 두 개 던져 앞면이 나온 횟수를 $X$라고 할 때

\[\begin{align*} P_X(0)=\frac14\\ P_X(1)=\frac12\\ P_X(2)=\frac14 \end{align*}\]입니다. PMF와 CDF 사이의 관계는 다음과 같습니다.

\[F_X(x)=\sum_{x_i\le x}P_X(x_i)\]이산확률변수의 분포(distribution)는 확률질량함수의 그래프로서 나타내는데, 그것을 $xy$ 평면에 찍힌 여러 개의 점으로 표현하기보다는, 여러 개의 선분으로써 표현하는 경향이 있는 것 같습니다.

동전을 두 개 던지는 시행에서의 확률질량함수의 그래프와 CDF와 PMF의 그래프는 아래와 같습니다. CDF의 그래프는 step function으로 나타나는 것을 볼 수 있습니다.

dirac delta function

$\langle04\rangle$에서 연속확률변수를 다루게 됩니다. 그리고, 연속확률변수에서는 확률질량함수(PMF)가 아닌 확률밀도함수(PDF)를 다루게 됩니다.

이산확률변수 $X$에 대해서도 확률밀도함수 $f_X(x)$를 생각할 수 있을까?

에 대한 답은 특별한 함수 $\delta$에서 찾을 수 있습니다.

다시 말해, 연속확률변수에서는

\[P(a\lt X\le b)=\int_a^bf_X(x)\,dx\]와 같은 식을 만족시키는 함수 $f_X(x)$를 생각하게 되는데, 확률질량함수 $P_X(x)$의 그래프에서는 ‘그래프 아래의 면적’이라는 개념을 정의할 수 없으니까 애매합니다. 그럴 때에, 함수 $\delta$(dirac delta function)를 도입하는데, 이 함수는

\[\delta(x)\approx \begin{cases} +\infty&(x=0)\\ 0&(x\ne0) \end{cases}\]와 같이 정의됩니다. 이 함수는 $x\ne0$인 곳에서는 함숫값이 0이고 $x=0$인 곳에서만 함숫값이 $\infty$인 불연속함수처럼 적혀있는데, 실제로는 연속함수처럼 생각합니다. 또, 실수 전체의 범위에서 적분했을 때의 값이 $1$인 것으로 가정합니다.

\[\int_{-\infty}^{\infty}\delta(x)\,dx=1\]

따라서 이 함수 $\delta(x)$가

\[P_X(x)= \begin{cases} 1&(x=0)\\ 0&(x\ne0) \end{cases}\]와 같이 정의된 가장 기본적인 확률질량함수 $P_X(x)$에 대응되는 확률밀도함수라고 생각할 수 있습니다. 일반적인 확률질량함수에 대한 확률밀도함수는 이 $\delta(x)$를 적절히 shift($x$축방향의 평행이동)한 것들을 가지고 일차결합하여 만들어낼 수 있습니다. 즉

\[P_X(x)= \begin{cases} p_1&(x=x_1)\\ &\vdots\\ p_n&(x=x_n) \end{cases}\]인 확률질량함수 $P_X(x)$에 대해서 (단, $p_1+\cdots+p_n=1$)

\[f_X(x)=\sum_{k=1}^np_k\delta(x-x_k)\]가 확률밀도함수의 역할을 할 수 있습니다.

예를 들어, 동전을 두 번 던지는 시행에 대해서는 PDF를

\[f_X(x)=\frac14\delta(x)+\frac12\delta(x-1)+\frac14\delta(x-2)\]로 정할 수 있습니다.

04 이산확률변수와 연속확률변수

2.6 continuous random variables

앞서 강의에서 확률변수를 $X:S\to\mathbb R$인 함수로 정의했습니다. 어떤 확률변수가 이산확률변수인지 연속확률변수인지를 결정하는 것은 이 확률변수의 치역 $X(S)$과 관련이 있습니다. $X(S)$가 countable이면 (혹은 at most countable, 그러니까, finite이거나 countably infinte) $X$를 이산확률변수라고 합니다. 이것은

확률변수 $X$가 가질 수 있는 값이 유한개(혹은 countable)이면 $X$를 이산확률변수라고 부릅니다.

와 같은 앞서의 정의를 다시 쓴 것입니다.

만약, 확률변수가 이산확률변수가 아니면 연속확률변수라고 부릅니다. 그러니까, 치역 $X(S)$가 uncountable인 경우를 말합니다. 말로 풀어 쓰면

확률변수 $X$가 가질 수 있는 값이 uncountable하게 많으면 $X$를 연속확률변수라고 부릅니다.

이산확률분포의 경우에 비해 연속확률분포의 경우에는 조금 어렵고 섬세한 이야기들이 많이 산적해있습니다. 예를 들어 0과 1 사이의 숫자를 임의로 뽑을 때 그 값을 $X$라고 하면, $X$는 연속확률변수입니다. 그런데 이런 경우에 $P(X=0.5)$을 어떻게 정의해야 할 지 애매합니다.

확률을 measure-theoretic하게 생각하면 $P$는 하나의 measure라고 볼 수 있고 이 경우에는 '집합의 길이'와 관련된 measure를 $P$로써 정의합니다. 그런데 원소가 하나인 집합에 대한 '길이'는 0이므로 $P(X=0.5)=0$입니다.

조금 다르게 설명할 수도 있습니다. $P(X=0.5)=a$로 두면 ($a>0$) 다른 모든 숫자 $0\le x\le1$에 대해서도 마찬가지로 $P(X=x)=a$가 성립한다고 말할 수 있을 겁니다. 그러면, 모든 $x$에 대하여 이 확률값들을 더했을 때 1이 되어야 합니다. 사실 이 덧셈이 잘 정의되는지도 의문이기는 하지만, 어쨌든 양수 $a$를 무한번 더해서 1이 된다는 것인데, 이건 말이 안됩니다. 따라서, 임의의 양의 실수 $a$에 대하여 $P(X=0.5)=a$인 것은 불가능하고, 따라서 $P(X=0.5)=0$일 수밖에 없습니다.

즉, 연속확률변수에서는 PMF가 잘 작동하지 않고, 따라서 다른 방식으로 연속확률분포를 이해할 필요가 있습니다. 강의에서는 다음과 같은 영어 문장으로 이 문제를 표현하고 있습니다.

It is not possible to define a probability value for each $x$.

$X$가 특정한 값 $x$를 가질 때의 확률은 정의하기 어려운 데 비해, $X$가 어떤 구간 안에 위치할 확률은 많은 경우에 계산할 수 있습니다. 예를 들어, 0과 1 사이의 숫자를 임의로 뽑을 때, 그 수가 0.1과 0.3사이의 값을 가질 확률은 0.2이라고 생각할 수 있습니다. 왜냐하면, $S$의 길이는 1인데 비해 $[0.1,0.3]$의 길이는 0.2이기 때문입니다.

\[P(0.1\lt X\lt 0.3)=\frac{0.2}1=0.2\]그러니까, 특정한 점 $X=x$에 대한 확률(확률질량함수)을 정의하는 대신 $x$를 포함하는 infinitesimal한 구간을 생각하고 그 구간에 대한 확률값을 그 구간의 길이로 나눈 값을 고려할 수 있습니다. 그리고 그 값은 $F_X$가 미분가능할 경우 $F_X$의 $x$에서의 미분계수와 정확히 일치합니다.

\[\begin{align*} f_X(x) &=\lim_{\Delta x\to0+}\frac{P\left(x<X\le x+\Delta x\right)}{\Delta x}\\ &=\lim_{\Delta x\to0+}\frac{F_X(x+\Delta x)-F_X(x)}{\Delta x}\\ &=F_X'(x) \end{align*}\]이 함수 $f_X(x)$를 확률밀도함수(probability density function)이라고 부릅니다. 위의 식은 CDF가 주어졌을 때 PDF를 구하는 방법이기도 합니다. 반대로, PDF가 주어졌을 때 CDF를 구하려면, $f_X=F_X’$와 $\displaystyle\lim_{x\to-\infty}F_X(x)=0$로부터

\[F_X(x)=\int_{-\infty}^xf_X(\tilde x)\,d\tilde x\]와 같이 구할 수 있습니다.

함수 $f_X(x)$가 어떤 연속확률변수의 PDF이기 위해서는 다음 두 조건을 만족시켜야 합니다.

(1) $f_X(x)\ge0$

(2) $\int_{-\infty}^\infty f_X(x)\,dx=1$

마찬가지로, 함수 $P_X(x)$가 어떤 이산확률변수의 PMF이기 위해서는 다음의 두 조건을 만족시켜야 합니다.

(1’) $P_X(x_i)\ge0$

(2’) $\sum_{k=1}^nP_X(x_i)=1$

PDF의 추가적인 성질들은 다음과 같습니다.

(3) $\int_a^bf_X(x)\,dx=P(a\lt X\le b)$

이것은, 지금까지 쓴 개념들을 동원해 쉽게 증명됩니다.

\[\begin{align*} P(a\lt X\le b) &=F_X(b)-F_X(a)\\ &=\int_{-\infty}^bf_X(x)\,dx-\int_{-\infty}^af_X(x)\,dx\\ &=\int_a^bf_X(x)\,dx \end{align*}\](4) $P(X\lt a)=P(X\le a)$

만약, 임의의 실수 $a$에 대하여 $P(X=a)=0$가 항상 성립한다고 가정할 때, (4)는 당연합니다. 왜냐하면

\[P(X\le a)=P(X\lt a)+P(X=a)=P(X\lt a)+0=P(X\lt a)\]이기 때문입니다.

ex 2.11

$0\lt x\lt 2$에 대하여 $f_X(x)=A(2x-x^2)$이 PDF가 되려면

\[1 =A\int_0^22x-x^2\,dx =\frac43A\]으로부터 $A=\frac34$입니다.

ex 2.15 uniform distribution

$f_X(x)$가 (혹은 $P_X(x)$가) 상수함수이면 $X$가 uniform distribution을 따른다고 정의합니다. 아까, 0과 1 사이의 숫자를 임의로 골라 그 값을 $X$라고 할때, $X$는 uniform distribution을 따릅니다. 주사위를 하나 던져 눈을 보는 것도 일종의 uniform distribution에 해당합니다.

고등학교 과정의 ‘기하학적 확률’에서 확률을 넓이 혹은 길이에 의존해 계산하게 되는데 그러한 상황 또한 uniform distribution을 가정하고 있습니다.

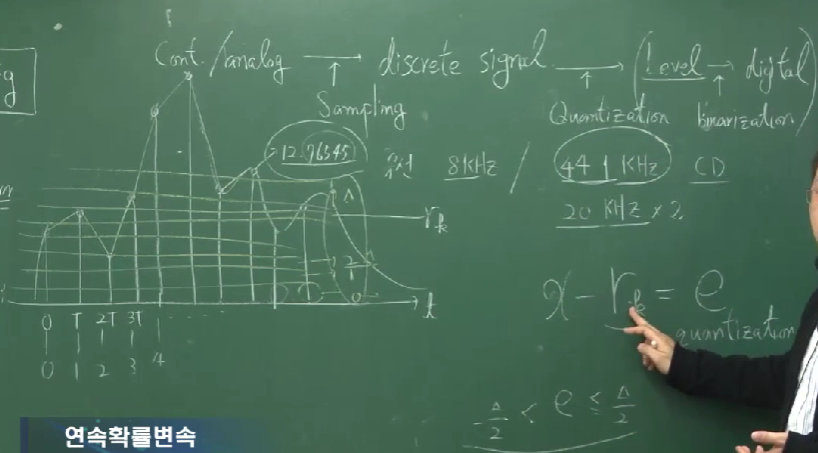

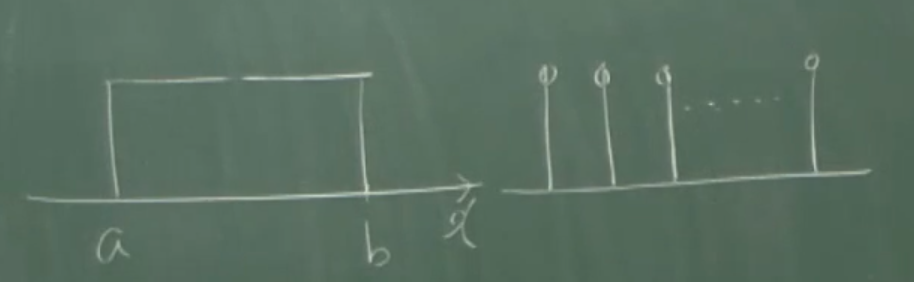

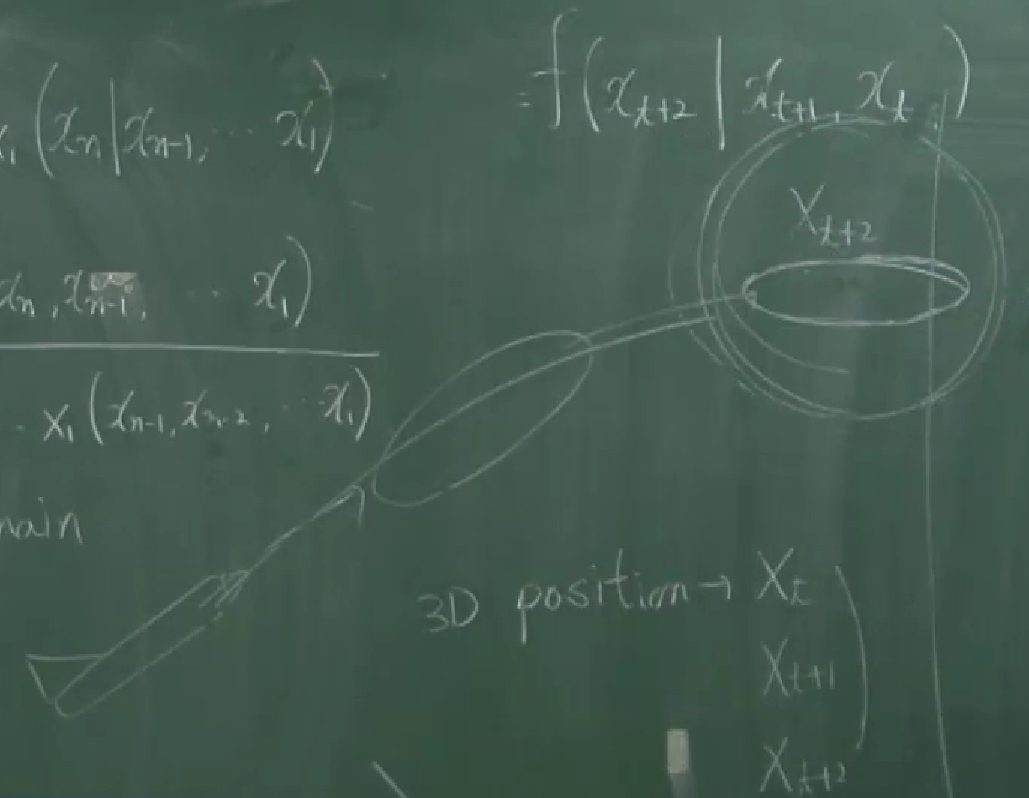

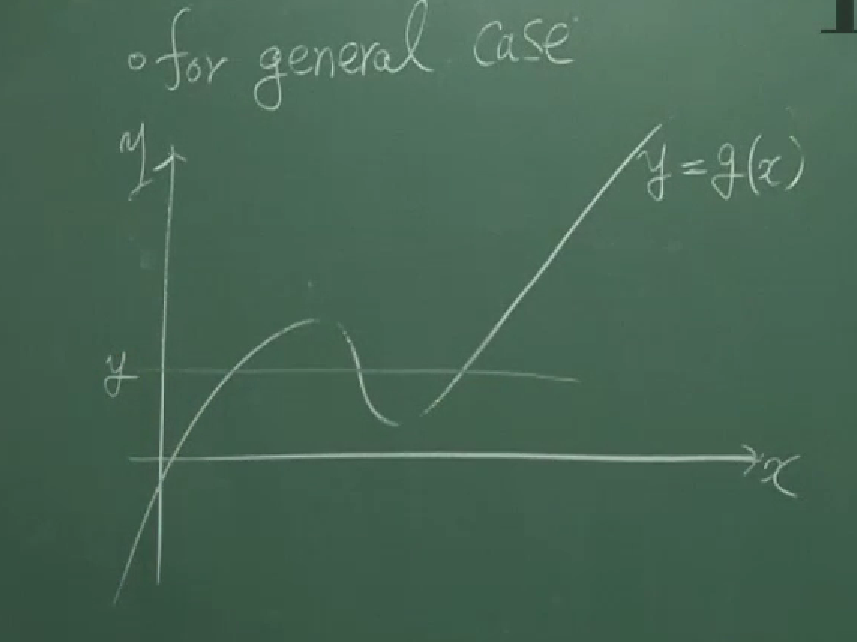

강의의 마지막 부분에는 신호나 그림에서의 sampling과 quantization, binarization에 대해 언급됩니다. (아래 캡쳐)

이에 대한 설명은 다음과 같습니다.

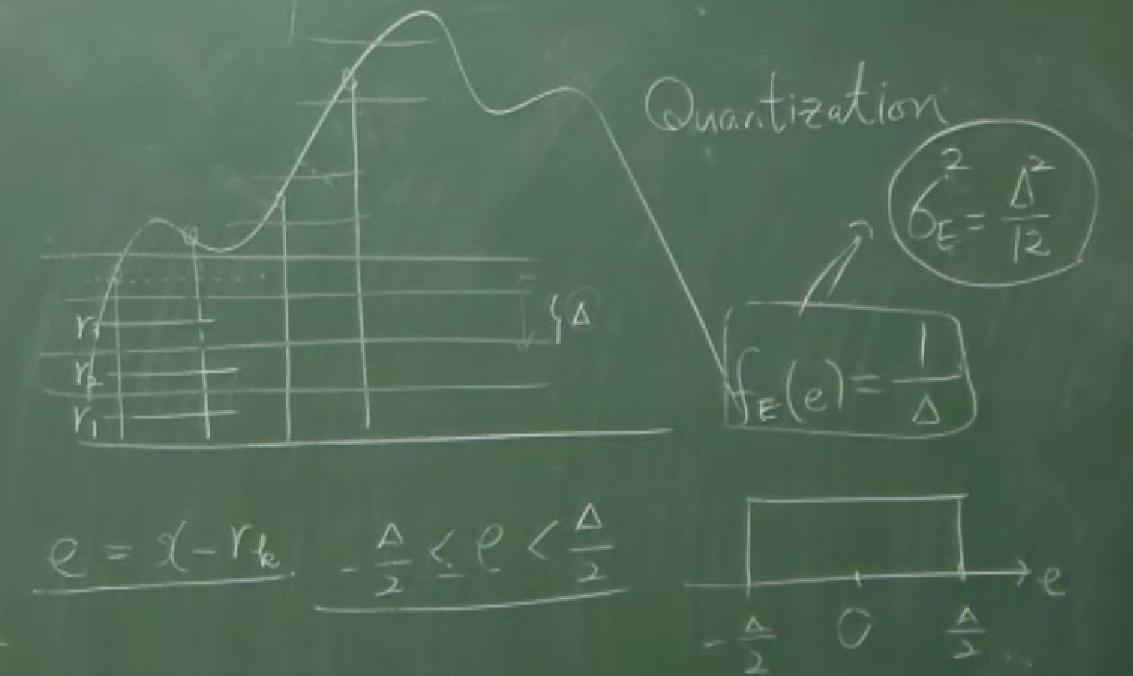

연속적인 아날로그 신호(continuous, analogue signal)를 특정한 주파수로 sampling하면 discrete signal을 얻을 수 있습니다. 이 discrete signal을 표현할 때에는 특정한 step size를 가정하여 level의 형태로 얻게 되는데 이 과정을 양자화(quantization)라고 부릅니다. 마지막으로 이 값들을 2진수로 바꾸어(binarization) 디지털 신호로 바꾸는 과정이 있습니다. 이 일련의 과정들은 아날로그로 주어진 데이터를 디지털의 형태로 바꾸는 작업입니다. 이때, 실제 신호와 level로 주어진 근사값들 사이의 차이를 quantization error라고 가정하는데, 많은 경우에 이 error를 uniform distribution을 따른다고 가정하고 모델링을 진행한다고 합니다.

확률변수 $X$가 어디에 얼마나 분포되어있는지 하는 것을 그 확률변수의 분포(distribution)이라고 합니다. 이 분포를 직접적으로 표현하는 것이 PMF(확률질량함수, probability mass function), PDF(확률밀도함수, probability density function), CDF(누적분포함수, cumulative distribution function)와 같은 분포함수들입니다. 그 중 이산확률변수에 대해서는 PMF를, 연속확률분포에 대해서는 PDF를 주로 분포함수로 취급하게 되는데 PMF와 PDF는 모든 종류의 확률변수에 대해 잘 정의되지 않습니다.

예를 들어, PDF로는 이산확률분포를 정하기가 힘들었습니다. 그래프의 면적이 1이 된다는 점을 만족시키기 위해서 dirac delta function 같은 것을 도입해야 했습니다. 또, PMF로는 연속확률분포를 정하는 데 어려움이 있었습니다. 각 점에 대한 PMF의 값이 0이 될 수밖에 없는데, 그건 그것대로 모순이었습니다.

하지만, CDF는 $X$가 이산확률변수이건 연속확률변수이건 상관없이 적절하게 잘 정의될 수 있습니다. 또한, 일단 CDF가 정해지고 나면 CDF의 식으로부터 PMF나 PDF의 식을 쉽게 구할 수 있다는 점도 있습니다. 그래서 그런지, 많은 경우에 CDF를 먼저 정의하고, 그 이후에 PMF나 PDF를 정의하는 것 같습니다.

05 확률변수의 평균과 분산

Chapter 3. Moments of Random Variables

arithemetic average(산술평균)

$x_i$들의 산술평균은

\[\bar x=\frac{x_1+\cdots+x_N}N.\]different frequences

서로다른 $x_i$들에 대하여 그 빈도 $w_i$가 주어져 있을 때의 가중평균(weighted average)은

\[\bar x=\frac{w_1x_1+\cdots+w_Nx_N}{w_1+\cdots+w_N}.\]3.1 expectation(mean)

\[\begin{align*} E[X]&=\sum_{i=1}^nx_iP_X(x_i) &&(\text{discrete})\\ E[X]&=\int_{-\infty}^\infty xf_X(x)\,dx &&(\text{continuous}) \end{align*}\]ex 3.3 Poisson distribution

이산확률변수 $K$가 다음과 같은 확률질량함수를 가지고 있으면, $K$가 Poisson distribution을 따른다고 말합니다.

\[P_K(k)=\frac{\lambda^k}{k!}e^{-\lambda}\qquad(k=0,1,2,\cdots)\]Poisson distribution의 자세한 의미에 대해서는 $\langle08\rangle$에 적어보았습니다. 그래도 간단히 요약하면,

단위시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 기대될 때, 단위시간동안 사건이 일어난 횟수

를 $K$라고 하면, $K$는 위의 PMF를 가집니다. 이에 대한 증명은 $\langle08\rangle$에서 해보았습니다.

$P_K$가 PMF가 되기 위해서는 두 조건을 만족시켜야 하는데 첫번째 조건인 $P_K(k)\ge0$은 당연합니다. 두번째 조건인 $\sum_k P_K(k)=1$을 위해서는 $e^x$에 대한 Maclaurin series(혹은 지수함수에 대한 추상적인 정의)를 사용할 수 있습니다;

\[e^x=\sum_{k=0}^\infty\frac{x^k}{k!}\]여기에 $x=\lambda$를 대입하여

\[e^\lambda=\sum_{k=0}^\infty\frac{\lambda^k}{k!}\]를 얻습니다. 이 식의 양변에 $e^{-\lambda}$를 곱하면

\(1=\sum_{k=0}^\infty\frac{\lambda^k}{k!}e^{-\lambda}=\sum_{k=1}^\infty P_K(k)\) 가 되어 두번째 조건을 만족시킵니다. 따라서 $P_K(k)$는 정말로 PMF가 됩니다. 강의에서는 일반적인 Taylor series에 대한 설명도 포함되어 있습니다.

이 Poisson distribution에 대한 평균을 구해보면

\[\begin{align*} E[X] &=\sum_{k=0}^\infty kf_K(k)\\ &=\sum_{k=0}^\infty k\frac{\lambda^k}{k!}e^{-\lambda}\\ &=\sum_{k=1}^\infty k\frac{\lambda^k}{k!}e^{-\lambda}\\ &=\lambda\sum_{k=1}^\infty\frac{\lambda^{k-1}}{(k-1)!}e^{-\lambda}\\ &=\lambda\sum_{m=0}^\infty\frac{\lambda^m}{m!}e^{-\lambda}\\ &=\lambda \end{align*}\]이 됩니다.

ex 3.4 exponential distribution

연속확률변수 $X$가 다음과 같은 확률밀도함수를 가지고 있으면, $X$가 exponential distribution을 따른다고 말합니다.

\[\begin{align*} f_X(x)= \begin{cases} \lambda e^{-\lambda x} &x\ge0\\ 0 &x\lt0 \end{cases} \end{align*}\]이번에도, exponential distribution의 자세한 의미에 대해서는 $\langle08\rangle$에서 다시 설명하겠습니다. 그래도 간단히 요약하면,

단위시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 기대될 때, 사건이 발생하기까지의 시간

를 $X$라고 하면, $X$는 위의 PDF를 가집니다. 이에 대한 증명은 $\langle08\rangle$에서 해보았습니다.

이번에도 $f_X$가 PDF가 되기 위해서는 두 가지 조건을 만족시켜야 하는데 첫번째 조건 $f_X(x)\ge0$은 당연합니다. 두 번째 조건인 $\int_{-\infty}^\infty f_X(x)\,dx=1$ 을 확인해보면

\[\begin{align*} \int_{-\infty}^\infty f_X(x)\,dx &=\lambda\int_0^\infty e^{-\lambda x}\,dx\\ &=\lambda\times\left[-\frac1\lambda e^{-\lambda x}\right]_0^\infty\\ &=\lambda\times\frac1\lambda\\ &=1 \end{align*}\]이 성립합니다. 한편, 평균을 구해보면

\[\begin{align*} E[X] &=\int_{-\infty}^\infty xP_X(x)\,dx\\ &=\lambda\int_0^\infty xe^{-\lambda x}\,dx\\ &=\lambda\left(\left[-\frac1\lambda xe^{-\lambda x}\right]_0^\infty +\int_0^\infty\frac1\lambda e^{-\lambda x}\,dx\right)\\ &=\lambda\left(0+\left[-\frac1{\lambda^2}e^{-\lambda x}\right]_0^\infty\right)\\ &=\frac1\lambda \end{align*}\]입니다. 세번째 등호에서 부분적분을 사용했습니다.

(b) 연속확률변수 $X$가 $$f_X(x)= \begin{cases} \lambda e^{-\lambda x} &x\ge0\\ 0 &x\lt0 \end{cases} $$ 를 그 밀도함수로 가질 때 $$X\sim\text{Exp}(\lambda)$$ 로 표현하기도 합니다.

3.4 moments of random variables

nth order moments

\[\begin{align*} E[X^n]&=\sum_i{x_i}^n P_X(x_i)&&(\text{discrete})\\ E[X^n]&=\int_{-\infty}^\infty x^n f_X(x)\,dx&&(\text{continuous}) \end{align*}\]central moments

\[\begin{align*} E[(X-\mu)^n]&=\sum_i(x_i-\mu)^nP_X(x_i)&&(\text{discrete})\\ E[(X-\mu)^n]&=\int_{-\infty}^\infty(x-\mu)^n f_X(x)\,dx&&(\text{continuous}) \end{align*}\]$n=1$이면

\[\begin{align*} E[(X-\mu)] &=\sum_i(x_i-\mu)P_X(x_i)\\ &=\sum_ix_iP_X(x_i)-\mu\sum_iP_X(x_i)\\ &=\mu-\mu\times 1\\ &=0 \end{align*}\]이고

\[\begin{align*} E[(X-\mu)] &=\int_{-\infty}^\infty(x-\mu)f_X(x)\,dx\\ &=\int_{-\infty}^\infty xf_X(x)\,dx-\int_{-\infty}^\infty \mu f_X(x)\,dx\\ &=E[X]-\mu\times1\\ &=0 \end{align*}\]입니다. 즉, 편차의 합은 항상 0입니다.

$n=2$이면

\[\begin{align*} E[(X-\mu)^2] &=\sum_i(x_i-\mu)^2P_X(x_i) \end{align*}\]인데 이 값을 분산(variance)이라고 부르고 ${\sigma_X}^2$으로 씁니다. 강의에서는 ${\sigma_X}^2$와 같은 표현만 쓰이고 있지만, 이 포스트에서는 $V[X]$와 같은 표현도 종종 사용하겠습니다. 분산에 관한 성질은 다음과 같습니다.

- 분산은 항상 0보다 크거나 같습니다.

- uniform distribution의 분산은 0이고 그 역도 성립합니다.

- 분산이 작으면 변량들이 평균에 모여있고 분산이 크면 변량들이 넓게 분포되어 있습니다.

- $t$에 대한 함수 $g(t)=E[(X-t)^2]$를 생각하면 이 함수는 $t=\mu$에서 최솟값 ${\sigma_X}^2$를 가집니다.

$\langle14\rangle$ 다루게 되겠지만, 여기에서 미리 말해놓는 게 좋을 것 같습니다. 흔히 LOTUS라는 약칭으로 불리는 정리 혹은 정의로서, 함수 $g$에 대하여 $g(X)$의 평균을 구하는 식이 있습니다 ; $$ \begin{align*} E[g(X)]&=\sum_ig(x_i)P_X(x_i) &&(\text{discrete})\\ E[g(X)]&=\int_{-\infty}^\infty g(x)f_X(x)\,dx &&(\text{continuous}) \end{align*}\tag{LOTUS, $\ast$} $$ 아까 평균에 대해 정의한 것은 $$ \begin{align*} E[X]&=\sum_{i=1}^nx_iP_X(x_i) &&(\text{discrete})\\ E[X]&=\int_{-\infty}^\infty xf_X(x)\,dx &&(\text{continuous}) \end{align*}\tag{$\ast\ast$} $$ 와 같은 정의가 전부였습니다. 그런데 무의식적(unconscious)으로 $$ \begin{align*} E[X^n]&=\sum_i{x_i}^n P_X(x_i)&&(\text{discrete})\\ E[X^n]&=\int_{-\infty}^\infty x^n f_X(x)\,dx&&(\text{continuous}) \end{align*} $$ 와 같은 계산을 했습니다. 이 계산이 정당화되려면 LOTUS와 같은 식을 먼저 증명해야 하는 것입니다. 통계학자들은 보통 이와 같은 논리적인 비약을 알아차리지도 못한 채로 논의를 진행시킨다는 의미에서, 이 정리는 law of the unconscious statistician라는 이름으로 불립니다.

결론부터 말하자면, LOTUS의 식 $(\ast)$은 성립합니다. 다만, 그 증명이 아주 당연하지는 않습니다. discrete case는 증명이 쉽지만, continuous case에 대한 일반적인 증명은 어렵습니다. 그래서, $(\ast\ast)$를 정의로, LOTUS를 정리로 두고 그것의 증명을 시도하는 대신, LOTUS의 식 $(\ast)$을 정의로서 차용하는 경우도 있다고 합니다. 이렇게 평균을 LOTUS의 식으로 정의해버리면, 기존 정의와도 일치하는 정의가 되면서, 굳이 어려운 증명을 하지 않아도 되게 됩니다.

이 포스트에서는 $(\ast\ast)$를 정의로 두고 LOTUS를 증명하려고 합니다. 그것들은 $\langle14\rangle$에서 다시 다루겠습니다. 다만, LOTUS를 아직 비록 증명하지는 않았더라도, LOTUS는 앞으로 사용할 예정입니다.

Proposition 3.3

어떤 확률변수 $X$에 대한 함수 $g_1(X)$, $g_2(X)$와 실수 $a_1$, $a_2$에 대하여

\[E[a_1g_1(X)+a_2g_2(X)]=a_1E[g_1(X)]+a_2E[g_2(X)]\]이 성립합니다. LOTUS 식에 넣으면 바로 증명됩니다. 만약 $X$가 이산확률변수이면

\[\begin{align*} E[a_1g_1(X)+a_2g_2(X)] &=\sum_i\left(a_1g_1(x_i)+a_2g_2(x_i)\right)P_X(x_i)\\ &=a_1\sum_ig_1(x_i)P_X(x_i)+a_2\sum_ig_2(x_i)P_X(x_i)\\ &=a_1E[g_1(X)]+a_2E[g_2(X)] \end{align*}\]이고, 만약 $X$가 연속확률변수이면

\[\begin{align*} E[a_1g_1(X)+a_2g_2(X)] &=\int_{-\infty}^\infty\left(a_1g_1(x)+a_2g_2(x)\right)f_X(x)\,dx\\ &=a_1\int_{-\infty}^\infty g_1(x)f_X(x)\,dx +a_2\int_{-\infty}^\infty g_2(x)f_X(x)\,dx\\ &=a_1E[g_1(X)]+a_2E[g_2(X)] \end{align*}\]이기 때문입니다.

이 proposition으로부터 바로 얻을 수 있는 결과는

\[E[aX+b]=aE[X]+b\]입니다. 또한

\[\begin{align*} {\sigma_X}^2 &=E[(X-\mu)^2]\\ &=E[X^2-2\mu X+\mu^2]\\ &=E[X^2]-2\mu E[X]+\mu^2\\ &=E[X^2]-2E[X]^2+E[X]^2\\ &=E[X^2]-E[X]^2 \end{align*}\]도 얻을 수 있습니다. 이를 이용하여 Poisson distribution

\[P_K(k)=\frac{\lambda^k}{k!}e^{-\lambda}\]의 분산을 구해보면

\[\begin{align*} E[K^2] &=\sum_{k=0}^\infty k^2P_K(k)\\ &=\sum_{k=0}^\infty k^2\frac{\lambda^k}{k!}e^{-\lambda}\\ &=\sum_{k=0}^\infty k(k-1)\frac{\lambda^k}{k!}e^{-\lambda} +\sum_{k=0}^\infty k\frac{\lambda^k}{k!}e^{-\lambda}\\ &=\sum_{k=2}^\infty k(k-1)\frac{\lambda^k}{k!}e^{-\lambda}+E[X]\\ &=\lambda^2\sum_{k=2}^\infty\frac{\lambda^{k-2}}{(k-2)!}e^{-\lambda}+E[X]\\ &=\lambda^2\sum_{m=0}^\infty\frac{\lambda^m}{m!}e^{-\lambda}+E[X]\\ &=\lambda^2+\lambda \end{align*}\]으로부터

\[{\sigma_K}^2=E[K^2]-E[K]^2=(\lambda^2+\lambda)-\lambda^2=\lambda\]입니다. 또한, exponential distribution

\[\begin{align*} f_X(x)= \begin{cases} \lambda e^{-\lambda x} &x\ge0\\ 0 &x\lt0 \end{cases} \end{align*}\]의 분산을 구해보면

\[\begin{align*} E[X^2] &=\int_0^\infty x^2P_X(x)\,dx\\ &=\int_0^\infty x^2\lambda e^{-\lambda x}\,dx\\ &=\left[-x^2e^{-\lambda x}\right]_0^\infty+\int_0^\infty2xe^{-\lambda x}\,dx\\ &=0+\frac2\lambda\int_0^\infty x\lambda e^{-\lambda x}\,dx\\ &=\frac2\lambda\cdot E[X]=\frac2{\lambda^2} \end{align*}\]이고

\[{\sigma_X}^2=E[X^2]-E[X]^2=\frac1{\lambda^2}\]입니다.

06 조건부 평균

ex 3.13 geometric distribution

시행의 결과가 성공/실패의 두 종류로 나오는 시행을 Bernoulli trial이라고 합니다.

어떤 Bernoulli trial을 반복적으로 시행할 때, $K$번째에 처음으로 성공할 경우

에 $K$는

\[P_K(k)=(1-p)^{k-1}p\qquad(k=1,2,\cdots)\]와 같은 PMF를 가집니다. 위 식에 대한 증명은 당연하기 때문에 생략하겠습니다. 이때, 이산확률변수 $K$가 geometric distribution을 따른다고 합니다.

예를 들어, 다음(칠판에 적힌 문장)과 같이 정의된 $K$는 geometric distribution을 따릅니다.

Let $K$ be the number of trials until the first success. For example, we may toss a die repeatedly until the first $6$.

그러니까, 주사위 하나를 반복적으로 던질 때, 주사위의 눈이 처음으로 6이 나오기까지의 시행횟수를 $K$라고 하면 $K$는 geometric distribution을 따릅니다.

$P_K(k)$가 PMF가 되기 위한 첫번째 조건인 $P_K(k)\ge0$를 만족시키는 것은 당연합니다. 두번째 조건도 (예의상) 확인해보면

\[\sum_{k=1}^\infty P_K(k)=p+p(1-p)+p(1-p)^2+\cdots=\frac p{1-(1-p)}=1\]입니다. 다음으로 평균을 구해보면

\[\begin{align*} E[K] &=\sum_{k=1}^\infty kP_K(k)\\ &=\sum_{k=1}^\infty k(1-p)^{k-1}p\\ &=p+2(1-p)p+3(1-p)^2+\cdots\\ (1-p)E[K]&=(1-p)p+2(1-p)^2p+3(1-p)^3p \end{align*}\]두 식을 적당히 빼면

\[pE[K]=p+(1-p)p+(1-p)^2p+\cdots=1\]이고 $E[K]=\frac1p$입니다.

(강의에서는 미분을 통해 구한 것 같습니다만, 위와 같이 멱급수의 공비를 곱하는 방식으로 구해봤습니다. 하지만 지금 구한 방법으로는 분산을 구하기가 힘들 것 같으니, 미분의 방법으로 처음부터 다시 풀어보면)

다시 평균을 구하기 위해 평균 식

\[E[K]=\sum_{k=1}^\infty k(1-p)^{k-1}p\]을 보면 $\sum_k (1-p)^k$와 같은 함수형태를 미분하는 것이 요긴할 것으로 보입니다. 등비급수의 식에 의해

\[\sum_{k=1}^\infty(1-p)^k=\frac{1-p}{1-(1-p)}=\frac{1-p}p=\frac1p-1\]이고, 양변을 $p$에 대하여 미분한 뒤 마이너스를 붙이면

\[\begin{equation}\tag{$*$} \sum_{k=1}^\infty k(1-p)^{k-1}=\frac1{p^2} \end{equation}\]입니다. 따라서

\[E[K]=\frac1{p^2}\times p = \frac1p\]입니다. $E[K^2]$의 식도 보면

\[E[K^2]=\sum_{k=1}^\infty k^2(1-p)^{k-1}p\]인데, 이것은 식 ($\ast$)을 미분하면 비슷한 식을 얻을 수 있습니다. ($\ast$)을 미분한 뒤 마이너스를 붙이면

\[\sum_{k=1}^\infty k(k-1)(1-p)^{k-2}=\frac2{p^3}\]이고, 따라서

\[\begin{aligned} \sum_{k=1}^\infty k^2(1-p)^{k-2} &=\frac2{p^3}+\sum_{k=1}^\infty k(1-p)^{k-2}\\ &\stackrel{(\ast)}=\frac2{p^3}+\frac1{p^2(1-p)}\\ &=\frac{2(1-p)+p}{p^3(1-p)}\\ &=\frac{2-p}{p^3(1-p)} \end{aligned}\tag{$\ast\ast$}\]이고,

\[E[K^2]=\sum_{k=1}^\infty k^2(1-p)^{k-1}p =\frac{2-p}{p^3(1-p)}\times p(1-p)=\frac{2-p}{p^2}\]입니다. 따라서

\[{\sigma_K}^2=E[K^2]-E[K]^2=\frac{2-p}{p^2}-\frac1{p^2}=\frac{1-p}{p^2}\]입니다.

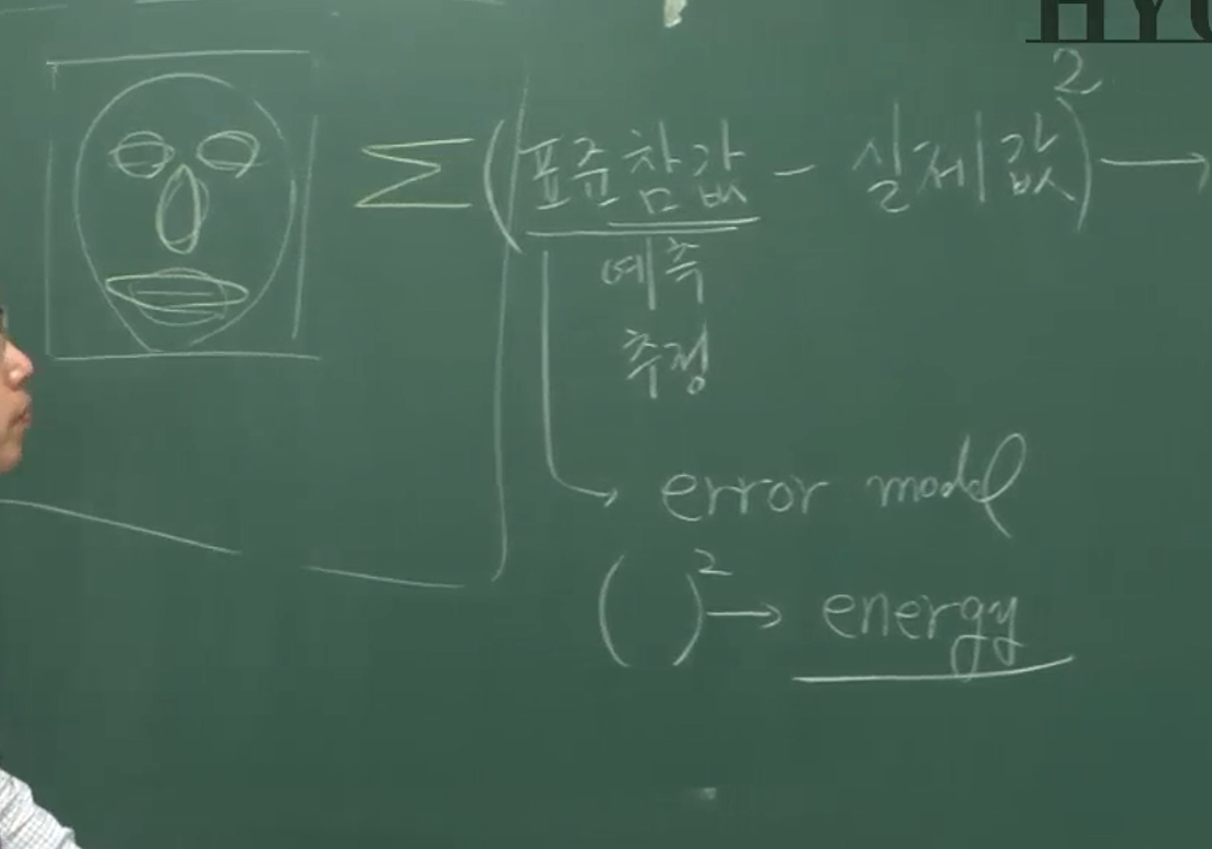

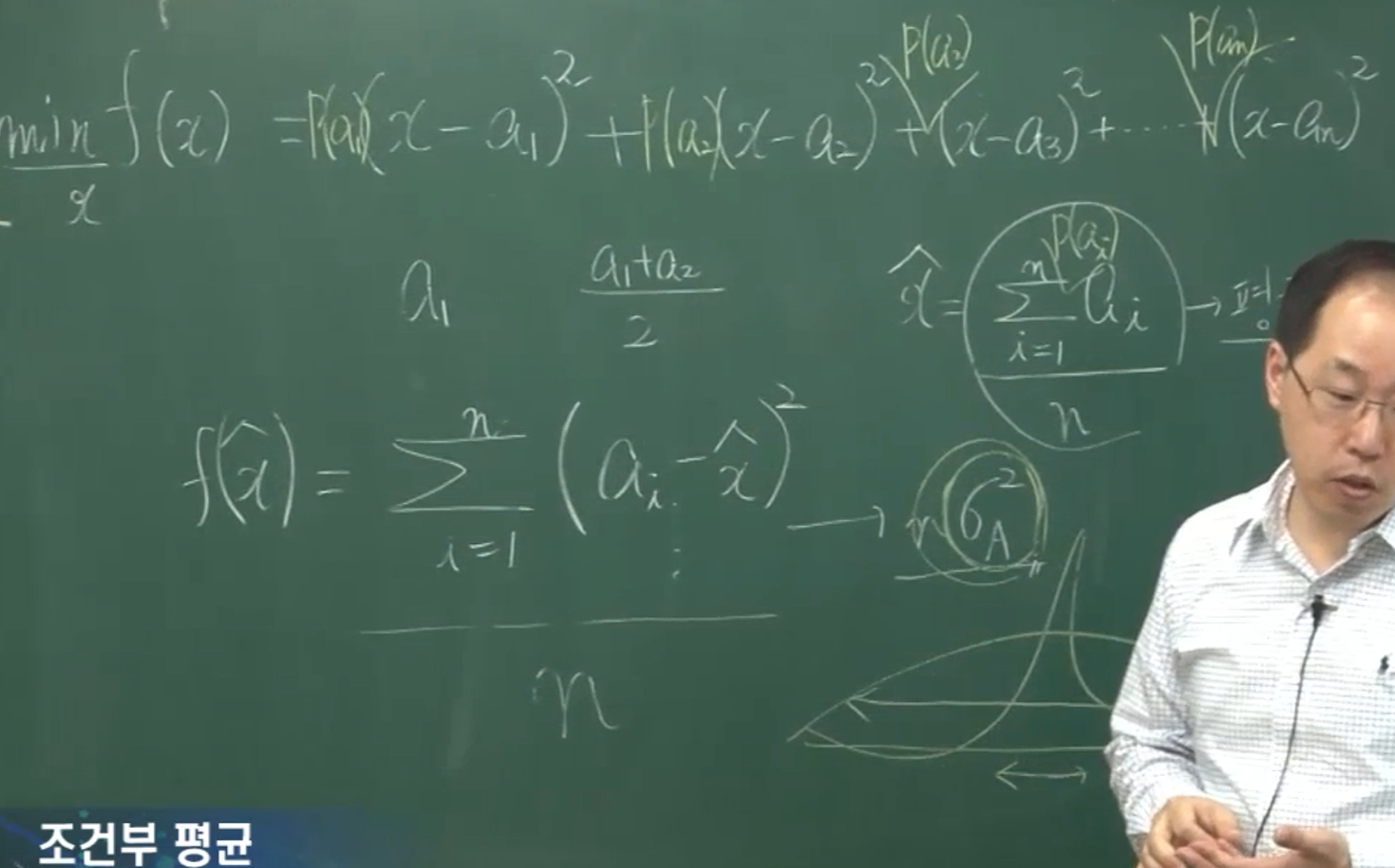

이후에는 평균과 분산의 의미에 대한 설명이 있습니다(위 캡쳐). computer vision에서의 얼굴인식문제를 아주 naive하게 생각할 때, 우리는 실제 카메라에 인식된 얼굴모양(실제값)이 우리가 정한 특정한 형태의 얼굴모양 (표준참값, 예측값, 추정값, 표준모델의 값)과 얼마나 비슷한지를 판단할만한 판단근거가 필요합니다.

이때의 실제값과 표준참값은 각각 벡터로 생각할 수 있고, 따라서 표준적인 벡터사이의 거리(의 제곱)인 $L^2$ norm(의 제곱)을 생각하게 됩니다. 그것은 실제값과 표준참값을 뺀 다음 제곱하여 성분별로 더하는 것을 말합니다. 그리고 이 값(통상 energy라고 부르기도 하는 값)이 최소가 되도록 하는 표준참값을, ‘괜찮은 모델’이라고 둘 수 있을 것입니다.

그런데 $L^2$ norm의 제곱, 즉 sum of squared errors(SSE)는 그 특성상 표준참값이 실제값들의 평균일 때에 최소가 되는 경향이 있습니다. (사실 표준참값-실제값 예는 multivariate이고 뒤에 나오는 예시는 univariate이라서 적절한 설명인지 잘 이해가 안가긴 하지만) 그리고 이것은 아까 간단하게 언급한 적이 있습니다. 즉

\[g(t)=\sum_{k=1}^n(t-x_k)^2\]는 $t=\frac1n\sum_{k=1}^nx_k$일 때, 즉 $t$가 $x_k$들의 평균일 때 최소가 되는 것입니다. 즉

\[\text{arg}\min_t\sum_{k=1}^n(t-x_k)^2=\frac1n\sum_{k=1}^nx_k\]이고

\[\min_t\sum_{k=1}^n(t-x_k)^2={\sigma_X}^2\]인 것입니다. 증명은, 중학교 식으로 $ax^2+bx+c$의 최솟값을 구하는 식으로 해도 되고, 고등학교 식으로 미분을 사용해도 됩니다. 여기에서는 discrete uniform distribution인 경우에 대해서만 이야기한 셈이지만 일반적인 discrete distribution에 대해서도, 그리고 연속확률분포에 관해서도 마찬가지의 사실을 쉽게 증명할 수 있습니다.

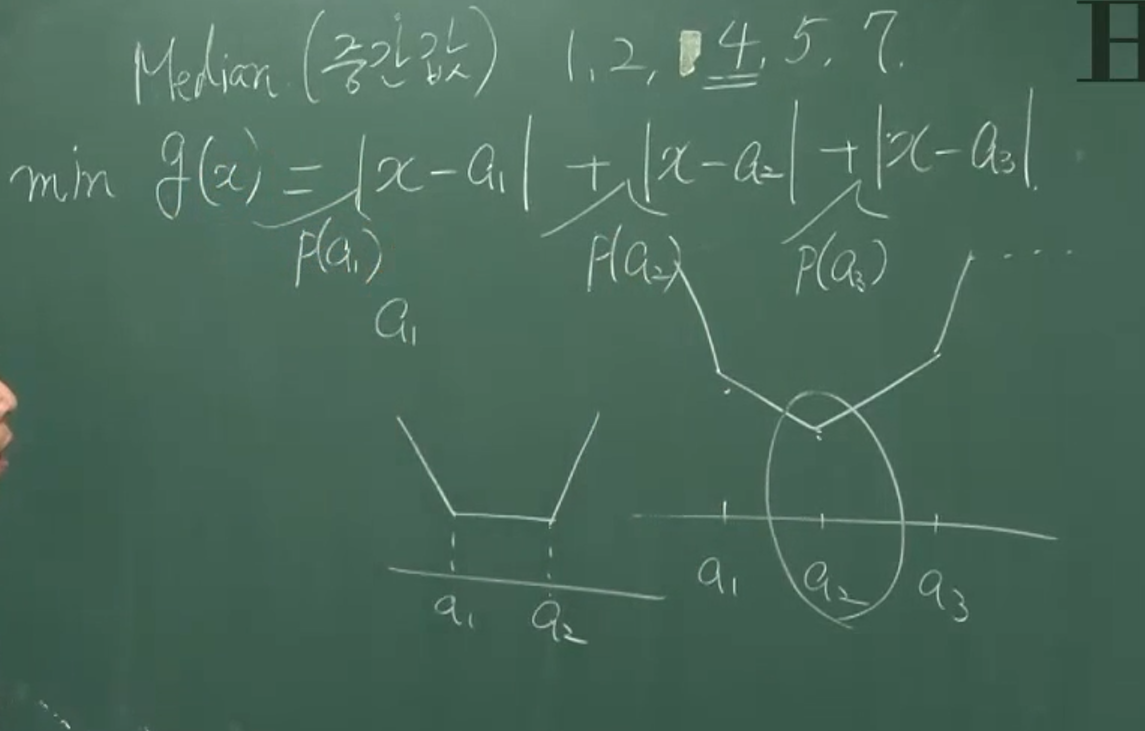

반면

\[h(t)=\sum_{k=1}^n|t-x_k|\]와 같은 값을 objective function으로 둘 수도 있을 것입니다. 이 경우에는 $t$가 $x_k$들의 중간값(median)일 때 $g(t)$가 최소임이 알려져있습니다. 이것은 그래프를 살짝 그려보기만 해도 알 수 있습니다. (아래 그림) 다만, 이 경우도 역시 discrete uniform distribution에 대한 논증인데, 일반적인 discrete distribution와 연속확률분포에 대해서는 다른 방식의 증명이 필요할 것입니다.

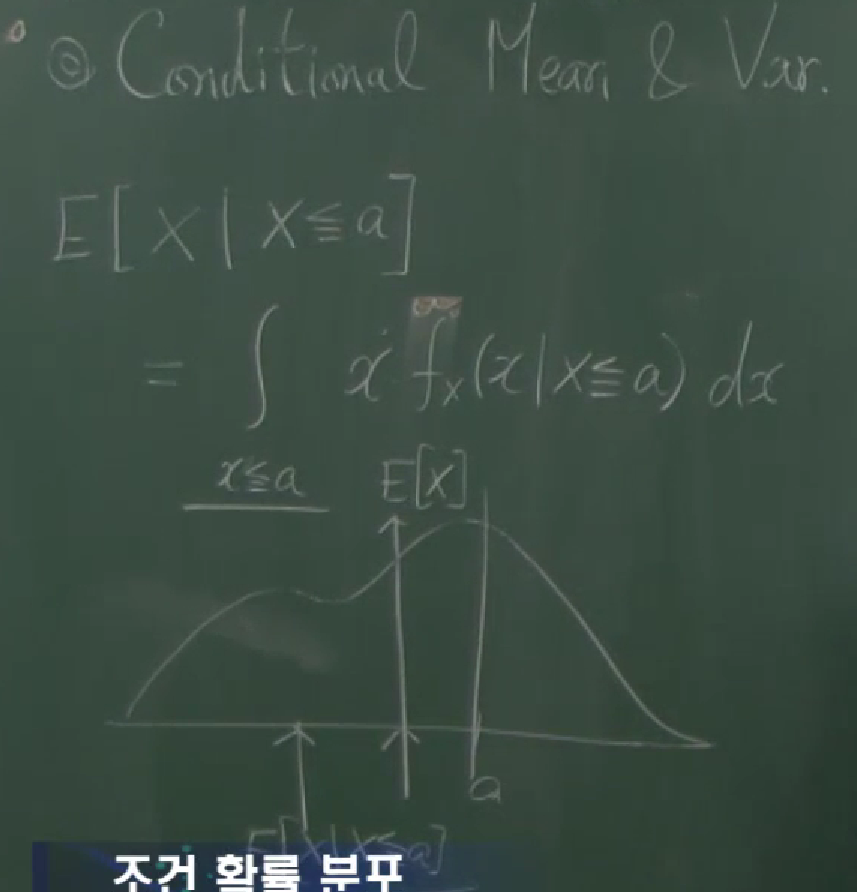

3.5 conditional expectation

이산확률변수의 conditional expectation(조건부기댓값)을 정의하기 전에, 먼저 conditional PMF(조건부 확률질량함수)를 다음과 같이 정의합니다.

\[P_X(x|A)=P(X=x|A)\]그러면, 이산확률변수에서의 conditional expectation을

\[E[X|A]=\sum_{x_i\in A}x_iP_X(x_i|A)\]로 정의할 수 있습니다. 여기에서 $A$는 사건(event, $A\subset S$)이라기보다는 실수들의 집합($A\subset\mathbb R$)인 것 같습니다. 그리고, $X=x_i$라는 표현이 마치 사건처럼 쓰여져있습니다. 따라서 $P_X(x_i|A)$는

\[P(\{w\in S:X(w)=x_i\}|\{w\in S:X(w)\in A\})\]의 의미입니다.

이번에는 연속확률변수의 조건부 기댓값을 정의하겠습니다. 먼저 conditional CDF는

\[F_X(x|A)=P(X\le x|A)\]로 정의됩니다. conditional PDF는 PDF의 정의에서와 마찬가지로 미분을 통해 얻을 수 있습니다.

\[\begin{align*} f_X(x|A) &=\lim_{\Delta x\to0+}\frac{P\left(x<X\le x+\Delta x|A\right)}{\Delta x}\\ &=\lim_{\Delta x\to0+}\frac{F_X(x+\Delta x|A)-F_X(x|A)}{\Delta x}\\ &=\frac d{dx}F_X(x|A) \end{align*}\]입니다. 이를 통해 conditional expectation을

\[E[X|A]=\int_{x\in A}xf_X(x|A)\,dx\]로 정의할 수 있습니다.

ex. 3.14

사건 $A=\{X\le a\}$에 대하여 conditional CDF와 conditional PDF를 구해봅니다. 이때 $A$는

\[A=\{w\in S:X(w)\le a\}\]라는 의미입니다. 이때 $X$의 CDF와 PDF는 이미 주어져 있다고 가정합니다. 그러니까, $F_X(x)$와 $f_X(x)$를 사용하여 $F_X(x|A)$와 $f_X(x|A)$를 구하는 것이 목적입니다. conditional CDF $F_X(x|A)$ 를 먼저 계산하면

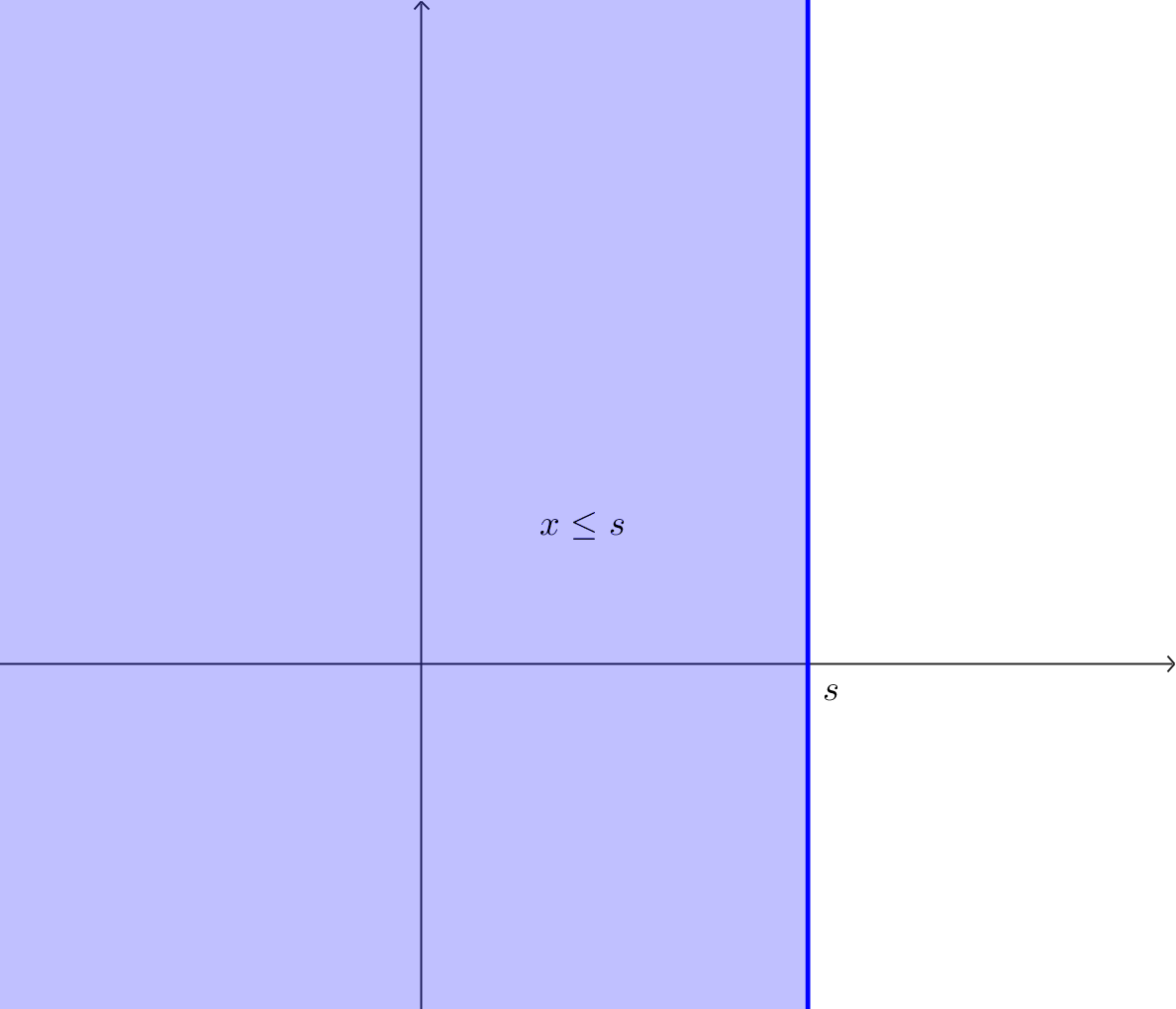

\[\begin{align*} F_X(x|A) &=P\left(X\le x|X\le a\right)\\ &=\frac{P\left(X\le x\cap X\le a\right)}{P(x\le a)} \end{align*}\]입니다. 두 경우가 있을 수 있는데, 만약 $x\gt a$이면,

\[F_X(x|A)=\frac{P(X\le a)}{P(X\le a)}=1\]이 됩니다. 만약 $x\le a$이면

\[F_X(x|A)=\frac{P(X\le x)}{P(X\le a)}=\frac{F_X(x)}{F_X(a)}\]가 됩니다. 정리하면

\[F_X(x|A)= \begin{cases} 1&(x\gt a)\\ \frac{F_X(x)}{F_X(a)}&(x\le a) \end{cases}\]입니다. 다음으로, condtional PDF $f_X(x|A)$를 구하면

\[f_X(x|A) =\frac d{dx}F_X(x|A) =\begin{cases} 0&(x\gt a)\\ \frac{f_X(x)}{F_X(a)}&(x\le a) \end{cases}\]입니다.

ex. 3.15

이번에는 PDF가

\[f_X(x)=\frac1{20},\quad 40\le x\le 60\]로 주어지고, 사건 $A$가

\[A=\{X\le 55\}\]인 경우를 보겠습니다. conditionoal CDF는

\[F_X(x|A)=P(X\le x|X\le 55) =\frac{P\left((X\le x)\cap(X\le55)\right)}{P(X\le55)} =\begin{cases} 0 &(x\lt40)\\ \frac{x-40}{15} &(40\le x\lt55)\\ 1 &(x\ge55) \end{cases}\]이고 conditionoal PDF는

\[f_X(x|A)=\frac d{dx}F_X(x|A) =\begin{cases} \frac1{15} &(40\lt x\lt55)\\ 0 &(\text{otherwise}) \end{cases}\]입니다. 또한, condtional expectation은

\[\begin{align*} E[X|A] &=\int_{x\in A}xf_X(x|A)\,dx\\ &=\int_{40}^{55}\frac1{15}x\,dx\\ &=\frac1{15}\frac12(55-40)(55+40)\\ &=\frac{95}2\\ &=47.5 \end{align*}\]입니다. 그냥 의미적으로 해석해보면, 원래 $X$는 40과 60 사이에 균일하게 분포되어 있었는데, 여기에 $X$가 55보다 작다는 조건 $A$를 준 것입니다. 그러면 이 조건 하에서 $X$는 40과 55 사이에 균일하게 분포되어 있습니다. 따라서 이 조건 하에서의 평균은 $\frac{40+55}2=47.5$가 되어야 합니다.

그런 것 치고는 위의 계산은 불필요하게 복잡한 것 같습니다. 저 위의 계산처럼 conditional density를 사용하지 않는 방법은 크게 없을 것 같습니다. conditional PDF로 바로 변환되는 것이 아니기 때문입니다. 굳이 다른 방법을 찾자면 부분적분을 사용해 conditional CDF를 사용할 수도 있을 것 같습니다.

07 여러가지 이산확률분포

3.6 Chebysev inequality

체비셰프의 부등식. 이름은 들어봤지만, 제대로 보는 것이 처음이라는 게 상당히 유감스럽습니다. 학부때 확률론을 계속해서 피해다녔더니, 이제서야 보게 되었습니다.

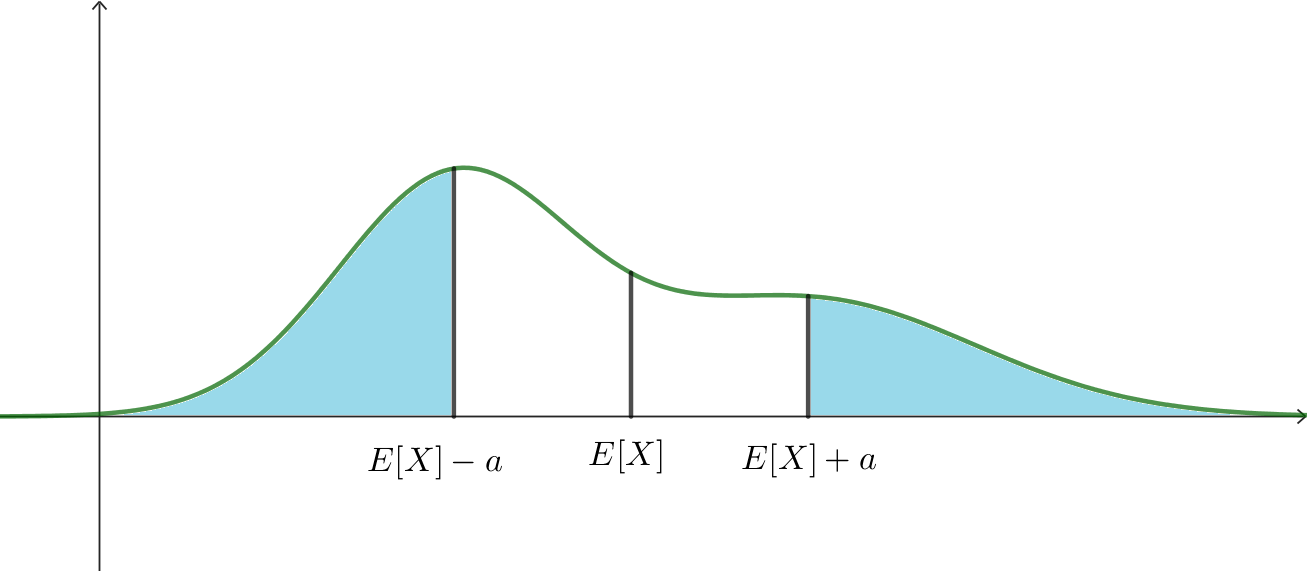

그런데, 아주 재미있는 부등식인 것 같습니다. 확률변수 $X$와 양의 실수 $a$에 대하여 아래의 부등식이 성립합니다. 이것을 Chebysev inequality라고 부릅니다.

\[P\left(\big|X-E[X]\big|\ge a\right)\le\frac{\,{\sigma_X}^2}{a^2}\]$X$가 평균으로부터 어느 정도의 간격($a$) 이상 떨어져있을 확률은 그 간격에 의존하는 어떤 값$\left(\frac{\,{\sigma_X}^2}{a^2}\right)$보다 작다는 뜻입니다.

예를 들어 $a=2\sigma_X$인 경우에 있어서의 Chebysev inequality는 $X$가 2-sigma 바깥에 있을 확률이 $\frac14$보다 작다는 것을 의미합니다;

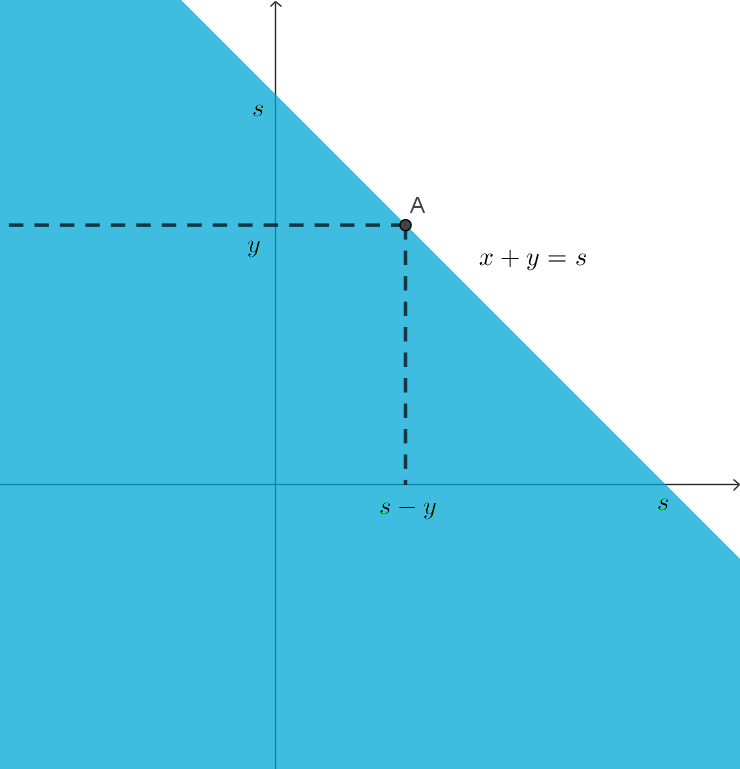

\[P\left(\big|X-E[X]\big|\ge 2\sigma_X\right)\le\frac14\]만약 정규분포의 상황을 가정하면, 아래 그림에서 하늘색으로 표시된 부분의 면적이 $\frac14$보다 작다는 것입니다.

이 부등식이 아주 tight한 것 같지는 않습니다. 만약, $X$가 정규분포를 따른다면, $a=2\sigma_X$에 대한 확률은

\[\begin{align*} P\left(|X-E[X]|\ge2\sigma_X\right) &=P\left(|Z|\ge2\right)\\ &=2\left(1-P\left(0\le Z\le2\right)\right)\\ &=2(0.5-0.47725)\\ &=0.0455 \end{align*}\]입니다(표준정규분포표의 값을 활용했습니다.) 그러니까, Chebysev inequailty를 통해 얻는 확률의 upper bound는 0.25였는데, 실제 확률의 값은 0.0455입니다. 따라서 이 경우는 Chebysev inequality의 결과를 (당연히) 만족시키기는 합니다. 그런데 그 결과라는 게 실제값보다 꽤 큽니다. 그런 의미에서 Chebysev inequality는 모든 종류의 확률변수에 대하여 일반적인 upper bound를 제시하는 것이라고 이해해야 할 것 같습니다.

연속확률변수에 대한 Chebysev inequality는, ${\sigma_X}^2$을 들여다보면 쉽게 증명됩니다.

\[\begin{align*} {\sigma_X}^2 &=\int_{-\infty}^\infty\left(x-E[X]\right)^2f_X(x)\,dx\\ &=\int_{|x-E[X]|\ge a}\left(x-E[X]\right)^2f_X(x)\,dx +\int_{|x-E[X]|\lt a}\left(x-E[X]\right)^2f_X(x)\,dx\\ &\ge a^2\int_{|x-E[X]|\ge a}f_X(x)\,dx\\ &=a^2P\left(|x-E[X]|\ge a\right) \end{align*}\\\]강의에서, 이산확률변수에 대한 증명은 조금 tricky할 수 있다고 했는데, 그래도 한 번 해보면

\[\begin{align*} {\sigma_X}^2 &=\sum_{i=1}^n\left(x_i-E[X]\right)^2P_X(x_i)\\ &=\sum_{|x_i-E[X]|\ge a}\left(x_i-E[X]\right)^2P_X(x_i) +\sum_{|x_i-E[X]|\lt a}\left(x_i-E[X]\right)^2P_X(x_i)\\ &\ge a^2\sum_{|x_i-E[X]|\ge a}P_X(x_i)\\ &=a^2P\left(|x-E[X]|\ge a\right) \end{align*}\\\]입니다. (되는데?) “expectation 값이 random variable이 아닐 수도 있다”는 말씀이 무슨 의미인지 잘 모르겠습니다. 이 사람은 제가 한 것과 똑같은 증명을 적어놓았고, wikipedia에는 conditional expectation의 성질을 사용하여 (그러니까 summation이나 integral을 사용하지 않고) 증명했습니다.

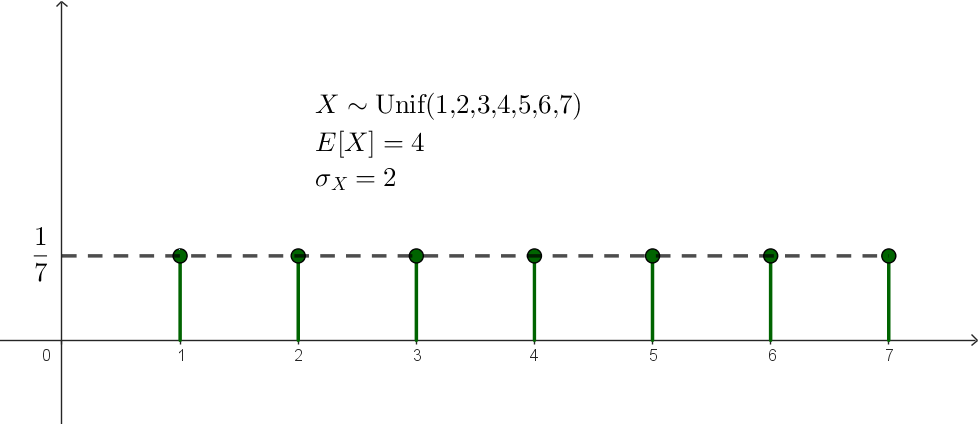

이번에는 discrete uniform한 경우의 예를 살펴봤습니다. $X$가 집합 $\{1,2,3,4,5,6,7\}$의 uniform distribution을 따를 때, $X$의 평균은

\[E[X]=4\]이고, 표준편차는

\[\sigma_X=\sqrt{\frac17\left(9+4+1+0+1+4+9\right)}=2\]입니다. Chebysev inequality의 식

\[P\left(\big|X-E[X]\big|\ge a\right)\le\frac{\,{\sigma_X}^2}{a^2}\]에서 $a=2.5$를 대입하면

\[\frac27\le\frac{2^2}{2.5^2}\]가 되어, Chebysev inequality가 여전히 성립합니다.

Chapter 4. Special Distributions

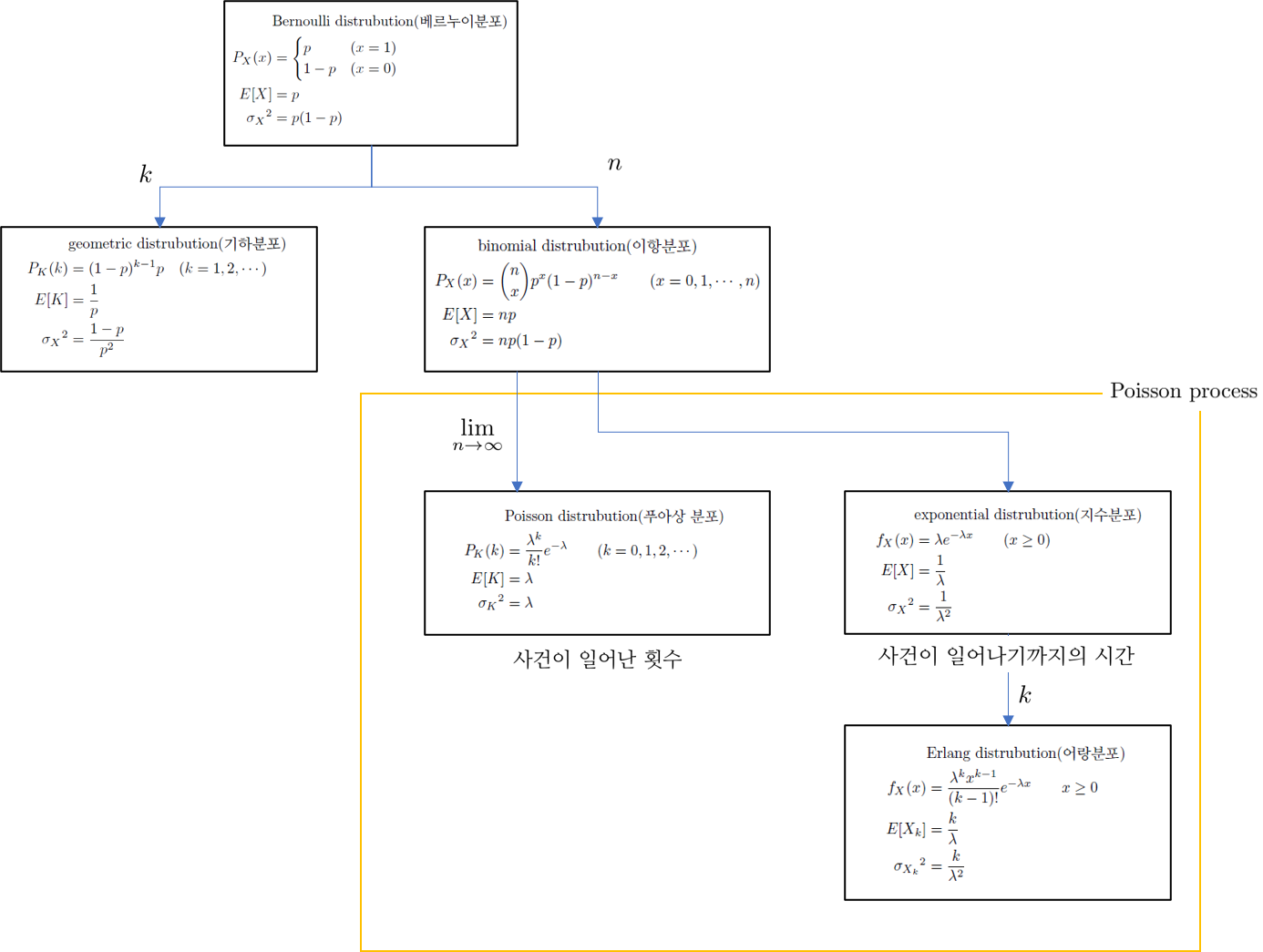

4.2 Bernoulli distribution

앞서, Bernoulli trial(베르눌리 시행)이 근원사건의 개수가 $2$개인 시행을 말한다고 했습니다. 즉, $|S|=2$인 경우

\[S=\{w_1,w_2\}\]를 말합니다. 많은 경우에 $w_1$을 ‘성공’으로, $w_2$를 ‘실패’로 해석했었습니다.

다음은 위키피디아의 정의입니다.

A Bernoulli trial (or binomial trial) is a random experiment with exactly two possible outcomes, “success” and “failure”, in which the probability of success is the same every time the experiment is conducted.

예를 들어

\[\begin{cases} X(w_1)=-2\\ X(w_2)=3 \end{cases}\]로 정의하면 이것은 Bernoulli distribution에 해당할 것 같습니다. 하지만, 통상

\[\begin{cases} X(w_1)=1\\ X(w_2)=0 \end{cases}\]인 경우를 가정합니다.

$P_X(X=1)=p$라고 하면 $P_X(X=0)=1-p$이고, 따라서 Bernoulli distribution은 오로지 하나의 값 $p$에 의해 결정되는 분포입니다. 기록을 위해 PMF를 적어보면

\[P_X(x)= \begin{cases} p &(x=1)\\ 1-p &(x=0) \end{cases} \tag{$\ast$}\]입니다.

예를 들어, 동전을 하나 던졌을 때 앞면이 나오면 $X=1$로 정하고 뒷면이 나오면 $X=0$으로 정하면, 이 시행은 Bernoulli trial이고 ; $S=\{H,T\}$, $|S|=2$, $X$의 분포는 Bernoulli distribution입니다. 그리고 $X$는

\[\begin{cases} X(H)=1\\ X(T)=0 \end{cases}\]와 같이 주어집니다.

$(\ast)$는 다음과 같이 한 줄의 식으로 쓸 수도 있습니다. (조금 쓸데없어보이기도 하고, 그냥 현학적인 표현인 것처럼 보이기도 하지만, 많은 경우에 Bernoulli distribution이 이와 같이 표현되니 알아두어도 나쁘지는 않을 것 같습니다.) 덧셈의 형태로

\[P_X(x)=(1-p)(1-x)+px,\qquad x\in\{0,1\}\]와 같이 쓸 수도 있고, 아니면 곱셈의 형태로

\[P_X(x)=p^x(1-p)^{1-x},\qquad x\in\{0,1\}\]와 같이 쓸 수도 있습니다.

Beroulli distribution는 가장 간단한 형태의 분포입니다. Bernoulli distribution보다 더 간단한 형태는 $|S|=1$인 경우겠지만, 그 경우는 확률적으로 이야기하는 것 자체가 의미가 없습니다. Bernoulli distribution의 평균과 분산은 아주 쉽게 계산됩니다.

\[\begin{align*} E[X] &=0\times P_X(0)+1\times P_X(1)\\ &=0\times(1-p)+1\times p\\ &=p\\ {\sigma_X}^2 &=(0-E[X])^2\times P_X(0)+(1-E[X])^2\times P_X(1)\\ &=(0-p)^2\times(1-p)+(1-p)^2\times p\\ &=p(1-p)\left(p+(1-p)\right)\\ &=p(1-p) \end{align*}\]4.3 binomial distribution

어떤 Bernoulli trial을 $n$번 반복적으로 시행할 때 성공의 횟수

를 $X$라고 할 때, $X$는

\[P_X(x)=\binom nxp^x(1-p)^{n-x}\qquad(x=0,1,\cdots,n)\]를 PMF로 가집니다. 이때, $X$가 이항분포를 따른다고 합니다.

위의 PMF 식의 증명은 당연하므로 생략하겠습니다. 위의 함수 $P_X$는 $x=0$, $\cdots$, $x=n$일 때에 대하여 모두 더했을 때 1이 됩니다;

\[\begin{align*} \sum_{x=0}^nP_X(x) &= \sum_{x=0}^n\binom nxp^x(1-p)^{n-x}\\ &=\left(p+(1-p)\right)^n\\ &=1 \end{align*}\]이항분포의 평균과 분산이 각각 $np$, $np(1-p)$이라는 것은 $\langle02\rangle$-(1.10.4)에서 이미 증명했습니다. 그 때에는 $(1+x)^n$을 미분하여 얻을 수 있는 성질로부터 증명했었습니다. 강의에서는 표준적인 방법 (combination의 성질)으로 증명하고 있습니다.

\[\begin{align*} E[X] &=\sum_{x=0}^nxP_X(x)\\ &=\sum_{x=0}^nx\binom nxp^x(1-p)^{n-x}\\ &=\sum_{x=1}^nx\binom nxp^x(1-p)^{n-x}\\ &\stackrel\star=\sum_{x=1}^nn\binom{n-1}{x-1}p^x(1-p)^{n-x}\\ &=np\sum_{x=1}^n\binom{n-1}{x-1}p^{x-1}(1-p)^{(n-1)-(x-1)}\\ &=np\sum_{y=0}^{n-1}\binom{n-1}yp^y(1-p)^{(n-1)-y}\\ &=np\left(p+(p-1)\right)^{n-1}\\ &=np\\ E[X^2] &=\sum_{x=0}^nx^2P_X(x)\\ &=\sum_{x=0}^nx^2\binom nxp^x(1-p)^{n-x}\\ &=\sum_{x=0}^n(x^2-x)\binom nxp^x(1-p)^{n-x}+\sum_{x=0}^nx\binom nxp^x(1-p)^{n-x}\\ &=\sum_{x=2}^nx(x-1)\binom nxp^x(1-p)^{n-x}+np\\ &\stackrel{\star\star}=\sum_{x=2}^nn(n-1)\binom{n-2}{x-2}p^x(1-p)^{n-x}+np\\ &=n(n-1)p^2\sum_{x=2}^n\binom{n-2}{x-2}p^{x-2}(1-p)^{(n-2)-(x-2)}+np\\ &=n(n-1)p^2\sum_{y=0}^{n-2}\binom{n-2}yp^y(1-p)^{(n-2)-y}+np\\ &=n(n-1)p^2\left(p+(1-p)\right)^{n-2}+np\\ &=n(n-1)p^2+np\\ &=n^2p^2-np^2+np\\ V[X] &=E[X^2]-E[X^2]\\ &=n^2p^2-np^2+np-(np)^2\\ &=np-np^2\\ &=np(1-p) \end{align*}\]위의 계산들 중 $\star$와 $\star\star$는 combination의 성질을 사용한 것입니다. $\star$만 증명하면

\[\begin{align*} x\binom nx &=x\times\frac{n!}{x!(n-x)!}\\ &=n\times\frac{(n-1)!}{(x-1)!((n-1)-(x-1))!}\\ &=n\binom{n-1}{x-1} \end{align*}\]입니다. $\star\star$도 마찬가지의 방법으로 하면 쉽게 증명될 수 있습니다.

강의에서는, 이 증명방법보다 더 간결한 증명방식도 소개합니다. 함수 $f$를

\[f(t)=\left(pt+(1-p)\right)^n=\sum_{x=0}^n\binom nxp^xt^x(1-p)^{n-x}\]와 같이 정의하고, $f’(1)$와 $f’‘(1)$을 각각 계산해보면

\[\begin{align*} f'(t)&=np\left(pt+(1-p)\right)^{n-1}&&=\sum_{x=0}^nx\binom nxp^xt^{x-1}(1-p)^{n-x}\\ f'(1)&=np\left(p+(1-p)\right)^{n-1}&&=\sum_{x=0}^nx\binom nxp^x(1-p)^{n-x}\\ &=np&&=E[X]\\ f''(t)&=n(n-1)p^2\left(pt+(1-p)\right)^{n-2}&&=\sum_{x=0}^nx(x-1)\binom nxp^xt^{x-2}(1-p)^{n-x}\\ f''(1)&=np\left(p+(1-p)\right)^{n-1}&&=\sum_{x=0}^nx(x-1)\binom nxp^x(1-p)^{n-x}\\ &=n(n-1)p^2&&=E[X^2]-E[X]\\ \end{align*}\]이 됩니다. 마지막 식을 정리하면

\[E[X^2]=n^2p^2-np^2+np\]가 되고, 이것으로 ${\sigma_X}^2$을 구하면

\[\begin{align*} {\sigma_X}^2 &=E[X^2]-E[X]^2\\ &=(n^2p^2-np^2+np)-n^2p^2\\ &=-np^2+np\\ &=np(1-p) \end{align*}\]입니다. 이와 같이 binomal distribution의 평균과 표준편차를 구할 수 있습니다.

4.4 geometric distribution

geometric distribution을 따르는 확률변수 $K$가 PMF와 평균, 분산을

\[\begin{align*} P_K(k)&=(1-p)^{k-1}p\quad(k=1,2,\cdots)\\ E[K]&=\frac1p\\ {\sigma_X}^2&=\frac{1-p}{p^2} \end{align*}\]와 같이 가진다는 것을 확인한 바 있습니다. 여기에서 $K$의 의미는

the number of Bernoulli trial until the first success

입니다. 다시 말해($\langle06\rangle$의 3.13에서 소개한 표현을 다시 쓰면),

어떤 Bernoulli trial을 반복적으로 시행할 때, $K$번째에 처음으로 성공할 경우

의 $K$값을 말합니다. 그러니까, 어떤 Bernoulli trial을 연속해서 시행할 때, 처음 $k-1$번은 실패하고 $k$번째에 성공할 경우에 확률변수 $K$를 $K=k$로 지정하면 $K$가 geometric distribution을 따른다고 합니다.

memorylessness(forgetfulness)

memoryless property란 여러 번의 Bernoulli trial에서 앞서의 결과가 이후의 결과에 영향을 미치지 않는다는 성질을 뜻합니다. 그리고, geometric distribution은 memoryless property를 가지고 있습니다.

geometric distribution을 따르는 확률변수 $X$에 대하여 $k$번째에 성공할 확률, 그러니까, $1$번째, $2$번째, $\cdots$, $k-1$번째까지는 실패했지만, $k$번째에는 성공할 확률은 $P(X=k)$입니다. geometric distribution이 memoryless property를 가진다는 것은 이 Bernoulli trial을 여러 번 시행했다고 하더라도, 이후 $k$번째에 성공할 확률이 여전히 $P(X=k)$라는 것입니다. 그러니까, $n$번의 시행 이후 $n+1$번째, $n+2$번째, $\cdots$, $n+k-1$번째까지는 실패했지만 $n+k$번째에는 성공할 확률이 $P(X=k)$와 같아야 합니다.

문제를 간단하게 하기 위해, 앞의 $n$번째의 시행이 모두 실패했다고 가정하겠습니다. 이 가정은 $X>n$이라는 식으로 표현될 수 있습니다. 그러면 구해야 하는 확률은, $1$번째, $2$번째, $\cdots$, $n$번째, $\cdots$, $n+k-1$번째까지는 실패했지만, $n+k$번째에는 성공할 확률을 구해야 합니다. 이것은 $X=n+k$라는 식으로 표현될 수 있습니다.

따라서, $n$번째까지의 시행이 모두 실패했다고 가정했을 때, 그 이후 $k$번째에 성공할 확률은 $P(X=n+k|X>n)$으로 표현될 수 있습니다. 이것이 $P(X=k)$와 같은지를 확인해보려고 합니다. 실제로 계산해보면

\[\begin{align*} P\left(X=n+k|X>n\right) &=\frac{P\left((X=n+k)\cap(X>n)\right)}{P(X>n)}\\[10pt] &=\frac{P\left(X=n+k\right)}{P(X>n)}\\[15pt] &=\frac{(1-p)^{n+k-1}p}{\sum_{x\ge n+1}(1-p)^{x-1}p}\\[15pt] &=\frac{(1-p)^{n+k-1}}{\sum_{x\ge n+1}(1-p)^{x-1}}\\[15pt] &=\frac{(1-p)^{n+k-1}}{\frac{(1-p)^n}{1-(1-p)}}\\[15pt] &=(1-p)^{k-1}p\\ &=P\left(X=k\right) \end{align*}\]입니다. 따라서 geometric distribution에 대해서는 memoryless property가 성립합니다. 즉, 지금 하는 것은 독립시행이므로, 앞서의 결과가 이후의 시행에 영향을 미치지 않는 것이 당연한데, 그 사실을 다시 한 번 확인해본 것입니다.

08 지수분포와 어랑분포

4.7 Poisson distribution

Poisson distribution을 따르는 확률변수 $K$가 PMF와 평균, 분산을

\[\begin{align*} P_K(k)&=\frac{\lambda^k}{k!}e^{-\lambda}\qquad(k=0,1,2,\cdots)\\ E[K]&=\lambda\\ {\sigma_K}^2&=\lambda \end{align*}\]와 같이 가진다는 것을 확인한 바 있습니다. 여기에서 $K$의 의미는

the number of Bernoulli success in a time interval

였습니다. $\langle05\rangle$ 3.3에서 소개한 표현을 다시 쓰면

단위시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 기대될 때, 단위시간동안 사건이 일어난 횟수

을 말합니다. 그런데, PMF의 식에서 ‘단위시간’이라는 것은 전제되어 있지 않습니다. 그리고 생각해보면, universal한 의미의 ‘단위시간’이라는 건 없습니다. 그래서 $K$의 의미를

$t$시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 기대될 때, $t$시간동안 사건이 일어난 횟수

라고 정해도 상관 없습니다.

어떤 사건이 일어난다는 것은, 그 자체로 Bernoulli trial이라고 볼 수 있습니다. (사건이 일어난다 / 일어나지 않는다)와 같이 두 가능성 중 하나가 발생되는 것이기 때문입니다. 어떤 사건이 일정한 비율로 일어나는 경향을 보일 때, 특정한 시간 간격동안 어떤 사건이 일어난 횟수를 $K$라고 할 수 있는 것입니다.

(wikipedia)에는 다음과 같이 적혀있습니다.

The Poisson distribution is a discrete probability distribution that expresses the probability of a given number of events occurring in a fixed interval of time or space if these events occur with a known constant mean rate and independently of the time since the last event.

For instance, a call center receives an average of 180 calls per hour, 24 hours a day. The calls are independent; receiving one does not change the probability of when the next one will arrive. The number of calls received during any minute has a Poisson probability distribution with mean 3: the most likely numbers are 2 and 3 but 1 and 4 are also likely and there is a small probability of it being as low as zero and a very small probability it could be 10.

Another example is the number of decay events that occur from a radioactive source during a defined observation period.

Poisson PMF의 식의 의미를 여러가지로 알아보다가 아주 재미있는 결과를 발견했습니다. 이 결과를 사용하면, Poisson PMF의 의미를 더 정확하게 알 수 있습니다. 그 내용은 이렇습니다. binomial PMF인

\[P_X(k)=\binom nkp^k(1-p)^{n-k}\]에서 $n$을 무한대로 보내면, Poisson PMF의 모양이 됩니다.

\[\lim_{n\to\infty}\binom nkp^k(1-p)^{n-k}= \frac{\lambda^k}{k!}e^{-\lambda}\]단, $\lambda$는 $p=\frac\lambda n$으로 주어집니다. 이에 대한 증명은 어렵지 않은데

\[\begin{align*} \lim_{n\to\infty}\binom nkp^k(1-p)^{n-k} =&\lim_{n\to\infty}\frac{n(n-1)(n-2)\cdots(n-k+1)}{k!}\left(\frac\lambda n\right)^k\left(1-\frac\lambda n\right)^{n-k}\\ =&\lim_{n\to\infty}\frac{n(n-1)(n-2)\cdots(n-k+1)}{n^k}\frac{\lambda^k}{k!}\left(1-\frac\lambda n\right)^{n-k}\\ =&\frac{\lambda^k}{k!} \lim_{n\to\infty}\frac{n-1}n \times\lim_{n\to\infty}\frac{n-2}n \times\cdots \times\lim_{n\to\infty}\frac{n-k+1}n \times\lim_{n\to\infty} \left(1-\frac\lambda n\right)^{n-k}\\ =&\frac{\lambda^k}{k!}\lim_{n\to\infty}\left(1-\frac\lambda n\right)^{n-k}\\ =&\frac{\lambda^k}{k!} \lim_{n\to\infty}\left(1-\frac\lambda n\right)^n \lim_{n\to\infty}\left(1-\frac\lambda n\right)^{-k}\\ =&\frac{\lambda^k}{k!} \lim_{n\to\infty}\left(\left(1-\frac\lambda n\right)^{-\frac n\lambda}\right)^{-\lambda}\times1\\ =&\frac{\lambda^k}{k!} \left(\lim_{n\to\infty}\left(1-\frac\lambda n\right)^{-\frac n\lambda}\right)^{-\lambda}\\ =&\frac{\lambda^k}{k!}e^{-\lambda} \end{align*}\]이기 때문입니다.

Poisson PMF의 정확한 의미를 알기 위해서 DeGroot, Probability and Statistics, 4ed의 Example 5.4.1, 5.4.2를 읽어봤습니다. 설명이 잘 되어 있어서, 여기에 소개해보면 다음과 같습니다.

어떤 가게에 손님이 한 시간에 4.5명 꼴로 들어옵니다. 그럴 때에, 어느 날의 어느 시각으로부터 한 시간동안 들어온 손님의 수를 $X$라고 하면, $X$의 분포를 어떻게 이해하면 좋을지 생각해볼 수 있습니다.

그 답은 $\lambda=4.5$로 하는 Poisson distribution입니다.

위 문제를 풀기 위해 할 수 있는 자연스러운 방법은, 한 시간을 작은 시간단위로 쪼개는 것입니다. 예를 들어 1초 단위로 쪼개본다고 하겠습니다(1시간 = 3600초). 어느 날의 어느 시각으로부터 한 시간동안(예를 들어, 어느 날 오후 1시부터 오후 2시까지)의 시간을

- 1시 00분 00초 ~ 1시 00분 01초 : $T_1$

- 1시 00분 01초 ~ 1시 00분 02초 : $T_2$

$\qquad\vdots$

- 1시 59분 59초 ~ 2시 00분 00초 : $T_{3600}$

의 3600개 시간간격으로 나눌 수 있는 것입니다. 1시간에 4.5명 꼴로 손님이 들어온다고 했으니까, 1초에 $4.5/3600=0.00125$명 꼴로 손님이 들어옵니다. 그러니까 각각의 $T_i$ 동안 0.00125명 꼴로 손님이 들어옵니다. 그러면, $T_i$ 동안 손님이 들어오는 횟수는 거의 0입니다. 어쩌다가 한 명 들어오는 것이고 두 명 이상 들어올 가능성은 거의 없습니다. (실제로는 친구나 가족과 함께 방문할 수도 있으므로 현재로서는 이 가정이 좋은 가정은 아닐테지만, 어쨌든 수치상으로는 그렇습니다.) 그러니까 각각의 $T_i$에 대하여 손님이 들어오지 않거나(0명), 아니면 들어오거나(1명) 한다고 가정할 수 있습니다. 즉, 한 번의 시행은 그 결과값이 0 아니면 1인 Bernoulli trial이고 이때 $p=0.00125$입니다. 그런데 이런 시행이 한 번 있는 것이 아니라 3600번 있습니다. 각각의 시행들이 독립적이라고 가정하면, $X$는 $B(3600, 0.00125)$인 이항분포를 따릅니다. 따라서 한 시간동안 들어온 손님의 수가 $x$인 확률은

\[P(X=x)=\binom{3600}x(0.00125)^x(0.99875)^{3600-x}\tag{$\ast$}\]입니다.

그런데 한 시간을 1초 단위로 자른 것은, 그냥 1초가 익숙해서 그렇게 한 것이지 어떤 특별한 의미가 있는 것은 아닙니다. 예를 들어 0.1초로 자를 수도 있습니다. 그 경우에는 총 36000개의 시간간격이 존재할 것이고 $X$는 $B(36000,0.000125)$를 따를 것이며

\[P(X=x)=\binom{36000}x(0.000125)^x(0.999875)^{36000-x}\tag{$\ast\ast$}\]이 될 것입니다. 그리고 이 때에는 아까의 가정(하나의 시간간격동안 2명 이상 들어오지 않는다는 가정)이 더 그럴듯하게 성립할 것이므로 $(\ast\ast)$의 분포는 $(\ast)$의 분포보다 더 괜찮은 (현상을 잘 반영하는) 분포일 것입니다. 심지어는, 아무리 친구 두 명이서 함께 가게를 방문한다고 하더라도, 두 명의 사람이 가게에 들어오는 시각에는 미세하게 차이가 있을 것이므로 시간간격을 충분히 줄이면 이 가정은 항상 성립한다고 말할 수도 있을 것입니다. 그래서 3600, 36000이었던 값을 양의 무한대로 보내버리고, 아까의 계산결과를 적용하면

\[P(X=x) =\lim_{n\to\infty} \binom nx\left(\frac{4.5}n\right)^x\left(1-\frac{4.5}n\right)^{n-x} =\frac{4.5^x}{x!}e^{-4.5}\]이 되는데 이것은 $\lambda=4.5$인 Poisson PMF입니다. $\square$

Poisson distribution에 대한 위의 설명은, 1시간동안 손님이 $4.5$명 들어오는 경향이 있다면, 30분동안에는 $2.25$명의 손님이 들어온다는 식의 가정에 근거하고 있습니다. 즉, $t$시간 동안에는 $4.5t$명의 손님이 들어온다고 가정하고 있습니다. 또한, 각각의 손님들이 들어오는 사건이 독립적이라는 가정도 깔려 있습니다. 즉, Poisson PMF의 의미가 설명되기 위해서는 위의 두 가정이 전제되어야 합니다. 위의 두 가정이 성립하는 상황을 Poisson process라고 이름붙입니다. 정확한 정의는 다음과 같습니다. (출처 : DeGroot, Probability and Statistics, 4ed , definition 5.4.2)

어떤 사건에 대한 단위시간당 발생비율이 $\lambda$인 Poisson process는 다음의 두 조건을 만족시키는 (stochastic) process입니다.

- 길이가 $\lambda t$인 시간간격 동안 사건이 일어나는 횟수는 Poisson distribution을 따르고, 그 평균이 $\lambda t$입니다.

- 겹치지 않는 두 개의 시간간격에 대하여 사건이 일어난 횟수는 독립적입니다.

4.8 exponential distribution

exponential distribution을 따르는 확률변수 $X$가 PDF와 평균, 분산을

\[\begin{align*} f_X(x)&=\lambda e^{-\lambda x}\qquad(x\ge0)\\ E[X]&=\frac1\lambda\\ {\sigma_X}^2&=\frac1{\lambda^2} \end{align*}\]와 같이 가진다는 것을 확인한 바 있습니다.

그리고

단위시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 기대될 때, 사건이 발생하기까지의 시간

을 $X$라고 하면, $X$는 exponential distribution을 따릅니다. 다시 말해, $X$가 위의 식을 PMF로 가집니다. 이것은 이따가 Poisson disribution과의 관계를 통해 증명하겠습니다.

Bernoulli trial의 근원사건들의 의미를 죽음(death)과 생존(survival)이라고 한다면, $X$는 생존시간을 의미한다고도 볼 수 있습니다.

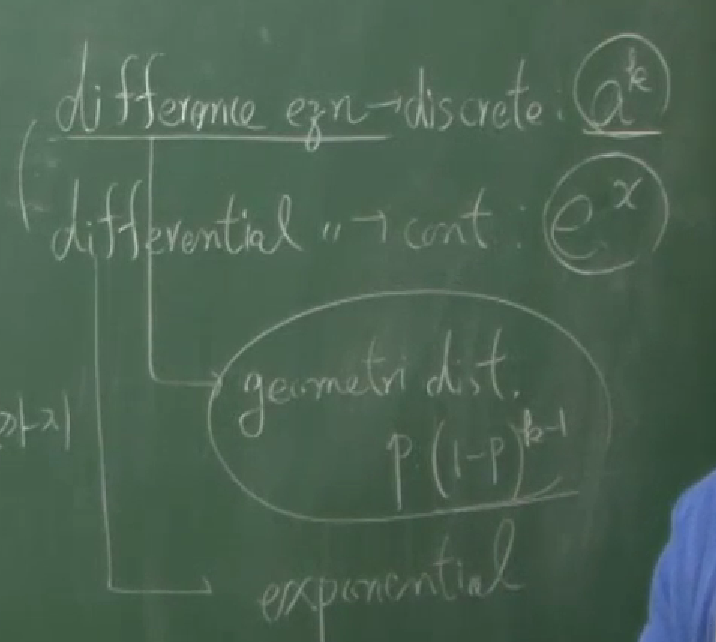

difference equations and differential equations

강의에서는 geometric distribution과 exponential distribution은 각각 선형대수에서의 difference equation/differential equation (차분방정식/미분방정식)과 연관이 있다고 설명합니다. G. Strang, Linear Algebra and Its Applications, 4ed와 같은 선형대수 책에서, 행렬의 대각화에 대한 활용으로 언급되는 것이

- 5.3 Difference Equations and Powers $A^k$

- 5.4 Differential Equations and $e^{\lambda t}$

입니다.

5.3에서는 difference equation에 대해 다룹니다. 가장 간단하게 생각해볼 수 있는 예는 피보나치 수열입니다. 피보나치 수열의 $k$번째 항을 $F_k$라고 쓰면

\[\begin{align*} F_{k+2}&=F_k+F_{k+1}\\ F_{k+1}&=F_{k+1} \end{align*}\]이 성립합니다. 연속된 두 피보나치 항을 하나의 벡터로 두면 이것은

\[\begin{bmatrix} F_{k+2}\\ F_{k+1} \end{bmatrix} = \begin{bmatrix} 1&1\\ 1&0 \end{bmatrix} \begin{bmatrix} F_{k+1}\\ F_k \end{bmatrix}\]와 같은 행렬식으로 표현될 수 있습니다. 위와 같은 식을 difference equation(점화식, 차분식, recurrence equation)이라고 합니다. 이 difference equation을 풀어 일반항을 얻는 과정에서 정사각행렬의 거듭제곱이 등장하는데, 이를 간단하게 하기 위해서 (당연히) 행렬의 대각화를 사용합니다. 그 결과로, 피보나치 수열의 일반식에는 eigenvalues들의 거듭제곱이 수반됩니다 ;

\[\begin{align*} u_k&=c_1{\lambda_1}^kx_1+c_2{\lambda_2}^kx_2\\ F_k&=c_1{\lambda_1}^k+c_2{\lambda_2}^k \end{align*}\]5.4에서는 연립상미분방정식(system of ordinary differential equations)의 풀이에 대해 다룹니다. difference equation에서 $\lambda^n$과 같은 형태가 핵심이었던 것과 대응되게, differential equation에서는 $e^{At}$와 같은 행렬의 exponentiation이 핵심입니다. 더 깊은 의미가 있겠지만, 어쨌든 그런 의미에서 geometric distribution과 difference equation이 대응되고, exponential distribution과 differential equation이 대응된다고 하는 것 같습니다.

memoryless property

이전 강의에서 geometric distribution이 memoryless property를 가지고 있음이 설명되었습니다. exponetial distribution도 마찬가지로 momoryless property를 가진다는 내용이 강의에 이어집니다.

앞서, exponential distribution을 따르는 확률변수 $X$를 ‘생존시간’ 혹은 ‘어떤 사건이 일어나기까지의 시간’으로 해석할 수 있다고 했었습니다. 이때, $s$ 시간 안에 죽을 확률, 혹은 $s$ 시간 안에 사건이 일어날 확률은 $P(X\le s)$로 쓸 수 있을 것입니다. exponential distribution이 memoryless property를 가진다는 것은, $t$ 시점까지 어떤 일이 일어났는지와는 상관없이, 이후의 $s$ 시간 안에 죽을 확률, 혹은 $s$ 시간 안에 사건이 일어날 확률이 $P(X\le s)$와 같다는 것입니다.

이번에도 문제를 간단하게 하기 위해, $t$ 시점까지 생존했다고(사건이 발생하지 않았다고) 가정하겠습니다. 이 가정은 $X\gt t$라는 식으로 쓸 수 있습니다. 그리고 구해야 하는 확률은, $t+s$ 시점 내에 죽을(사건이 발생할) 확률입니다. 이것은 $X\le t+s$로 쓸 수 있습니다.

따라서, $t$ 시점까지 생존했다고 가정했을 때, 그 이후 $t+s$ 시점 내에 죽을 확률 ($t$ 시점까지 사건이 발생하지 않았다고 가정했을 때, 그 이후 $t+s$시점 내에 사건이 발생할 확률)은 $P(X\le t+s|X\gt t)$로 표현될 수 있습니다. 이것이 $P(X\le s)$와 같은지를 보려고 합니다.

계산에 앞서 exponential distribution에 대한 CDF를 먼저 계산해보면

\[\begin{align*} F_X(x) &=\int_0^xf_X(\tilde x)\,d\tilde x\\ &=\int_0^x\lambda e^{-\lambda\tilde x}\,d\tilde x\\ &=1-e^{-\lambda x} \end{align*}\]입니다. 계산해보면

\[\begin{align*} P\left(X\le t+s|X>t\right) &=\frac{P\left((X\le t+s)\cap(X>t)\right)}{P(X>t)}\\ &=\frac{P\left(t<X\le t+s\right)}{1-P(X\le t)}\\ &=\frac{F_X(t+s)-F_X(t)}{1-F_X(t)}\\ &=\frac{e^{-\lambda t}-e^{-\lambda(t+s)}}{e^{-\lambda t}}\\ &=1-e^{-\lambda s}\\ &=F_X(s)\\ &=P(X\le s) \end{align*}\]입니다. 따라서 exponential distribution에 대해서 memoryless property가 성립합니다.

relation between ED and PD

exponential distribution과 Poisson distribution 사이의 관계를 보려고 합니다. 이를 통해, 만약 $X$가

단위시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 기대될 때, 사건이 발생하기까지의 시간

이면, $X$는 exponential PDF인

\[f_X(x)=\lambda e^{-\lambda x}\qquad(x\ge0)\]를 가진다는 것을 보려고 합니다.

단위시간동안 평균적으로 $\lambda$번의 사건이 일어난다고 가정하고 $X$를 사건이 발생하기까지의 기간이라고 하겠습니다. 그러면, 길이가 $t$인 시간간격 동안에는 평균적으로 $\lambda t$번의 사건이 일어난다고 기대할 수 있습니다. 따라서, 길이가 $t$인 시간간격동안 사건이 발생한 횟수를 $K$라고 하면 $K$는 평균이 $\lambda t$인 Poisson distribution을 따릅니다. 따라서 $K$의 PMF는

\[P_K(k)=\frac{\lambda^kt^k}{k!}e^{-\lambda t}\qquad(k=0,1,2,\cdots)\]가 됩니다.

그러면, 길이가 $t$인 시간간격동안 한번도 사건이 발생하지 않을 확률 $P(\text{no event})$은

\[P(\text{no event})=P(K=0)=P_K(0)=e^{-\lambda t}\]이고 길이가 $t$인 시간간격동안 적어도 한 번 사건이 발생할 확률 $P(\text{at least one event})$는

\[P(\text{at least one event})=1-P(\text{no event})=1-e^{-\lambda t}\]입니다. 그런데 $X$를 ‘사건이 발생하기까지의 기간’으로 해석하기로 했으므로

\[P(\text{at least one event})=P(X\le t)=F_X(t)\]입니다. 다시 말해,

\[F_X(t)=1-e^{-\lambda t}\]입니다. 이것을 친숙한 변수 $x$로 다시 쓰면

\[F_X(x)=1-e^{-\lambda x}\]이 되고, 이걸 미분하면

\[f_X(x)=\lambda e^{-\lambda x}\]가 얻어집니다. $\square$

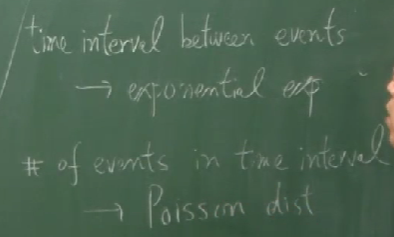

다시 정리하면, 매시각마다 일정한 비율로 일어나는 어떤 사건이 있을 때,

- 사건이 일어나는 데 걸리는 시간은 exponential distribution을 따르고

- 일정한 시간간격 동안 사건이 일어난 횟수는 Poisson distribution을 따른다

고 할 수 있습니다. 또한,

- 사건들 사이의 시간간격은 exponential distribution을 따른다

고 말할 수도 있습니다.

4.9 Erlang distribution

Erlang-$k$ distribution is a generalization of expoential distribution.

어떤 사건이 발생하는 간격은 exponetial distribution을 따른다고 했었습니다. 즉, 시각 $T_1$에 처음 사건이 발생하고 그 다음 사건이 시각 $T_2$에 발생했다면 $T_2-T_1$은 exponential distribution을 따릅니다. 다시 말해, exponential distribution은 한 개의 사건발생간격과 관련있습니다.

Erlang-$2$ distribution은 두 개의 사건발생간격을 고려합니다. 시각 $T_1$에 처음 사건이 발생하고 그 다음 사건이 시각 $T_2$에 발생하며, 또 그 다음 사건이 시각 $T_3$에 발생하면, $T_3-T_1$이 따르는 분포가 $k=2$인 Erlang distribution입니다.

(물론, $T_2-T_1$ 말고도 $T_3-T_2$, $T_4-T_3$도 exponential distribution을 따릅니다. 마찬가지로 $T_3-T_1$ 말고도 $T_4-T_2$, $T_5-T_3$도 $k=2$인 Erlang distribution을 따릅니다.)

그 연장선상에서 보면 $T_4-T_1$은 Erlang-$3$ distribution을, $T_5-T_1$은 Erlang-$4$ distribution을 따른다고 말할 수 있습니다.

Erlang-$k$ distribution($k$-order Erlang distribution)의 PMF는

\[f_X(x)=\frac{\lambda^kx^{k-1}}{(k-1)!}e^{-\lambda x}\qquad x\ge0 \tag{$\ast$}\]입니다. 이 식은 $\langle16\rangle$에서 배우는 convolution의 개념을 통해 증명할 수 있습니다. $\langle15\rangle$

gamma function

Erlang distribution의 계산을 돕기 위해 gamma function을 다음과 같이 정의합니다.

\[\Gamma(k)=\int_0^\infty x^{k-1}e^{-x}\,dx\tag{$\ast\ast$}\]특별히 $k$가 자연수일 때 $\Gamma(k)$는 순열(팩토리얼)의 형태가 됩니다;

\[\Gamma(k)=(k-1)!\qquad(k=1,2,\cdots)\tag{$\ast\ast\ast$}\]이것은 $k$에 대한 귀납법으로 쉽게 증명될 수 있습니다. $k=1$이면

\[\begin{align*} \Gamma(1) &=\int_0^\infty e^{-x}\,dx\\ &=\left[-e^{-x}\right]_0^\infty\\ &=1-0\\ &=0! \end{align*}\]입니다. $k-1$인 경우의 $(\ast\ast\ast)$이 성립한다고 가정하면, 즉, $\Gamma(k-1)=(k-2)!$을 가정하면 부분적분에 의해

\[\begin{align*} \Gamma(k) &=\int_0^\infty x^{k-1}e^{-x}\,dx\\ &=\left[-x^{k-1}e^{-x}\right]_0^\infty+\int_0^\infty (k-1)x^{k-2}e^{-x}\,dx\\ &=(0-0)+(k-1)\Gamma(k-1)\\ &=(k-1)(k-2)!\\ &=(k-1)! \end{align*}\]이 됩니다. $\square$

gamma function의 정의 ($\ast\ast$)에서 $k$는 양의 정수(자연수)로 둘 수도 있고 양의 실수로 둘 수도 있습니다. 심지어는 실수부분이 양수인 복소수로 둘 수 있다고 합니다. (출처 : wikipedia) 그런 의미에서, gamma function은 팩토리얼의 개념을 일반화한 것이라고 볼 수 있습니다. 예를 들어,

$\frac12!$을 어떻게 정의할까?

하는 질문에 $\frac12!=\Gamma(\frac32)$ 로 정의해볼 수 있는 것입니다.

이제, Erlang distribution에 관한 $(\ast)$ 식이 정말로 PDF의 역할을 하는 지 살펴보기 위해 계산해보면

\[\begin{align*} \int_0^\infty f_{X_k}(x)\,dx &=\int_0^\infty\frac{\lambda^kx^{k-1}}{(k-1)!}e^{-\lambda x}\,dx\\ &=\frac{\lambda^k}{(k-1)!}\int_0^\infty x^{k-1}e^{-\lambda x}\,dx\\ &=\frac{\lambda^k}{(k-1)!}\int_0^\infty (\lambda x)^{k-1}\cdot\frac1{\lambda^{k-1}}e^{-\lambda x}\frac1{\lambda}\,d(\lambda x)\\ &=\frac1{(k-1)!}\int_0^\infty u^{k-1}e^{-u}\,du\\ &=\frac1{(k-1)!}\Gamma(k)\\ &=1 \end{align*}\]입니다. 평균을 계산해보면

\[\begin{align*} E[X] &=\int_0^\infty x\cdot\frac{\lambda^kx^{k-1}}{(k-1)!}e^{-\lambda x}\,dx\\ &=\frac{\lambda^k}{(k-1)!}\underline{\int_0^\infty x^ke^{-\lambda x}\,dx}\\ &=\frac{\lambda^k}{(k-1)!}\left( \left[-\frac{x^k}\lambda e^{-\lambda x}\right]_0^\infty +\frac k{\lambda}\int_0^\infty x^{k-1}e^{-\lambda x}\,dx\right)\\ &=\frac{\lambda^k}{(k-1)!}\left(0+\frac k{\lambda^{k+1}} \int_0^\infty(\lambda x)^{k-1}e^{-\lambda x}\,d(\lambda x)\right)\\ &=\frac{\lambda^k}{(k-1)!}\times\frac k{\lambda^{k+1}} \int_0^\infty u^{k-1}e^{-u}\,du\\ &=\frac{\lambda^k}{(k-1)!}\times \underline{\frac k{\lambda^{k+1}}\times\Gamma(k)}\\ &=\frac k{\lambda} \end{align*}\]이고 분산을 계산하기 위해 $E[X^2]$를 계산해보면

\[\begin{align*} E[X^2] &=\int_0^\infty x^2\cdot\frac{\lambda^kx^{k-1}}{(k-1)!}e^{-\lambda x}\,dx\\ &=\frac{\lambda^k}{(k-1)!}\int_0^\infty x^{k+1}e^{-\lambda x}\,dx\\ &=\frac{\lambda^k}{(k-1)!}\left( \left[-\frac{x^{k+1}}{\lambda}e^{-\lambda x}\right]_0^\infty +\frac{k+1}\lambda\int_0^\infty x^ke^{-\lambda x}\,dx\right)\\ &=\frac{\lambda^k}{(k-1)!}\times\frac{k+1}\lambda\times\frac k{\lambda^{k+1}}\times\Gamma(k)\\ &=\frac{k(k+1)}{\lambda^2} \end{align*}\]입니다. 계산과정의 세번째 줄에서 네번째 줄로 넘어가는 것은 $E[X]$의 계산에서 밑줄친 두 값이 같다는 것을 활용한 것입니다. 분산을 계산하면

\[{\sigma_{X_k}}^2=E[X^2]-E[X]^2=\frac k{\lambda^2}\]이 됩니다.

이 결과들을 exponential distribution의 평균과 분산과의 관계와 연결지어 해석해보면 다음과 같습니다. 어떤 사건이 시각 $T_0$ $T_1$, $T_2$, $T_3$, $\cdots$, $T_k$에 일어난다고 가정할 때, $T_1-T_0$, $T_2-T_1$, $\cdots$, $T_k-T_{k-1}$은 모두 exponential distribution을 따른다고 했습니다. 반면, $T_2-T_0$, $T_3-T_1$, $\cdots$, $T_k-T_{k-2}$는 Erlang-$2$ distribution을 따릅니다. 마찬가지로, $T_3-T_0$, $T_4-T_1$, $\cdots$, $T_k-T_{k-3}$는 Erlang-$3$ distribution을 따릅니다. 그리고 $T_k-T_0$는 Erlang-$k$ distribution을 따른다고 했습니다.

그러면, exponential distribution을 따르는 두 확률분포를 더하면 그것은 Erlang-$2$ distribution을 따른다고 볼 수 있습니다;

\[(T_1-T_0)+(T_2-T_1)=T_2-T_0\]그리고, exponential distribution을 따르는 $k$개의 확률분포를 더하면 그것은 Erlang-$k$ distribution을 따른다고 볼 수 있습니다;

\[(T_1-T_0)+(T_2-T_1)+\cdots+(T_k-T_{k-1})=T_k-T_0\]만약, exponential distribution을 따르는 각각의 확률변수들을

\[T_1-T_0=X^{(1)},\quad T_2-T_1=X^{(2)},\quad \cdots,\quad T_k-T_{k-1}=X^{(k)}\]으로 표기하고 $X_k=T_k-T_0$이라고 하면,

\[X^{(1)}+X^{(2)}+\cdots+X^{(k)}=X_k\]인 것입니다. 따라서

\[\begin{align*} E[X_k] &=E\left[X^{(1)}+X^{(2)}+\cdots+X^{(k)}\right]\\ &\stackrel{\star}=E[X^{(1)}]+E[X^{(2)}]+\cdots+E[X^{(k)}]\\ &=\frac1\lambda+\frac1\lambda+\cdots+\frac1\lambda\\ &=\frac k\lambda. \end{align*}\]라고 생각할 수 있습니다. 이것은 아까 계산한 Erlang-$k$ distribution의 평균과 정확히 일치합니다. 여기에서 $(\star)$의 과정은 직관적으로는 당연하지만, 엄밀하게는 아직 논할 수 없습니다. 그리고 ‘각 사건의 발생이 독립적이다’와 같은 가정이 있어야 저 과정이 정당화될 수 있을 것입니다.

강의에서는 나중에 convolution의 개념을 배우고 나서 저 $(\star)$ 과정을 제대로 설명할 수 있다고 말합니다. 그런데 정말로 그런 것이, 만약 $X^{(i)}$들이 0과 자연수의 값을 가진다고 가정하고(discrete) $X_2=T_2-T_0=X^{(1)}+X^{(2)}$의 PMF를 $X^{(1)}$의 PMF와 $X^{(2)}$의 PMF로 구하려고 한다면

\[\begin{align*} P_{X_2}(x) &=P(X_2=x)\\ &=P(X^{(1)}+X^{(2)}=x)\\ &=P\left((X^{(1)}=0)\cap(X^{(2)}=x)\right) +P\left((X^{(1)}=1)\cap(X^{(2)}=x-1)\right) +\cdots +P\left((X^{(1)}=x)\cap(X^{(2)}=0)\right)\\ &=\sum_{i=1}^xP\left((X^{(1)}=i)\cap(X^{(2)}=x-i)\right)\\ &=\sum_{i=1}^xP(X^{(1)}=i)\times P(X^{(2)}=x-i)\\ &=\sum_{i=1}^xP_{X^{(1)}}(i)\times P_{X^{(2)}}(x-i)\\ \end{align*}\]와 같은 꼴이 되어, $P_{X_2}$가 $P_{X^{(1)}}$와 $P_{X^{(1)}}$의 convolution 형태로 나타나기 때문인 것 같습니다. (exponential distribution과 Erlang distribution의 원래 정의에서처럼 PDF로 계산하는 경우에는 summation이 아닌 적분과 관련된 식으로 convolution 식이 나옵니다.)

분산에 대해서도 비슷한 해석을 할 수 있다고 하는데, 사실 강의에서의 설명은 잘 이해하지는 못했습니다. 하지만, 다음과 같이 해석하면 되지 않을까 싶습니다. $X^{(1)}$, $X^{(2)}$, $\cdots$, $X^{(k)}$가 모두 평균 $\mu$를 가지고 분산 $\sigma^2$를 가지는 동일한 분포를 따를 때, 이것들의 산술평균인 $\overline X = \frac1k(X^{(1)}+\cdots+X^{(k)})$는 평균이 $\mu$이고 분산이 $\frac{\sigma^2}k$임이 알려져있습니다(표본평균의 평균과 분산). 그러니까,

\[\begin{align*} \sigma_{X_k} &=V[X_k]\\ &=V[X^{(1)}+X^{(2)}+\cdots X^{(k)}]\\ &=V[k\overline X]\\ &=k^2V[\overline X]\\ &=k^2\times\frac{\sigma^2}k\\ &=k\sigma^2\\ &=kV[X^{(1)}]\\ &=\frac{k}{\lambda^2} \end{align*}\]이 되어 앞서 계산의 결과와 일치합니다.

마지막으로, $X_k$의 CDF를 계산해봅니다. 이 계산은 gamma function을 직접적으로 사용할 수 없습니다. wikipedia 등에 따르면 위에서 정의한 gamma function에서 더 나아간 incomplete gamma function 과 같은 함수를 사용하면 $X_k$의 CDF를 계산하는 것이 더 쉬워지는 것으로 보이는데, 여기에서는 그냥 부분적분과 귀납법을 사용해 계산하겠습니다. 실제 강의에서도 부분적분을 연속적으로 사용하여 계산할 수 있다고 언급되고 있습니다.

\[\begin{align*} F_{X_k}(x) &=\int_0^xf_{X_k}(t)\,dt\\ &=\int_0^x\frac{\lambda^kt^{k-1}}{(k-1)!}e^{-\lambda t}\,dt\\ &=\frac{\lambda^k}{(k-1)!}\int_0^xt^{k-1}e^{-\lambda t}\,dt\\ &=\frac1{(k-1)!}\int_0^{\lambda x}(\lambda t)^{k-1}e^{-\lambda t}\,d(\lambda t)\\ &=\frac1{(k-1)!}\int_0^{\lambda x}u^{k-1}e^{-u}\,du\\ &\stackrel{\star\star}=1-\sum_{n=0}^{k-1}\frac{(\lambda x)^n}{n!}e^{-\lambda x} \end{align*}\]$\star\star$를 수학적 귀납법으로 증명하겠습니다. $k=1$인 경우는

\[\begin{align*} \text{LHS} &=\frac1{0!}\int_0^{\lambda x}u^0e^{-u}\,du\\ &=\left[-e^{-u}\right]_0^{\lambda x}\\ &=1-e^{-\lambda x}\\ &=1-\sum_{n=0}^0\frac{(\lambda x)^n}{n!}e^{-\lambda x}\\ &=\text{RHS} \end{align*}\]가 되어 성립합니다. $k$의 경우를 성립한다고 가정하고 $k+1$인 경우를 고려하면

\[\begin{align*} \text{LHS} &=\frac1{k!}\int_0^{\lambda x}u^ke^{-u}\,du\\ &=\frac1{k!}\left(\left[-u^ke^{-u}\right]_0^{\lambda x} +k\int_0^{\lambda x}u^{k-1}e^{-u}\,du\right)\\ &=-\frac1{k!}(\lambda x)^ke^{-\lambda x} +\frac1{(k-1)!}\int_0^{\lambda x}u^{k-1}e^{-u}\,du\\ &=-\frac{(\lambda x)^k}{k!}e^{-\lambda x} +1-\sum_{n=0}^{k-1}\frac{(\lambda x)^n}{n!}e^{-\lambda x}\\ &=1-\sum_{n=0}^k\frac{(\lambda x)^n}{n!}e^{-\lambda x}\\ &=\text{RHS} \end{align*}\]입니다. $\square$

4.10 uniform distribution

uniform distribution에 대해서도 이미 다룬 바가 있지만, 이번에는 PMF와 PDF, 평균과 분산에 대해 다시 봅니다.

$X$가 uniform한 이산확률분포이고 $X$가 가질 수 있는 값이 $x_1$, $x_2$, $\cdots$, $x_n$이면, 즉

\[X\sim\text{Unif}(x_1,x_2,\cdots,x_n)\]이면, $P(X=x_1)=P(X=x_2)=\cdots=P(X=x_n)$으로부터

\[P_X(x_i)=\frac1n\qquad(i=1,2,\cdots,n)\]로 $X$의 PMF가 결정됩니다. 만약 $X$가 uniform한 연속확률분포이고 $X$가 가질 수 있는 값이 $a\le X\le b$이면, 즉

\[X\sim\text{Unif}\left([a,b]\right)\]이면,

\[f_X(x)=c(a\le x\le b)\]이고

\[\int_a^bf_X(x)\,dx=1\]로부터

\[f_X(x)=\frac1{b-a}(a\le x\le b)\]입니다.

이산확률분포의 경우 $E[X]=\frac1n(x_1+\cdots+x_n)$, ${\sigma_X}^2=\frac1n\left(\sum_i(x_i-\mu_X)^2\right)$이어서 새로울 게 없습니다. 연속확률 변수의 경우의 평균과 분산은 $E[X]=\frac{a+b}2$, ${\sigma_X}^2=\frac{(a-b)^2}{12}$로 주어지는데, 직접 계산해보면

\[\begin{align*} E[X] &=\int_a^bxf_X(x)\,dx\\ &=\frac 1{b-a}\int_a^bx\,dx\\ &=\frac{a+b}2\\ {\sigma_X}^2 &=\int_a^bx^2f_X(x)\,dx-E[X]^2\\ &=\frac 1{b-a}\int_a^bx^2\,dx-\left(\frac{a+b}2\right)^2\\ &=\frac{a^2+ab+b^2}3-\frac{a^2+2ab+b^2}4\\ &=\frac{a^2-2ab+b^2}{12}\\ &=\frac{(a-b)^2}{12} \end{align*}\]입니다. 강의의 마지막에는 앞서 언급된 적이 있었던 digitization에서의 quantization에 대한 설명이 다시 나옵니다. quantization에서의 level 사이의 간격을 $\Delta$라고 할 때, quantization error $e$는

\[-\frac\Delta2\lt e\le\frac\Delta2\]와 같이 주어질텐데, 이때 $e$가 $[-\frac\Delta2,\frac\Delta2]$에서의 uniform distribution을 따른다고 가정한다는 것입니다. 그러면 $e$의 분산은

\[V[e]=\frac{\Delta^2}{12}\]으로 나타나게 될 것입니다. 이때, error의 분산은 전력(power, 평균 에너지의 크기)로 해석할 수 있다고 합니다. 신호의 실제값들의 표준편차를 $\sigma_S$라고 하면,

\[\log_{10}\left(\frac{\,{\sigma_S}^2}{\left(\frac\Delta{12}\right)^2}\right)\]은 SNR(신호 대 잡음비)의 값으로 정의할 수 있는데, 이 값은 db(데시벨)이라는 단위를 가지고 있다고 합니다.

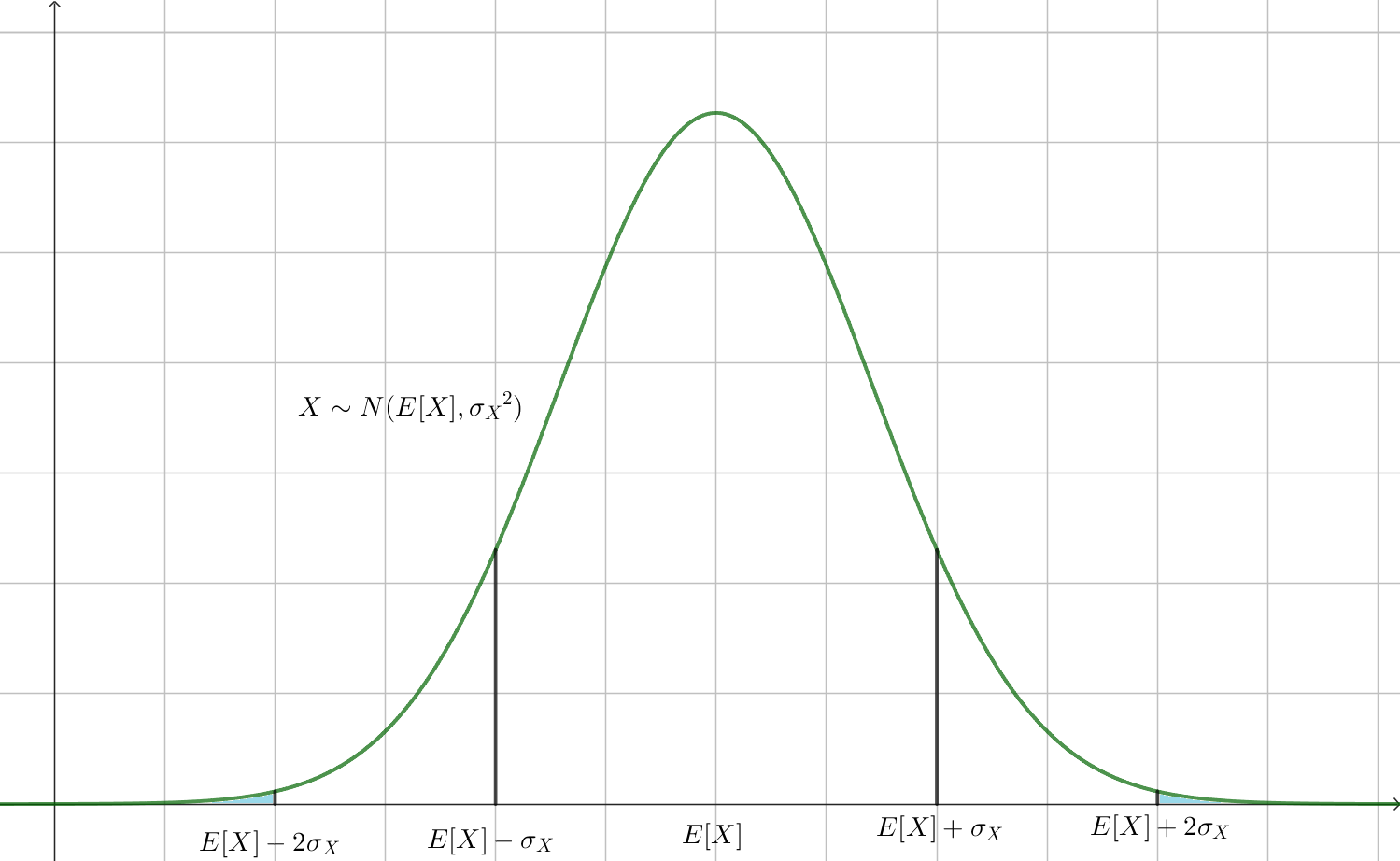

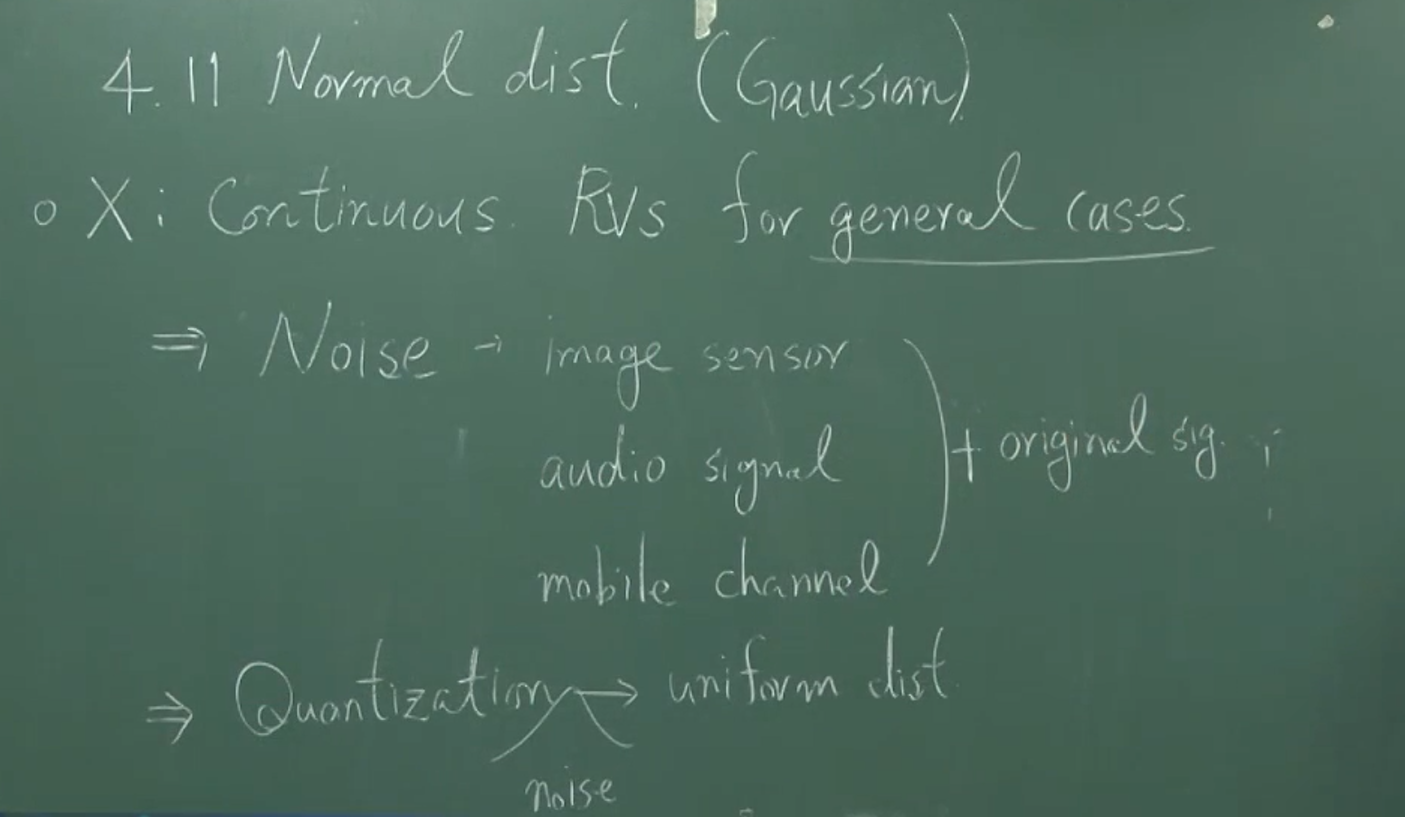

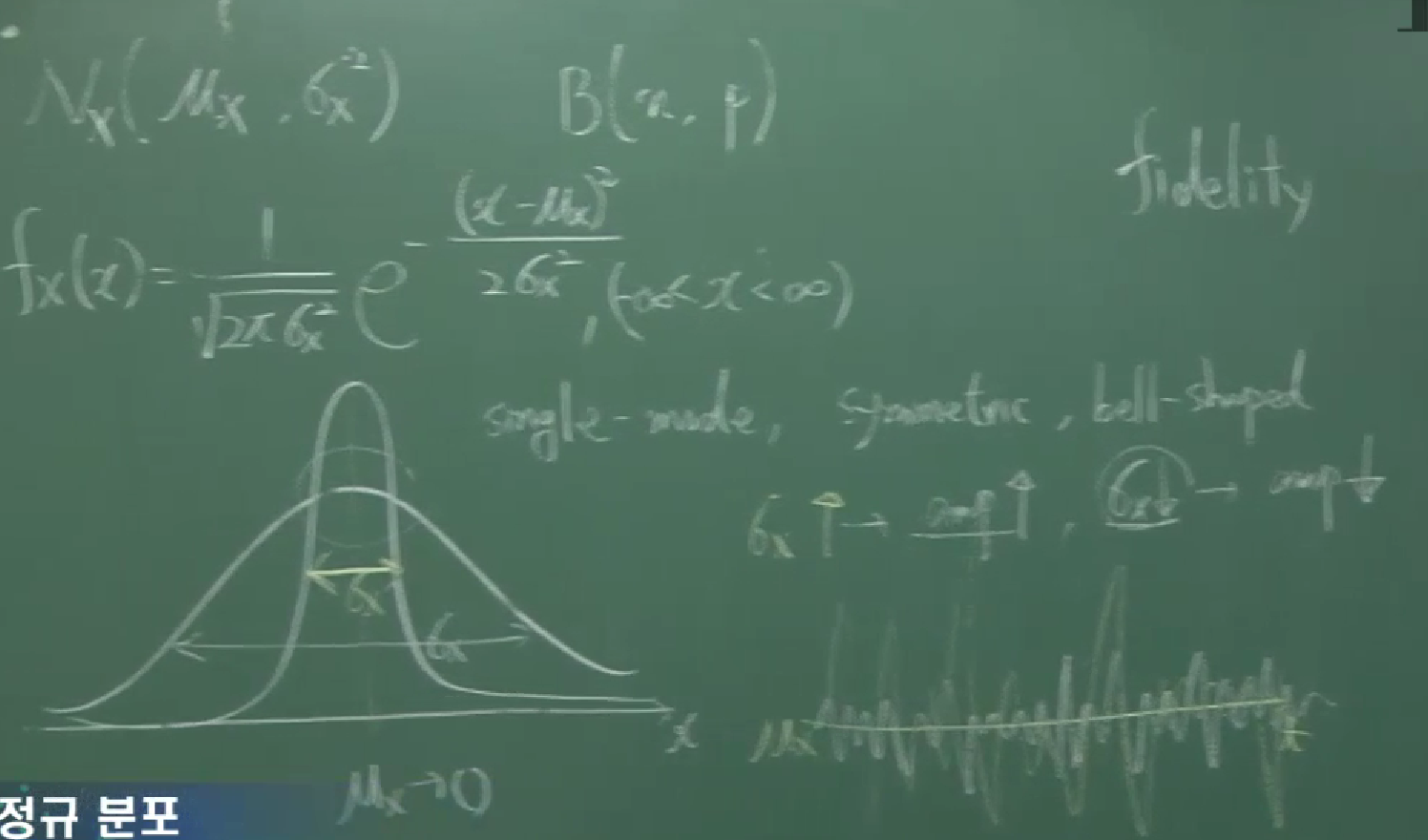

09 정규분포

연속확률변수 $X$가 확률밀도함수

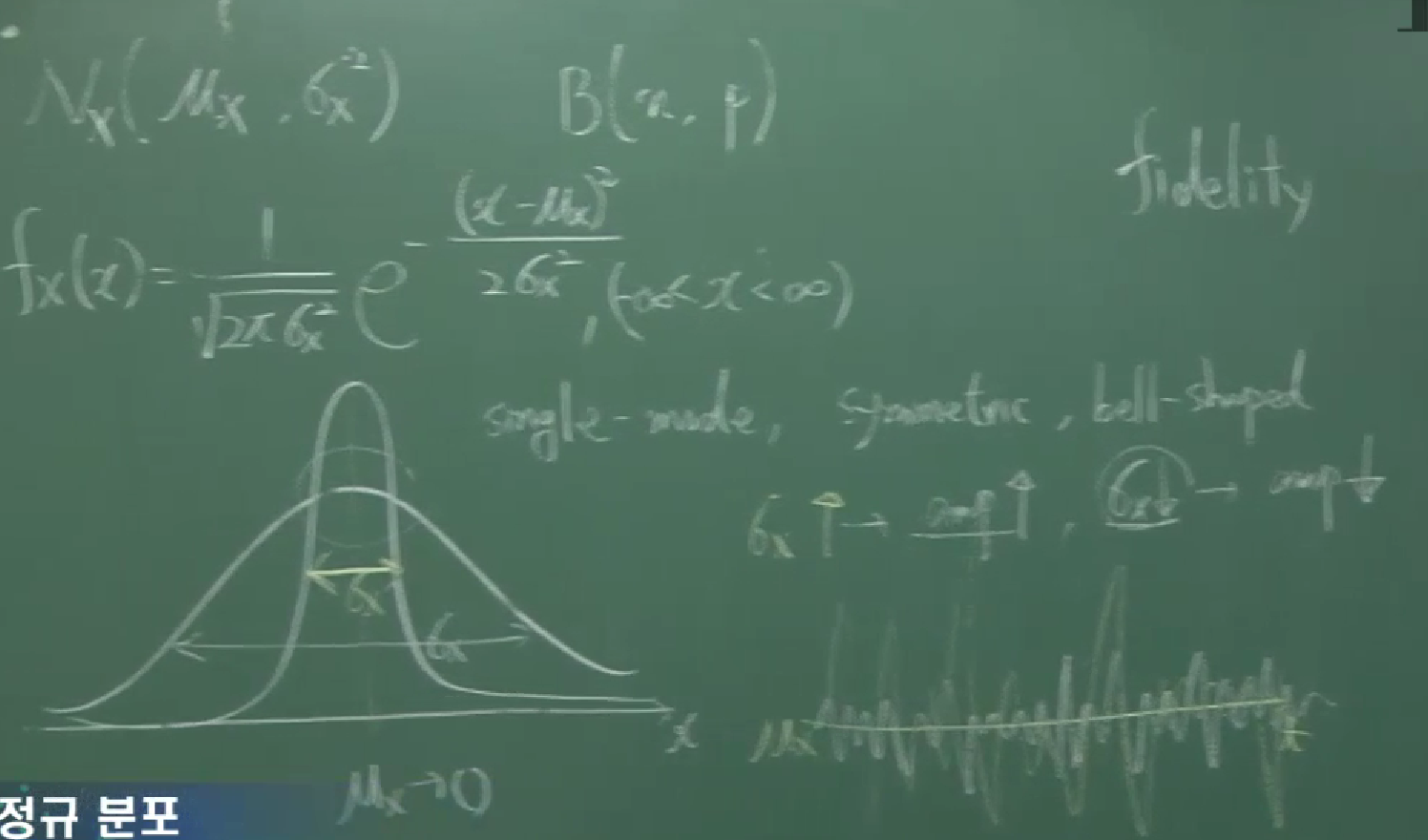

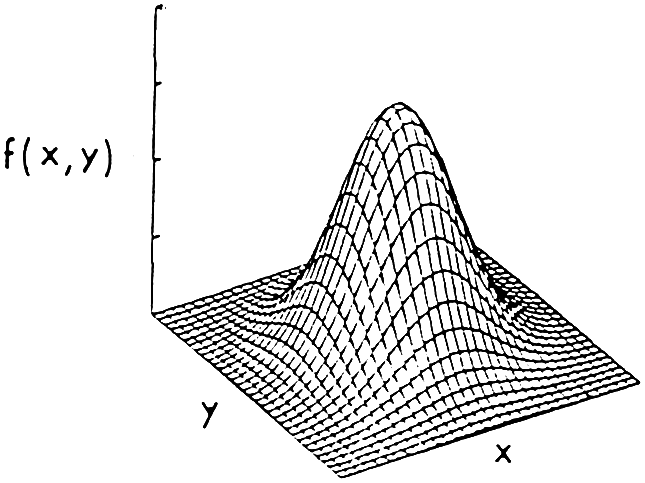

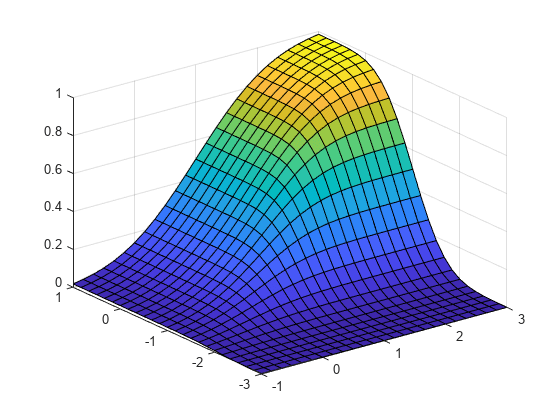

\[\tag{$\ast$} f_X(x)=\frac1{\sqrt{2\pi}\sigma_X}e^{-\frac{(x-{\mu_X})^2}{2{\sigma_X}^2}} \qquad(-\infty\lt x\lt\infty)\]를 가지면 $X$가 정규분포를 따른다고 하고 $X\sim N(\mu_X,{\sigma_X}^2)$라고 표시합니다. 이 PDF에 대하여 다음 세 사실이 성립합니다.

\[\begin{aligned} \int_{-\infty}^\infty f_X(x)\,dx&=1\\ E[X]&=\mu_X\\ V[X]&={\sigma_X}^2 \end{aligned} \tag{$\ast\ast$}\]이것을 직접 증명하는 것은 복잡하기 때문에, 먼저 $\mu=0$이고 $\sigma=1$인 경우를 보려고 합니다(standard normal distribution). 다시 말해,

\[f_U(u)=\frac1{\sqrt{2\pi}}e^{-\frac12u^2} \qquad(-\infty\lt x\lt\infty)\]로 주어진 연속확률변수 $U$에 대하여

\[\begin{aligned} \int_{-\infty}^\infty f_U(u)\,du&=1\\ E[U]&=0\\ V[U]&=1 \end{aligned} \tag{$\ast\ast\ast$}\]를 증명하려고 합니다.

먼저 $U$의 확률밀도함수를 실수 전체에 대해 적분했을 때 1이 된다는 사실을 먼저 증명하기 위해

\[A=\int_{-\infty}^\infty f_U(u)\,du\]로 두면, 극좌표계 변환에 의해

\[\begin{align*} A^2 &=\int_{-\infty}^\infty\frac1{\sqrt{2\pi}}e^{-\frac12u^2}\,du\times \int_{-\infty}^\infty\frac1{\sqrt{2\pi}}e^{-\frac12v^2}\,dv\\ &=\frac1{2\pi}\iint_{\mathbb R^2}e^{-\frac12(u^2+v^2)}\,du\,dv\\ &=\frac1{2\pi}\int_0^{2\pi}\int_0^\infty e^{-\frac12r^2}r\,dr\,d\theta\\ &=\frac1{2\pi}\int_0^{2\pi}d\theta\times \int_0^\infty e^{-\frac12r^2}r\,dr\\ &=\frac1{2\pi}\times 2\pi\times\int_0^\infty e^{-\frac12r^2}\,d\left(\frac12r^2\right)\\ &=\int_0^\infty e^{-R}\,dR\\ &=\left[-e^R\right]_0^\infty\\ &=1 \end{align*}\]입니다. 따라서 $A=1$입니다.

$U$의 평균을 계산하기 위해 똑같이 해보면

\[\begin{align*} E[U]^2 &=\int_{-\infty}^\infty\frac u{\sqrt{2\pi}}e^{-\frac12u^2}\,du\times \int_{-\infty}^\infty\frac v{\sqrt{2\pi}}e^{-\frac12v^2}\,dv\\ &=\frac1{2\pi}\iint uve^{-\frac12(u^2+v^2)}\,du\,dv\\ &=\frac1{2\pi}\int_0^{2\pi}\int_0^\infty r^2\cos\theta\sin\theta e^{-\frac12r^2}r\,dr\,d\theta\\ &=\frac1{2\pi}\int_0^{2\pi}\cos\theta\sin\theta\,d\theta\times \int_0^\infty r^3e^{-\frac12r^2}\,dr\\ &=\frac1{2\pi}\int_0^{2\pi}\frac12\sin(2\theta)\,d\theta \times\int_0^\infty \left(\frac12r^2\right)e^{-\frac12r^2}\,d\left(\frac12r^2\right)\times2\\ &=\frac1{2\pi}\times\left[-\frac14\cos(2\theta)\right]_0^{2\pi}\times \int_0^\infty Re^{-R}\,dR\times2\\ &=\frac1{2\pi}\times0\times1\times2\\ &=0 \end{align*}\]입니다. 따라서 $E[U]=0$입니다.

마지막으로 $U$의 분산을 계산해보면

\[\begin{align*} V[U] &=\int_{-\infty}^\infty\frac{(u-0)^2}{\sqrt{2\pi}}e^{-\frac12u^2}\,du\\ &=\int_{-\infty}^\infty\frac{u^2}{\sqrt{2\pi}}e^{-\frac12u^2}\,du \end{align*}\]이고

\[\begin{align*} V[U]^2 &=\int_{-\infty}^\infty\frac{u^2}{\sqrt{2\pi}}e^{-\frac12u^2}\,du\times \int_{-\infty}^\infty\frac{v^2}{\sqrt{2\pi}}e^{-\frac12v^2}\,dv\\ &=\frac1{2\pi}\iint u^2v^2e^{-\frac12(u^2+v^2)}\,du\,dv\\ &=\frac1{2\pi}\int_0^{2\pi}\int_0^\infty r^4\cos^2\theta\sin^2\theta e^{-\frac12r^2}r\,dr\,d\theta\\ &=\frac1{2\pi}\int_0^{2\pi}\cos^2\theta\sin^2\theta\,d\theta\times \int_0^\infty r^5e^{-\frac12r^2}\,dr\\ &=\frac1{2\pi}\int_0^{2\pi}\frac14\sin^2(2\theta)\,d\theta \times\int_0^\infty \left(\frac12r^2\right)^2e^{-\frac12r^2}\,d\left(\frac12r^2\right)\times4\\ &=\frac1{2\pi}\int_0^{2\pi}\frac18(1-\cos(4\theta))\,d\theta\times \int_0^\infty R^2e^{-R}\,dR\times4\\ &=\frac1{2\pi}\times\frac\pi4\times2\times4\\ &=1 \end{align*}\]따라서 $(\ast\ast\ast)$가 증명되었습니다. 이제 $(\ast\ast)$를 증명해보려고 합니다. 만약 확률변수 $X$가 $(\ast)$를 PDF로 가진다면 변수변환 $x=\sigma_Xu+\mu_X$에 의하여

\[\begin{align*} \int_{-\infty}^\infty f_X(x)\,dx &=\int_{-\infty}^\infty\frac1{\sqrt{2\pi}\sigma_X}e^{-\frac{(x-{\mu_X})^2}{2{\sigma_X}^2}}\,dx\\ &=\int_{-\infty}^\infty\frac1{\sqrt{2\pi}}e^{-\frac12u^2}\,du\\ &=1 \end{align*}\]입니다. 따라서 $(\ast\ast\ast)$의 첫번째 식이 증명되었습니다. 또한, 새로운 확률변수

\[U=\frac{X-\mu_X}{\sigma_X}\]는 standard normal입니다. ($U\sim N(0,1)$ 입니다.) 왜냐하면,

\[\begin{align*} F_U(u) &=P(U\le u)\\ &=P(\frac{x-\mu_X}{\sigma_X}\le u)\\ &=P(X\le\sigma_Xu+\mu_X)\\ &=F_X\left(\sigma_Xu+\mu_X\right)\\ f_U(u) &=\frac d{du}F_U(u)\\ &=\frac d{du}F_X\left(\sigma_Xu+\mu_X\right)\\ &=\sigma_Xf_X\left(\sigma_Xu+\mu_X\right)\\ &=\sigma_X\times\frac1{\sqrt{2\pi}\sigma_X}e^{-\frac12\left(\frac{x-\mu_X}{\sigma_X}\right)^2}\\ &=\frac1{\sqrt{2\pi}}e^{-\frac12\left(\frac{x-\mu_X}{\sigma_X}\right)^2} \end{align*}\]이기 때문입니다. 따라서

\[\begin{align*} E[X] &=E\left[\mu_X+\sigma_XU\right]\\ &=\mu_X+\sigma_XE[U]\\ &=\mu_X\\ {\sigma_X}^2 &=V\left[\mu_X+\sigma_XU\right]\\ &={\sigma_X}^2V[U]\\ &={\sigma_X}^2 \end{align*}\]입니다. 즉 $(\ast\ast)$의 나머지 두 식이 증명되었습니다. $\square$

강의에서는 여러 종류의 연속확률변수들이 근사적으로 정규분포를 따른다는 것이 언급되면서, 특히 어떤 신호의 signal이 정규분포를 따르는 경향이 있다는 사실도 소개됩니다. single mode, symmetric, bellshaped등의 성질들에 대해서도 언급됩니다.

여기에서 mode란 PDF의 극대점을 의미한다고 설명되고 있습니다. discrete case에서는 mode가 최빈값, 즉 PMF의 최대점을 의미합니다.

강의에서 위의 계산도 하는 것 같은데, $du\,dv=r\,dr\,d\theta$를 설명하기 위해 Jacobian matrix도 소개되고 있습니다. 다만 위에서 계산한 세 값 중 맨 위의 값만 계산하고 있습니다.

이외에도 표준정규분포, 표준정규분포표에 대해서도 소개되고 있습니다. 이때 $\Phi$를 표준정규분포의 CDF로 정합니다. 즉, $Z\sim N(0,1)$일 때,

\[\Phi(x)=F_Z(x)=P(Z\le x)=\int_{-\infty}^x\frac1{\sqrt{2\pi}}e^{-\frac{z^2}2}\,dz\]로 정의합니다.

approximation of binomial distributions

$X\sim B(n,p)$이고 $n$이 충분히 크면 $X\sim N(np,np(1-p))$으로 생각합니다.

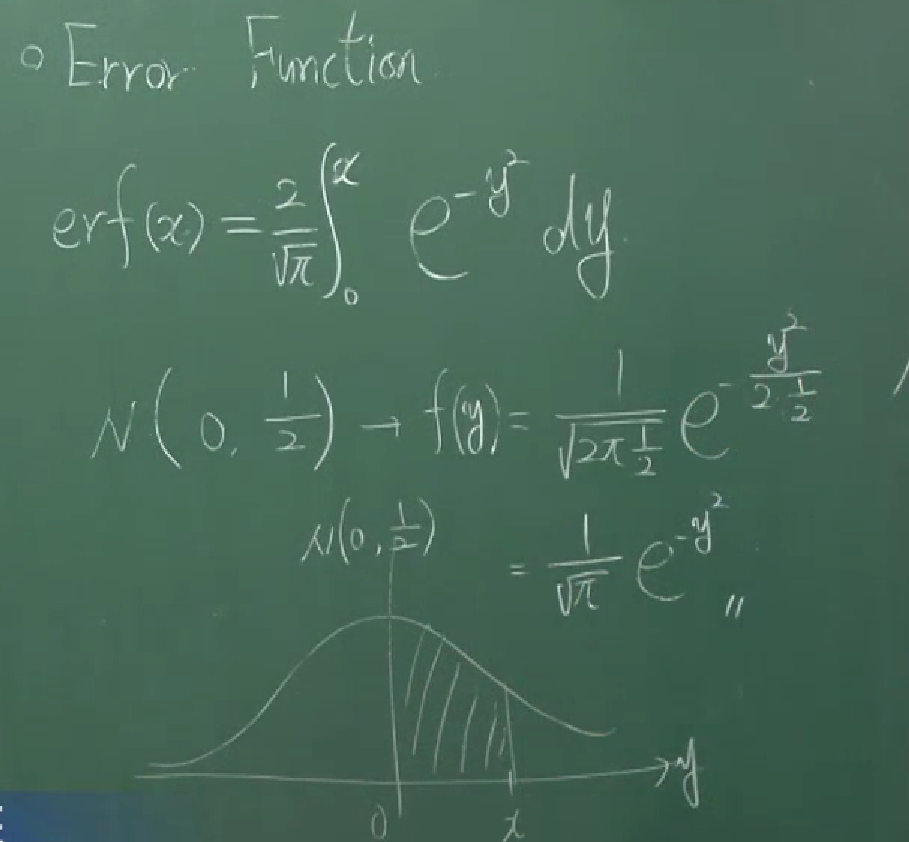

error function

\[\text{erf}(x)=\frac2{\sqrt\pi}\int_0^xe^{-y^2}\,dy.\]$X\sim N(0,\frac12)$이면, 이 함수는 $\text{er}f(x)=P(-x\lt X\le x)$인 함수입니다.

complementary error function

\[\text{erfc}(x)=\frac2{\sqrt\pi}\int_x^\infty e^{-y^2}\,dy.\]$\text{erfc}$ 함수는 $\text{erf}$ 함수와 complementary한 관계가 있습니다. 다시 말해서

\[\text{erf}(x)+\text{erfc}(x)=1\]입니다.

또한,

\[\begin{align*} \text{erf}(x) &=2P(0\le X\le x)\\ &=2P\left(0\le Z\le\sqrt2x\right)\\ &=2\left(\Phi(\sqrt2x)-\frac12\right)\\ &=2\Phi(\sqrt2x)-1 \end{align*}\]이고, 반대로

\[\Phi(x)=\frac12+\frac12\text{erf}\left(\frac{x}{\sqrt2}\right)\]입니다.

Gaussian mixture model

$X_1\sim N(\mu_1,{\sigma_1}^2)$, $X_2\sim N(\mu_2,{\sigma_2}^2)$일 때,새로운 확률변수 $\alpha X_1+\beta X_2$는 하나의 mode를 가지지 않고 두 개의 mode를 가질 수 있습니다(bimodal).

일반적으로, 서로 다른 정규분포를 따르는 $n$개의 확률변수 $X_i$에 대하여 $X_i$들의 일차결합은 여러 개의 mode를 가질 수 있습니다(multimodal).

이 확률변수를 가지고 만들 수 있는 모델을 Gaussian mixture model이라고 하는 것 같습니다. sklearn에서는 다음과 같은 설명을 하고 있습니다.

A Gaussian mixture model is a probabilistic model that assumes all the data points are generated from a mixture of a finite number of Gaussian distributions with unknown parameters.

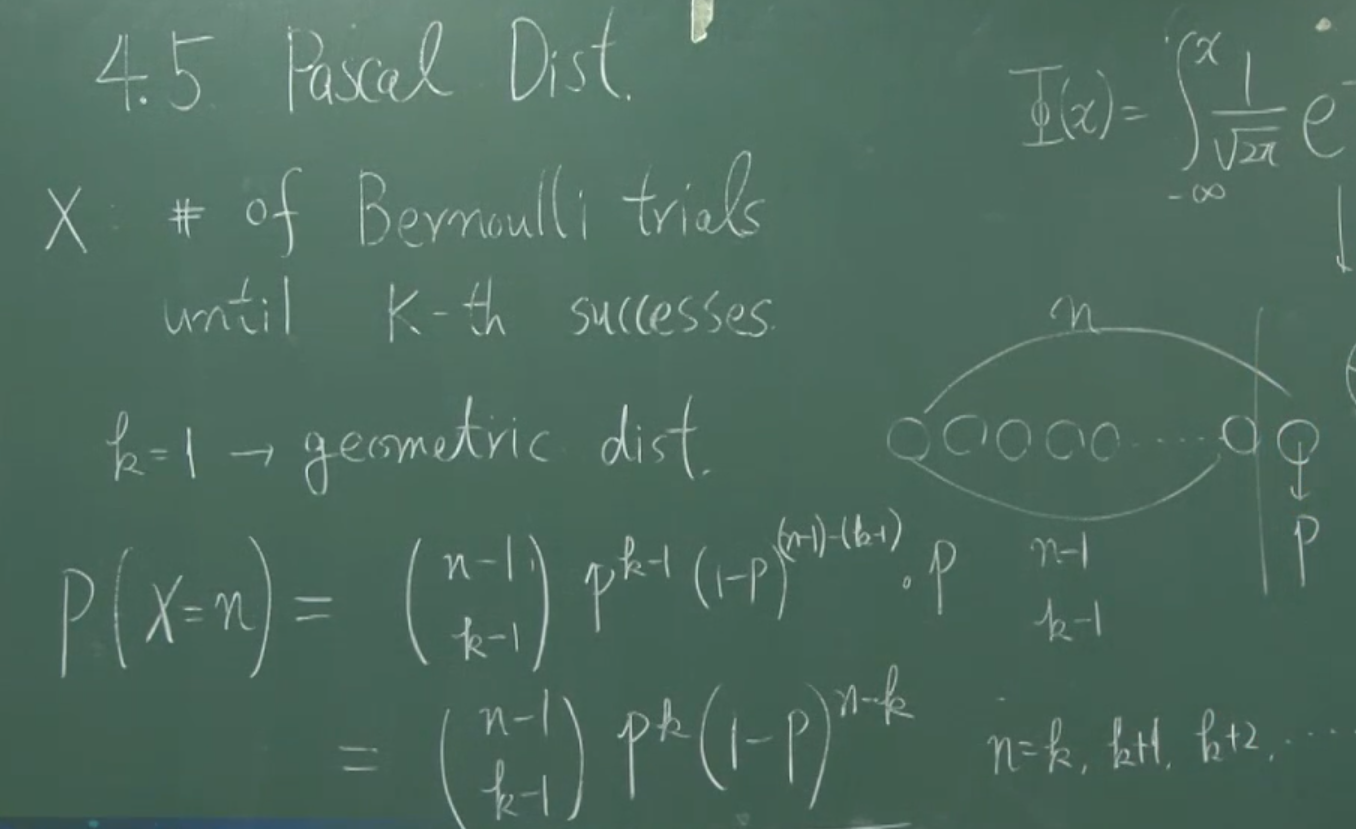

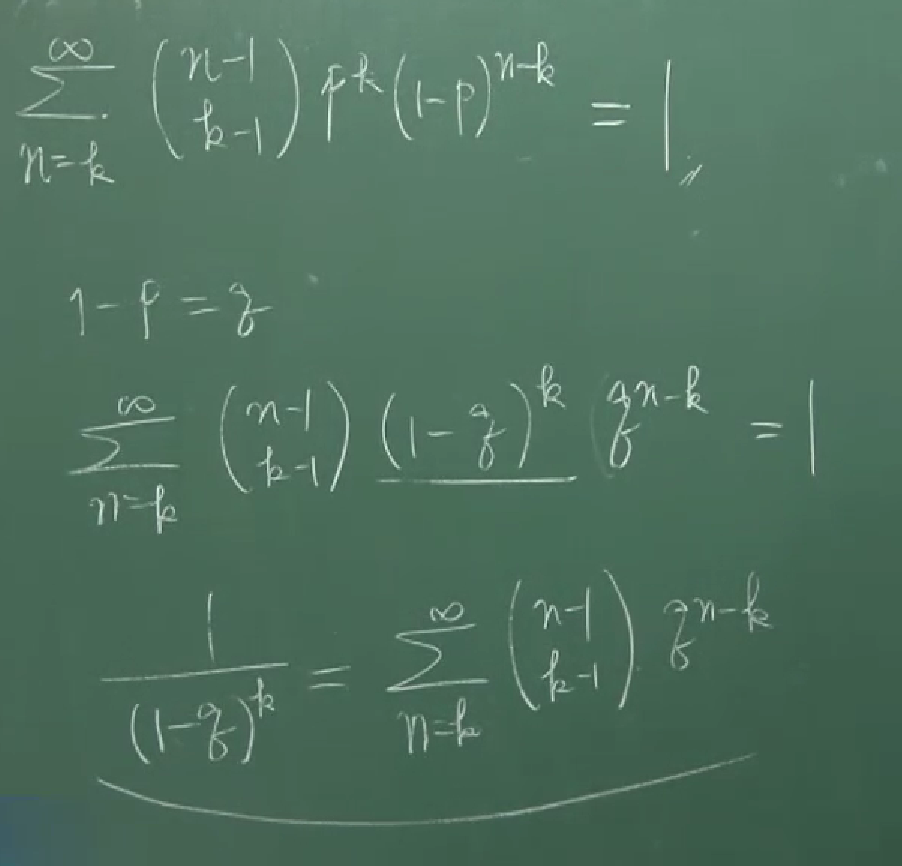

4.5 Pascal distribution (Negative binomial distribution)

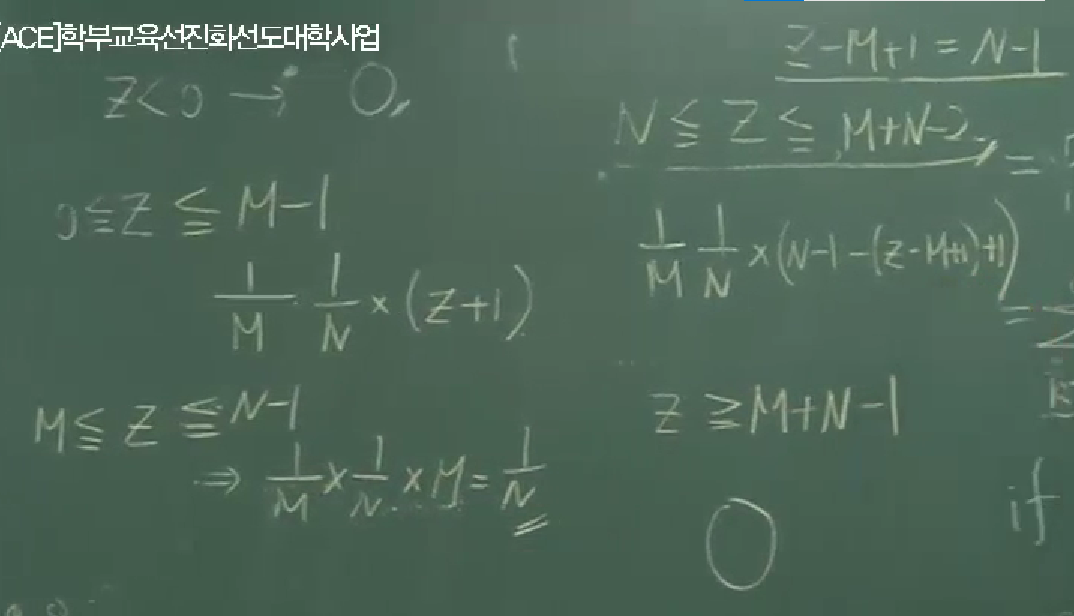

강의의 마지막에는 Pascal distribution에 대한 설명이 간략하게 있습니다. 이에 관해서는 칠판에 적힌 캡쳐로 간단하게 갈음하겠습니다.

강의의 내용은 여기까지입니다. 하지만, 정규분포가 워낙 중요한 분포이고 나중에 사용할 수 있는 중요한 성질들이 언급되어있지 않기 때문에, 조금 더 적어보려고 합니다. 여기에 적어볼 사실은 다음과 같습니다.

(b) 두 확률변수 $X\sim N(\mu_X,{\sigma_X}^2)$, $Y\sim N(\mu_Y,{\sigma_Y}^2)$ 가 독립이면 $$aX+bY+c\sim N\left(a\mu_X+b\mu_Y+c,a^2{\sigma_X}^2+b^2{\sigma_Y}^2\right).$$ 이 성립합니다.

(a)에서 등장하는 $M_X$라는 함수는 moment generating function이라고 불립니다. 즉 (a)의 내용은, 정규분포가 moment generating function을 통해 설명(characterize)될 수 있다는 것입니다. (b)는 정규분포를 따르며 독립인 확률변수들의 일차결합이 여전히 정규분포를 따른다는 중요한 사실을 이야기하고 있습니다. 이것들에 대한 증명을 시작하기 전에, 먼저 moment generating function에 대해 간략하게 설명해보겠습니다.

$X$가 확률변수일 때, $$M_X(t)=E\left[e^{tX}\right]$$ 를 $X$의 moment generating function이라고 합니다. 이것을 활용하면, $X$의 $n$th moment를 쉽게 계산할 수 있습니다; $${M_X}^{(n)}(0)=E[X^n]$$

이에 대한 증명은 다음과 같습니다. 아래 계산에서 등장하는 급수들은 모두 적당히 잘 수렴한다고 가정합니다. $e^{tX}$에 Maclaurin series를 적용하면

\[\begin{align*} M_X(t) &=E\left[e^{tX}\right]\\ &=E\left[1+tX+\frac{t^2X^2}{2!}+\frac{t^3X^3}{3!}+\cdots\right]\\ &=1+tE[X]+\frac{t^2}{2!}E[X^2]+\frac{t^3}{3!}E[X^3]+\cdots \end{align*}\]입니다. 따라서

\[\begin{align*} M_X'(t)&=E[X]+tE[X^2]+\frac{t^2}{2!}E[X^3]+\frac{t^3}{3!}E[X^4]+\cdots\\ M_X''(t)&=E[X^2]+tE[X^3]+\frac{t^2}{2!}E[X^4]+\frac{t^3}{3!}E[X^5]+\cdots\\ &\vdots\\ M_X^{(n)}(t)&=E[X^n]+tE[X^{n+1}]+\frac{t^2}{2!}E[X^{n+2}]+\frac{t^3}{3!}E[X^{n+3}]+\cdots. \end{align*}\]이고

\[M_X^{(n)}(0)=E[X^n].\]입니다. $\square$

확률변수 $X$에 대하여 그에 대응하는 moment generating function $M_X$는 유일(unique)하다고 알려져있습니다. 다시 말해, 새로운 확률변수 $X'$이 $M_X=M_{X'}$을 만족시키면, $X$와 $X'$의 분포는 같습니다. 이에 대한 증명은 생략하겠지만, 이 사실은 매우 유용하게 쓰일 수 있습니다.

이제 (a)를 증명해보겠습니다. 먼저 $\Rightarrow$ 방향입니다.

$X\sim N(\mu,\sigma^2)$를 가정하면

\[\begin{align*} M_X(t) &=E[e^{tX}]\\ &=\int_{\mathbb R}e^{tx}\times\frac1{\sqrt{2\pi}\sigma}\exp\left(-\left(\frac{x-\mu}{\sqrt2\sigma}\right)^2\right)\,dx\\ &=\frac1{\sqrt{2\pi}\sigma}\int_{\mathbb R}\exp\left(tx-\left(\frac{x-\mu}{\sqrt2\sigma}\right)^2\right)\,dx. \end{align*}\]입니다.

변수변환 $u=\frac{x-\mu}{\sqrt2\sigma}$ 을 하면 $dx=\sqrt2\sigma\,du$ 이므로

\[\begin{align*} M_X(t) &=\frac1{\sqrt{2\pi}\sigma}\int_{\mathbb R}\exp\left(t(\mu+\sqrt2\sigma u)-u^2\right)\times\sqrt2\sigma\,du.\\ &=\frac{e^{\mu t}}{\sqrt\pi}\int_{\mathbb R}\exp\left(\sqrt2\sigma tu-u^2\right)\,du.\\ &=\frac{e^{\mu t}}{\sqrt\pi}\int_{\mathbb R}\exp\left(-\left(u-\frac{\sigma t}{\sqrt2}\right)^2+\frac{\sigma^2t^2}2\right)\,du.\\ \end{align*}\]입니다. 다시, 변수변환 $v=u-\frac{\sigma t}{\sqrt2}$를 적용하면

\[\begin{align*} M_X(t) &=\frac{e^{\mu t+\frac12\sigma^2t^2}}{\sqrt\pi}\int_{\mathbb R}\exp\left(-v^2\right)\,du\\ &\stackrel{\star}=\frac{e^{\mu t+\frac12\sigma^2t^2}}{\sqrt\pi}\times\sqrt\pi\\ &=e^{\mu t+\frac12\sigma^2t^2}. \end{align*}\]이 됩니다. 이때, $\star$는 $\langle09\rangle$의 서두에 등장했던 이중적분과 좌표변환을 통해 얻을 수 있습니다.

(a)의 반대방향($\Leftarrow$)은 $M_X$가 유일하다는 것으로부터 당연합니다. 즉, 만약 확률변수 $Y$가 $M_Y(t)=\exp\left(\mu t+\frac12\sigma^2t^2\right)$를 만족시키는 확률변수여서 (a)의 오른쪽 조건이 성립한다면, $M_X=M_Y$가 성립합니다. 그런데 moment generating function의 유일성으로부터 $Y$와 $X$의 분포는 같습니다. 그러므로 $Y\sim N(\mu,\sigma^2)$이고, (a)의 왼쪽조건이 성립합니다. 따라서 (a)의 $\Leftarrow$ 방향도 증명되었습니다.

이번엔 (b)에 대한 증명입니다. (a)의 $\Rightarrow$방향과 moment generating function의 정의, 그리고 독립인 확률변수들의 성질로부터

\[\begin{align*} M_{aX+bY+c}(t) &=E\left[e^{(aX+bY+c)t}\right]\\ &=E\left[e^{aXt}e^{aYt}e^{ct}\right]\\ &\stackrel{\star\star}=E\left[e^{X(at)}\right]E\left[e^{Y(bt)}\right]E\left[e^{ct}\right]\\ &=M_X(at)\times M_Y(bt)\times e^{ct}\\ &=\exp\left(\mu_X(at)+\frac12{\sigma_X}^2(at)^2\right)\times\exp\left(\mu_Y(bt)+\frac12{\sigma_Y}^2(bt)^2\right)\times\exp(ct)\\ &=\exp\left((a\mu_X+b\mu_Y+c)t+\frac12\left(a^2{\sigma_X}^2+b^2{\sigma_Y}^2\right)t^2\right) \end{align*}\]입니다. 이때 $\star\star$는 $X$와 $Y$가 독립이라는 사실 때문에 그렇습니다. 즉, 두 함수 $f$, $g$에 대하여

\[E[f(X)g(Y)]=E[f(X)]E[g(Y)]\]가 성립하는데, 이것은 $\langle12\rangle$에서 증명됩니다. 다시 증명으로 돌아와보면, (a)의 $\Leftarrow$ 방향으로부터 $aX+bY+c$가 평균이 $a\mu_X+b\mu_Y+c$ 이고 분산이 $a^2{\mu_X}^2+b^2{\mu_Y}^2$인 정규분포를 따른다는 것을 알 수 있습니다. 이것으로 (b)에 대한 증명이 끝났습니다$\square$

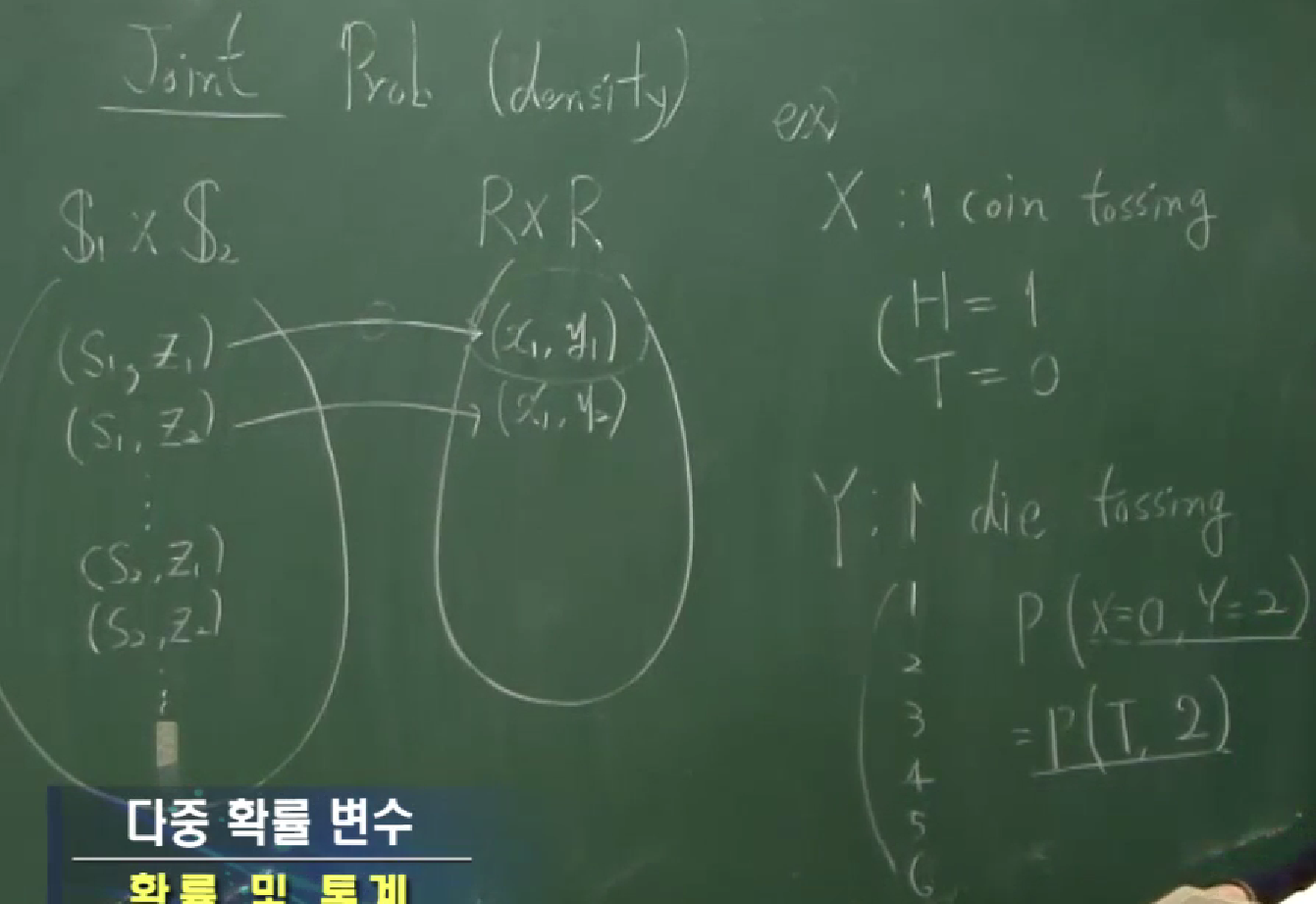

10 다중변수 및 연합분포

이번 강의에서는 단일변수에 대한 분포가 아닌 다중변수에 대한 분포를 다룹니다. 단일변수에 대한 정의를 다시 떠올려보면, 원래 확률공간(probability space)이란, $(S,\Sigma,P)$이었습니다. $S$는 sample space로 그냥 하나의 집합이었고 $\Sigma$는 $\sigma$-algebra로서 $S$의 부분집합(사건)들의 집합 중에서 특정한 성질을 만족시키는 것들이었으며 $P:\Sigma\to[0,1]$는 probability measure로서 전사건에 대한 값이 1인 finite measure입니다. 그러니까, $P(A)$라고 할 때, $A$는 $S$의 부분집합, 즉 ‘사건’입니다. 그런데, 집합에 대한 함수를 다루기보다는 숫자에 대한 함수를 다루기 위해 확률변수라는 걸 도입하게 됩니다. 확률변수란, $X:S\to\mathbb R$인 함수 $x=X(w)$로 정의됩니다. 이를 통해

\[P(X=x)=P_X(x)\]와 같은 표현을 ($P_X$는 확률질량함수, PMF)

\[P(X=x)=P\left(\{w\in S:X(w)=x\}\right)=P\left(X^{-1}(\{x\})\right)\]로 정의하고

\[P(a\le X\le b)=\int_a^bf_X(x)\,dx\]와 같은 표현을 ($f_X$는 확률밀도함수, PDF)

\[P(a\le X\le b)=P\left(\{w\in S:a\le X(w)\le b\}\right)=P\left(X^{-1}([a,b])\right)\]로 정의하면 두 식 $P(X=x)$, $P(a\le X\le b)$은 잘 정의됩니다. 실제 강의에서는 $\sigma$-algebra라든지 probability measure에 대한 설명은 없이 진행됐습니다.

이번 강의에서는 두 확률변수 $X$, $Y$에 대하여

\[P(X=x, Y=y)\]라든지

\[P(X\le x, Y\le y)\]를 어떻게 정의할지 하는 문제를 다룹니다.

두 확률변수 $X:S_1\to\mathbb R$, $Y:S_2\to\mathbb R$를 고려한다고 해서 이 둘의 cartesian product를 확률변수로 놓을 수는 없습니다. $X\times Y:S_1\times S_2\to\mathbb R^2$을 $(X\times Y)(w_1,w_2)=(X(w_1),Y(w_2))$로 정의한다고 하면 이것은 공역이 $\mathbb R^2$이므로 확률변수라고 할 수 없기 때문입니다. 하지만, 순서쌍 $(X(w_1),Y(w_2))$에 대한 분포는 생각해볼 수 있습니다.

위에 언급한 값들을